La HBM4 llegará con importantes mejoras respecto a la generación anterior de memoria HBM. Y esto podría sacudir el mercado de la memoria. Pero… ¿podría poner en apuros a la DDR5 y a la GDDR7 en el apartado gráfico? Vamos a analizar todas estas nuevas tecnologías y resolver algunas dudas sobre ello.

¿Qué es la HBM?

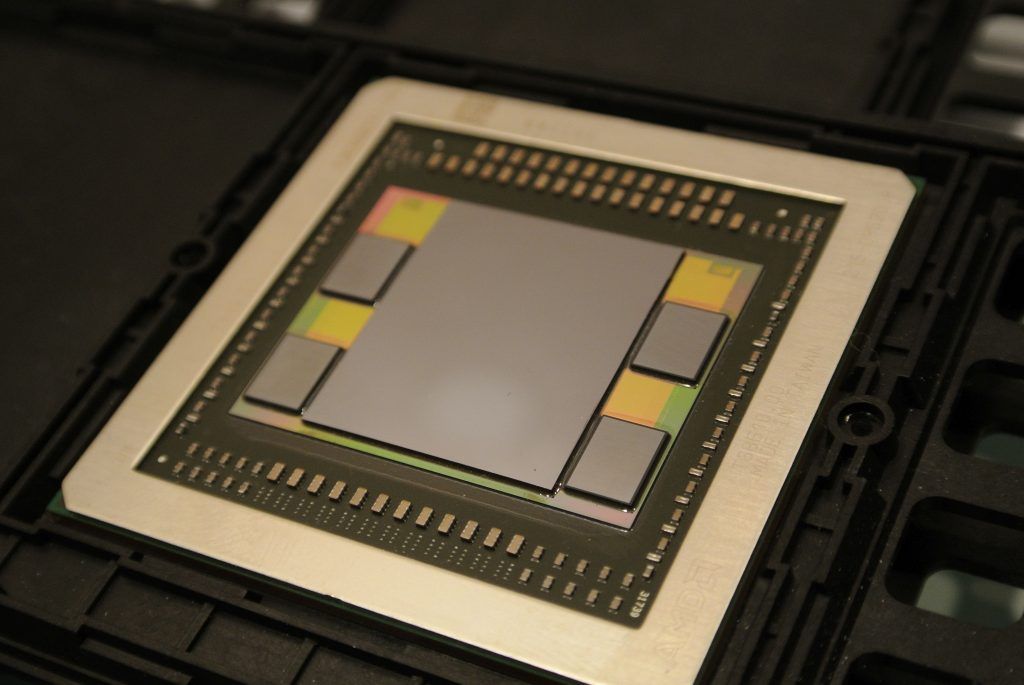

HBM (High Bandwidth Memory), es un tipo de memoria RAM (Random Access Memory) de alto ancho de banda que se utiliza en tarjetas gráficas, aceleradores y CPUs de alto rendimiento para ofrecer un ancho de banda de memoria extremadamente alto. Esta tecnología fue desarrollada por AMD en colaboración con Hynix y está diseñada para satisfacer las demandas de los sistemas de gráficos de alto rendimiento y de uso intensivo de datos, como las cargas de IA, entre otras.

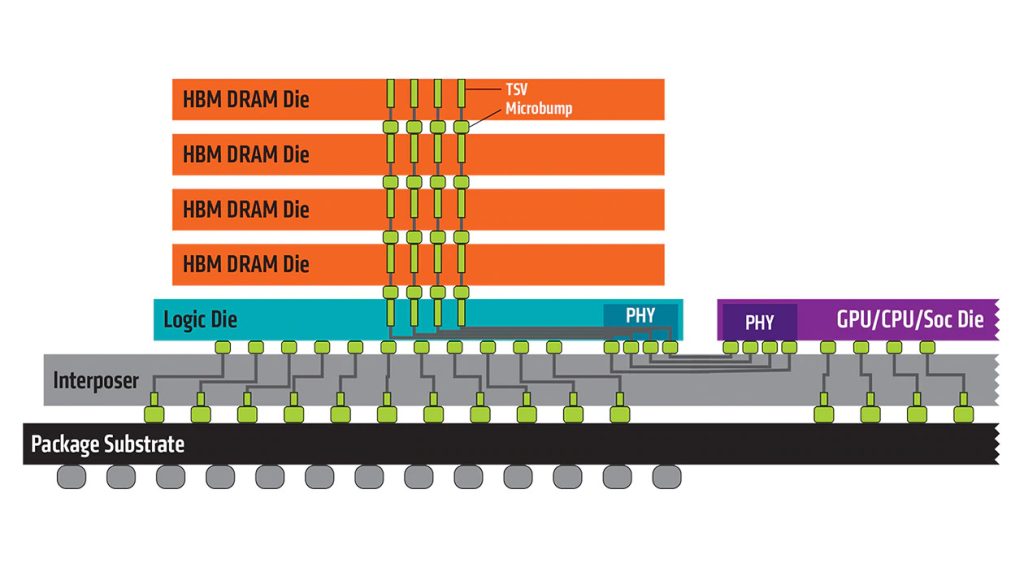

La HBM ofrece un mayor ancho de banda que la DDR, y consume menos energía, lo que son dos grandes ventajas. Esto se logra apilando varios chips de DRAM mediante tecnología de empaquetado 3D. De esta forma, tenemos un bus de acceso a la memoria muy ancho. Por ejemplo, una pila HBM de 4 chips DRAM (4-Hi) tendría dos canales de 128-bit por cada chip, lo que es un total de 8 canales con un total de 1024-bit.

AMD fue la pionera en usarla en sus tarjetas gráficas Fiji (Radeon R9 Fury X) , aunque después de esta generación desechó esta idea para volver a la GDDR. También algunas tarjetas de NVIDIA para HPC han usado este tipo de memoria, como es el caso de la Tesla P100 y Hopper GH100. Intel también la ha empleado en sus Xeon Phi, aunque era una versión denominada HCDRAM de Micron, pero no deja de ser la versión HBM de Micron. Por otro lado, Fujitsu también la usó para su CPU de alto rendimiento A64FX, basada en Arm y que estuvo con el supercomputador Fugaku ocupando el puesto 1 de la lista Top500. Algunos Intel Xeon (Sapphire Rapids) y AMD EPYC (Genoa) también podría beneficiarse de ella, e incluso el NEC SX-Aurora TSUBASA.

Su adopción ha contribuido significativamente a la mejora del rendimiento, y con las nuevas generaciones de HBM, HBM2, HBM3 y HBM4, las cosas se están poniendo muy interesantes…

Ventajas y desventajas de la HBM

La HBM cuenta con grandes ventajas si se compara con la DDR y la GDDR, y puede usarse para los mismos fines que estas. Entre las ventajas encontramos:

- Menor consumo energético, al ser más eficientes.

- Factor de forma más pequeño, al estar apiladas, ofrece mayor densidad por unidad de superficie.

- Gran ancho de banda y velocidad de transferencias de datos.

Sin embargo, como puedes imaginar, no todo son ventajas, también tiene sus desventajas:

- Limitaciones en cuanto a capacidad de memoria, por tanto, no es tan escalable como la DDR.

- Es más cara de fabricar.

- Presentan una alta latencia de acceso, lo cual no es positivo.

- Debido a su alta densidad por los chips apilados, podrían necesitar refrigeración activa.

HBM4: especificaciones técnicas

Samsung ya ha anunciado que está desarrollando la memoria HBM4, la próxima generación que deberá llegar a la fabricación en masa para el mercado en 2025. Esta memoria permitirá ofrecer un mayor rendimiento en HPC y cargas de IA, y podrá ser usada en aceleradores como las tarjetas AMD Instinct y las alternativas de NVIDIA.

La próxima generación de memorias HBM4 presentará un considerable incremento en el ancho de bus, duplicando los actuales 1024-bit y pasando a 2048-bit. Además, hay que recordar que la última que ha salido por el momento, la HBM3E alcanza transferencias de 9.8 Gbps, o 9 GT/s, y la HBM4 duplicará el ancho de banda máximo por pila desde los 1.15 TB/s actuales a los 2.30 TB/s por pila…

HBM4 vs DDR5: ¿Por qué no usar HBM para la CPU del PC?

Muchos se estarán preguntando si no se podría usar la HBM4 que aparecerá en 2025, o incluso una versión actual como la HBM3 para la CPU en vez de la DDR5, que estará bastantes años con nosotros, ya que la DDR6 no se espera hasta 2026 siendo muy optimistas, o 2029 si atendemos a otras fechas anunciadas por otros fabricantes.

Pues bien, hay que decir que, en principio, la HBM se podría usar para la CPU como sustituta de la DDR, e incluso se podría buscar algo similar a los módulos DIMM para colocar la HBM, aunque éstos módulos deberían tener una interfaz que aceptase muchos más contactos que los de una DDR. No obstante, los casos que hemos visto en la práctica han sido más para aceleradores y GPUs que para otros dispositivos. Pero tenemos el caso del Fujitsu A64FX, que sustituye la RAM convencional por HBM2. Entonces ¿por qué no lo hacen otros como Intel o AMD para PC?

Pues bien, los problemas por los que HBM no ha sustituido a la DDR en el mundo del PC son:

- El precio de producir la HBM es superior a la de la DDR, y dado que las CPUs para PC no necesitan tanto ancho de banda como las de HPC, no compensaría esta sustitución.

- Además, en los ejemplos como el A64FX, las pilas de HBM están en el mismo empaquetado, alrededor de la CPU, en forma de chiplets, y esto haría que los procesadores para PC incrementasen su precio enormemente, y la separación en módulos como los DIMM debería llevar a los diseñadores a crear nuevos slots de conexión para todas las líneas necesarias para la HBM debido a su ancho de banda y nuevas interfaces PHY para esta memoria. Además, estos chips tienden a calentarse más, lo que haría que estos módulos necesitasen algo más que una refrigeración pasiva.

- Luego está el límite de la capacidad de la HBM, que no se puede escalar de la misma forma que los módulos de memoria RAM DDR, consiguiendo mayores capacidades necesarias para el software actual.

- Por otro lado, las CPUs de PC no necesitan anchos de banda tan elevados, con los anchos ofrecidos por una DDR4 o DDR5 es suficiente, así que no tendría demasiado sentido usar memorias HBM, a no ser que sean modelos como el AMD Threadripper (u otros casos con iGPU, como las APUs), similar al EPYC, y con un número de núcleos tal que tal vez podría ser beneficioso usar un ancho de banda mayor.

- La latencia de esta memoria HBM es superior a la DDR, algo negativo para la CPU, que necesita latencias bajas para el acceso rápido a la memoria principal. Algunos aseguran que la latencia conseguida en la HBM es similar a la DDR, como es el caso de Xilinx (AMD) en sus FPGAs, pero en la mayoría de casos, la DDR puede ganar en latencia a la HBM.

- Además, los modelos de CPU que usan HBM tienen las pilas alrededor de ellos, como he comentado, lo que obtiene un beneficio de eficiencia en las transmisiones, pero si se colocasen en módulos aparte, como la actual RAM, esta ventaja desaparecería por completo al tener que recorrer distancias más largas, lo que significa un consumo (W/bit) mayor en la transmisión.

En definitiva, usar HBM en la CPU no tendría demasiado sentido, ya que la CPU es más sensible a la latencia en los accesos aleatorios a la memoria RAM, por lo que en muchos casos una baja latencia es más importante que un alto ancho de banda. Y, con los nuevos avances, como la 3D V-Cache de AMD, se puede conseguir capacidades de memoria caché más elevadas, lo que hace que importe aún menos la RAM.

Podría ser una mejor idea para usar como VRAM en la GPU, ya que traería beneficios en los videojuegos o tareas altamente predecibles, así como en la IA. Ya lo hizo AMD como he comentado anteriormente, pero por cuestiones de menor flexibilidad, limitaciones de capacidad y mayores costes, la GDDR sigue pareciendo mejor opción.

No obstante, hay que decir que esto es ahora, pero en un futuro nunca se sabe qué pasará. Tal vez cuando las CPUs para PC tengan más y más núcleos y necesiten un mayor ancho de banda de la memoria principal, la HBM se vuelva una solución aceptable…

Comprender las diferencias entre DDR y GDDR

Aunque muchos piensen que la DDR y la GDDR son lo mismo, solo que la DDR se usa como memoria RAM para la CPU y la GDDR para VRAM de la GPU, lo cierto es que también tienen algunas diferencias notables que hay que conocer:

- DDR: está diseñada para obtener una mayor velocidad, con mayores frecuencias de reloj, y la mínima latencia posible. En esto se prioriza cuando se diseña una memoria de este tipo, y con anchos de bus más pequeños, que usualmente pueden ser de 128-bit en las CPUs convencionales. Eso es suficiente para obtener un buen rendimiento de acceso a memoria para traer las instrucciones y los datos a la CPU para su procesamiento.

- GDDR: es cierto que tiene muchas similitudes, y que se basa en la DDR, pero especialmente diseñada para gráficos. Esta GDDR se diferencia de la DDR en priorizar un ancho de banda superior. Y es que las GPUs, a diferencia de la CPU, necesitan un mayor ancho de banda para las numerosas operaciones matemáticas que realizan sobre una cantidad enorme de datos. Estas cargas de trabajo repetitivas y lineales para los gráficos o la IA, supondrían un gran cuello de botella para una DDR convencional, pero los mayores anchos de banda de estas memorias VRAM hacen que no sea así.

Por ejemplo, mientras que una interfaz entre CPU-RAM DDR puede ser de 128-bit, en el caso de la GDDR para GPU tenemos anchos de bus de 384-bit en el caso de la GDDR6 para la AMD Radeon RX 7900 XTX, o la NVIDIA GeForce RTX 4090. El resultado que tenemos es que una DDR5 6400 tendría un ancho de banda de 88 GB/s en lecturas y en la RTX 4090 tenemos 1008 GB/s.

Apple, en contra de Intel y AMD, sí que está usando buses de memoria más anchos. Aunque el M2 usa también 128-bit, el M2 Pro tiene un bus de 256-bit, el M2 Max de 512-bit y el M2 Ultra de 1024-bit. El resultado es que el ancho de banda del M2 Ultra es de 800 GB/s, más similar al de una tarjeta gráfica. Sin embargo, ten en cuenta que es un SoC, y que dentro tenemos la CPU y también la GPU…

GDDR7: especificaciones técnicas

Algunos rumores apuntan a que las futuras tarjetas gráficas AMD Radeon RX 8000 Series y las NVIDIA GeForce RTX 50 Series podrían usar memoria VRAM tipo GDDR7, aunque podría no llegar a estos productos hasta 2025 según otros rumores. Pero veamos qué ofrece esta memoria en cuanto a rendimiento.

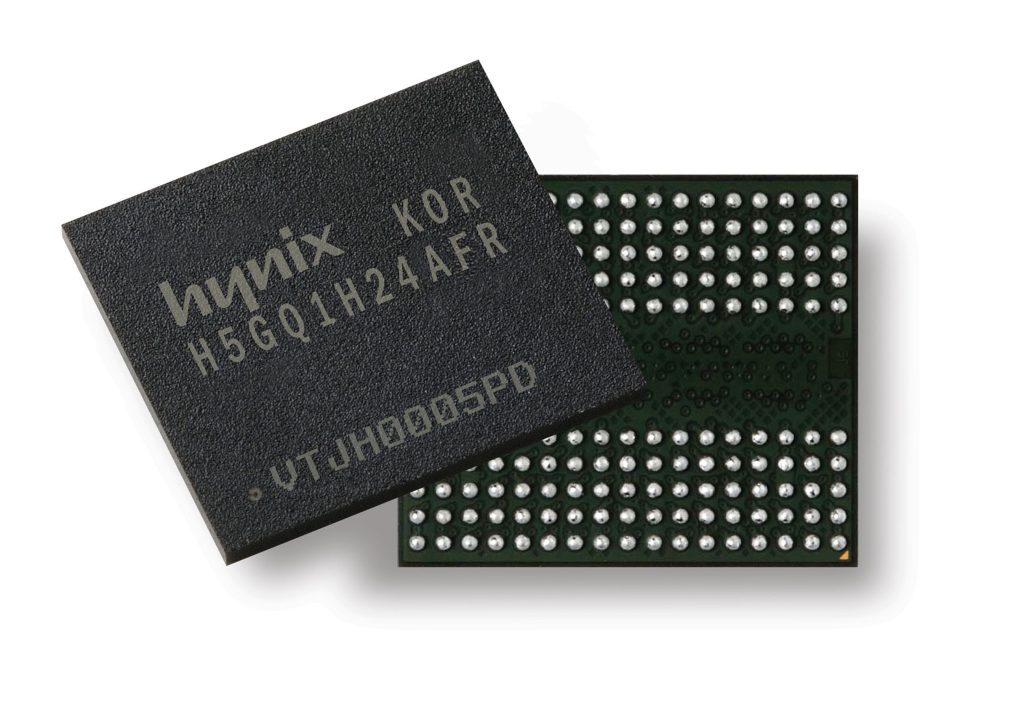

Samsung ha sido la primera en anunciar la llegada de la GDDR7, la nueva generación que sustituirá a la actual GDDR6. Con esta memoria, que tiene previsto presentarse a principios de 2024, se conseguirá un salto importante, con hasta 1.5 TB/s. Y es que se podrían fabricar chips DRAM GDDR7 con 16 Gb con velocidades de 32 Gbps por pin, frente a los 16 Gbps por pin de la GDDR6. Es decir, el incremento del ancho de banda es de 2 veces.

Por supuesto, también podrá mejorar en eficiencia y transferencias gracias a la nueva señalización PAM3 que se incorporará, frente a la NRZ de la GDDR6 actual. La mejora en este sentido será del 50%.

Recordemos que la GDDR6X es una variante desarrollada por Micron en colaboración con NVIDIA que no está estandarizada por el JEDEC, como la GDDR6 convencional. Esta memoria GDDR6X utiliza señalización PAM4, para mejorar también el rendimiento respecto a la GDDR6 que es la que emplea AMD e Intel.

Por otro lado, según los datos de Samsung, la GDDR7 será hasta un 20% más eficiente, por lo que el consumo se verá mejorado para este tipo de memorias. A pesar de esto, los chips disipan una buena cantidad de calor, lo que haría que necesitasen un nuevo módulo de disipación y un cambio en su estructura, para mejorar así un 70% la resistencia térmica en comparación con la generación anterior.

HBM4 vs GDDR6X

Anteriormente he comentado que la HBM4 tendría un ancho de bus por chip duplicado, con 2048-bit y que se duplicaría el ancho de banda a 2.30 TB/s por cada pila. A falta de confirmación, esto podría significar 16 Gb/s por pin de ancho de banda. Un importante salto respecto a la HBM3, que ofrece 9.8 Gb/s por pin.

La GDDR6X puede conseguir un ancho de banda por pin de entre 19 y 21 Gb/s con la señalización PAM4. Esto es superior al límite de la GDDR6 convencional, que solo tiene 16 Gb/s por pin. Es decir, que la GDDR6X e incluso la GDDR6, ganarían la batalla en este sentido, además de ser más baratas, por tanto, la HBM4 no tendría mucho sentido en una tarjeta gráfica actual, y es por eso que AMD desechó pronto la idea.

HBM4 vs GDDR7

¿Y con la GDDR7? Pues, si hemos visto que iguala a la GDDR6 y que la GDDR6X la supera, la verdad es que cabe esperar que la GDDR7 será aún superior a la HBM4 en muchos aspectos. Con la GDDR7 estamos hablando de 32 Gbps por pin, lo que puede plantar cara a la HBM sin problemas, aunque el ancho de bus y el ancho de banda de la HBM4 seguiría siendo superior (tiene más líneas de bus, recordemos esto…), aún trabajando a una frecuencia de reloj inferior. Por tanto, no espero que NVIDIA, AMD o Intel pasen a usar HBM en sus futuras tarjetas gráficas y abandonen la GDDR7.

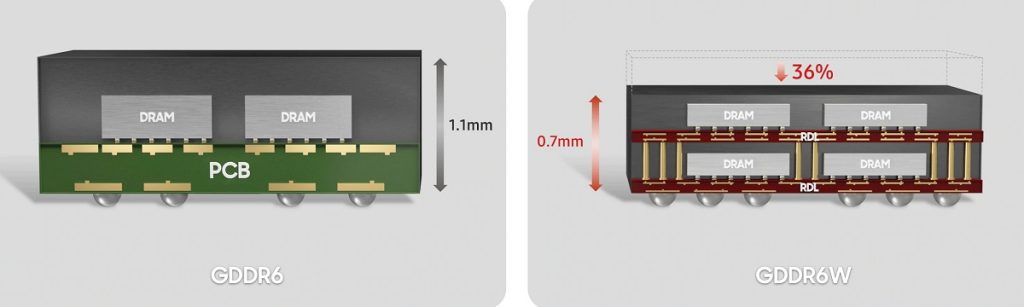

GDDR6W: la revancha

Para mayor sorpresa, Samsung también anunció a finales de 2022 que estaba desarrollando una nueva tecnología denominada GDDR6W, con un mayor ancho de banda. Entre sus características encontramos datos bastante prometedores, que también se lo pondrán muy difícil a la HBM4:

- Tasa de transferencia de hasta 22 Gb/s por cada pin.

- Duplicación de la capacidad por chip de 16 Gb a 32 Gb.

- Duplica los pines de E/S del 32-pin a 64-pin.

Recordemos que la HBM4 tendría 2048-pin, en cuanto a pines, y unos 16 Gb/s por pin de transferencia. Es decir, la GDDR6W, con una frecuencia de reloj superior a la HBM4, podría salir bastante airosa.

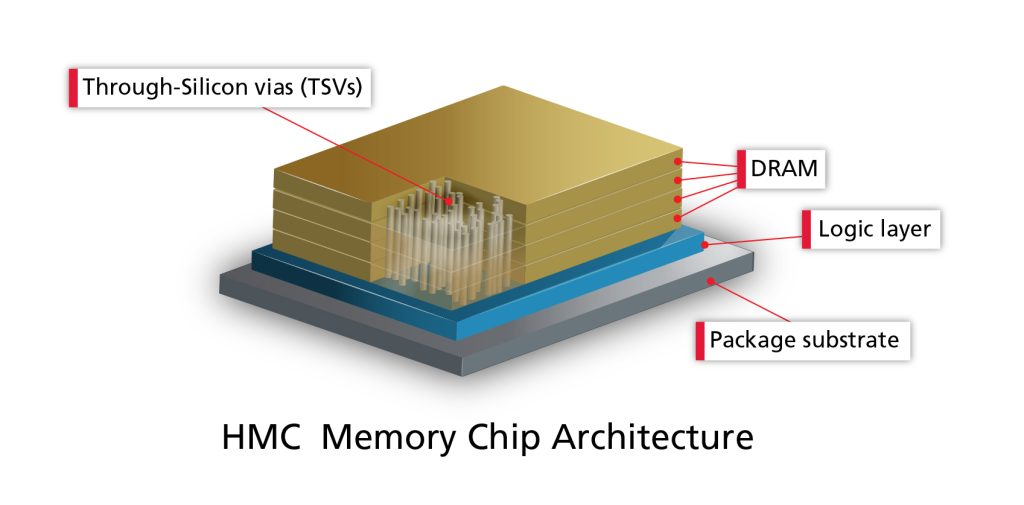

HMC y HMC2: ¿qué son estas otras memorias?

Pocos la conocen, pero en el campo de batalla también tenemos la memoria HMC (Hybrid Memory Cube). Se trata de una nueva interfaz para memoria RAM de alto rendimiento, y se parece mucho a la HBM en muchos sentidos, ya que también usa pilas de chips DRAM e interconectados por TSV, como la HBM. Por tanto, compite con la HBM, aunque son incompatibles una con la otra, como tampoco lo es de la DDR.

El HMC fue desarrollado conjuntamente por Samsung Electronics y Micron Technology en 2011. Prometía una mejora de velocidad de 15 veces en comparación con DDR3. Y dadas estas cifras, se creó incluso un consorcio para gestionar esta memoria, y que se denominó HMCC, compuesto por Samsung, Micron Technology, Open-Silicon, ARM, HP, Microsoft, Altera y Xilinx (AMD). Sin embargo, debido a falta de mercado potencial para la HMC, se descontinuaría en 2018. Todo a pesar de su potencial y de haber obtenido premios.

HMC usa interconexiones TSV en su empaquetado 3D y microbumps para conectar verticalmente los chips de memoria DRAM apilados con entre 4 y 8 capas actualmente. Además, cuentan con un controlador de memoria integrado en una matriz separada de lógica, como se aprecia en la imagen.

Se desarrollaron varias versiones, como la:

- HMC 1.0: se hizo pública en 2013, y usaba enlaces diferenciales full-duplex de 16 o 18 carriles. Cada carril puede funcionar a velocidades de 10, 12.5 y 15 Gb/s SerDes. Y cada paquete o pila de chips se llama cubo, pudiendo apilar hasta 8 chips DRAM. Cada cubo tendría 4 links de 896 pines GBA. Esto daría un total de un ancho de bada de 40 GB/s para 16 carriles, o lo que es lo mismo, 20 GB/s de transmisión y 20 GB/s de recepción. En cuanto al consumo y la capacidad, esta primera implementación tenía 512 MB y funcionaba a 11W, con 1.2v. Más tarde se consiguieron muestras mejoradas con hasta 2 GB de capacidad.

- HMC2: la segunda generación llegaría a finales de 2014, y en este caso se contaba con velocidades de entre 12.5 Gb/s a 30 Gb/s, con un ancho de banda por enlace de 480 GB/s, o 240 GB/s en cada dirección.

HBM vs HMC

Como he comentado, los datos de esta memoria HMC eran interesantes, y podría competir con la HBM. De hecho, hubo algunos procesadores que la usaron, como el Fujitsu SPARC64 XIfx, usado para la supercomputadora Fujitsu PRIMEHPC FX100 de 2015. Pese a eso, Micron anunciaría el cede de esta tecnología en 2018, en favor de otras tecnologías más competitivas y demandadas, como la HBM y la GDDR. Por tanto, este rival apenas ha podido dar lugar a una batalla contra la HBM…

El futuro de la HBM

La memoria HBM es una opción preferida para los hiperscaladores debido a su alto rendimiento, especialmente en aplicaciones de inteligencia artificial/aprendizaje automático (IA/ML). Sin embargo, su futuro en el mercado convencional es incierto, como hemos podido comprobar, las tecnologías más convencionales pueden cumplir bien su función para PC.

Aunque la HBM proporciona un alto ancho de banda en un factor de forma compacto, su adopción se ve obstaculizada por desventajas relacionadas principalmente con el coste. Debido al empaquetado 3D, este coste no las hace nada competitivas frente a las DDR o GDDR actuales, que tienen un rendimiento bueno a y precio mucho menor.

Por otro lado, tenemos que la HBM se enfrenta desafíos térmicos ya que atrapa el calor debido a su estructura de chips apilados. Y, a medida que sean más y más capas, y que las velocidades aumenten, estos desafíos se volverán cada vez más complejos.

Sin embargo, como digo, sigue siendo la favorita para aplicaciones HPC para muchos. Y, para reducir el coste de la HBM, se están explorando enfoques alternativos en cuanto a los materiales, las interfaces, y demás. Si logran solventar estos escollos, es muy probable que la HBM sea un rival muy a tener en cuenta en todos los frentes…