Casi todo el mundo usa lo que denominamos Internet o lo que se denomina ahora la nube. Sin embargo, esta nube no es algo etéreo, sino que es algo físico, se puede tocar. Todo se aloja en grandes máquinas, enormes salas conocidas como granjas de servidores o centro de datos. Y de eso tratará este artículo, de analizar a fondo qué hay dentro de estos edificios para que Internet o la nube funcione como lo hace…

¿Qué es un centro de datos?

Hemos pasado de aquellos años en los que no existía Internet, o la nube, pasando por los primeros años de esta red de redes que era algo exclusivo para grandes empresas y organizaciones, momentos en los que muchos gurús de la informática pensaban que Internet no llegaría a todos los hogares, hasta otra época en la que casi somos totalmente dependientes de esta red para cualquier cosa, desde realizar trámites burocráticos, hasta mantenernos en comunicación, pasando por otras muchas operaciones que hacemos a diario. Y no solo tenemos Internet o servicios de la nube en casa, sino que ahora está casi en todo, el famoso IoT, e incluso lo podemos llevar metido en un bolsillo con nuestros dispositivos móviles.

Aunque a veces se usa Internet como sinónimo de nube o nube como sinónimo de Internet, hay que decir que existen diferencias si a lo que nos referimos es al cloud computing o computación en la nube. Mientras Internet es la vasta red global de interconexiones, o la nube, el cloud computing es un entorno de servicios que hacen uso de esta red mundial, y ambos son las columnas vertebrales de la revolución tecnológica que estamos experimentando.

Tanto Internet como la nube lo vemos muchos usuarios como algo etéreo, algo virtual, algo que no se puede tocar. Sin embargo, como aprenderás en este artículo, la verdad es que sí que se encuentra localizado en distintos puntos del mundo y se pueden tocar e incluso visitar como veremos…

Es importante señalar los orígenes de esta red. El nacimiento de Internet se remonta a las décadas de 1960 y 1970, cuando los primeros intentos de crear una red de comunicación robusta entre ordenadores se materializaron. La creación de ARPANET (Advanced Research Projects Agency Network) por el Departamento de Defensa de EE. UU. fue un hito crucial, y se usaría en caso de ataque nuclear enemigo para mantener distintos puntos del país conectados. Con el tiempo, ARPANET evolucionó para convertirse en la Internet que conocemos hoy, conectando a millones de dispositivos en todo el mundo.

Sin embargo, aunque la red física es un invento de Estados Unidos, Internet y la nube tal como la conocemos hoy en día no sería nada sin otro invento, pero esta vez llegado desde Europa. Concretamente desarrollado en el CERN. Esto fue en un momento en el que esta red de redes se había expandido por el mundo, pero que era algo totalmente desconocido para los hogares.

Del invento del que hablo es la World Wide Web (WWW), comúnmente conocida como la web, fue inventada por Sir Tim Berners-Lee, un científico de este centro de investigación. Berners-Lee propuso el concepto de la World Wide Web en 1989 mientras trabajaba en el CERN (Organización Europea para la Investigación Nuclear) en Ginebra, Suiza. De esta forma, se podía aprovechar mejor esta red mediante un sistema de contenido e hipervínculos tal como lo conocemos actualmente.

La propuesta original de Berners-Lee consistió en un sistema de gestión de información basado en la idea de hipertexto, que permitiría a los científicos del CERN compartir y acceder fácilmente a la información a través de una red de computadoras. Berners-Lee desarrolló las tecnologías clave que forman la base de la web, como el lenguaje de marcado HTML (Hypertext Markup Language) y el protocolo de transferencia de hipertexto HTTP (Hypertext Transfer Protocol).

El 6 de agosto de 1991, Tim Berners-Lee publicó el primer sitio web del mundo en el dominio http://info.cern.ch. Este sitio web, en la actualidad, proporcionaba información sobre la World Wide Web y cómo utilizarla, marcando el inicio de una auténtica revolución.

Una vez Internet y la WWW fueron madurando y evolucionando, con la aparición de otros muchos protocolos, tecnologías, etc., y llegó a todos los hogares, se desarrolló también lo que se conoce como computación en la nube, otro nuevo hito en el que se le podía sacar mucho más provecho a esta red global. Y eso se hace mediante la entrega de servicios de computación, como almacenamiento, procesamiento de datos, redes, software y análisis, y un largo etc., sin entrar en detalles de fog computing o edge computing, etc.

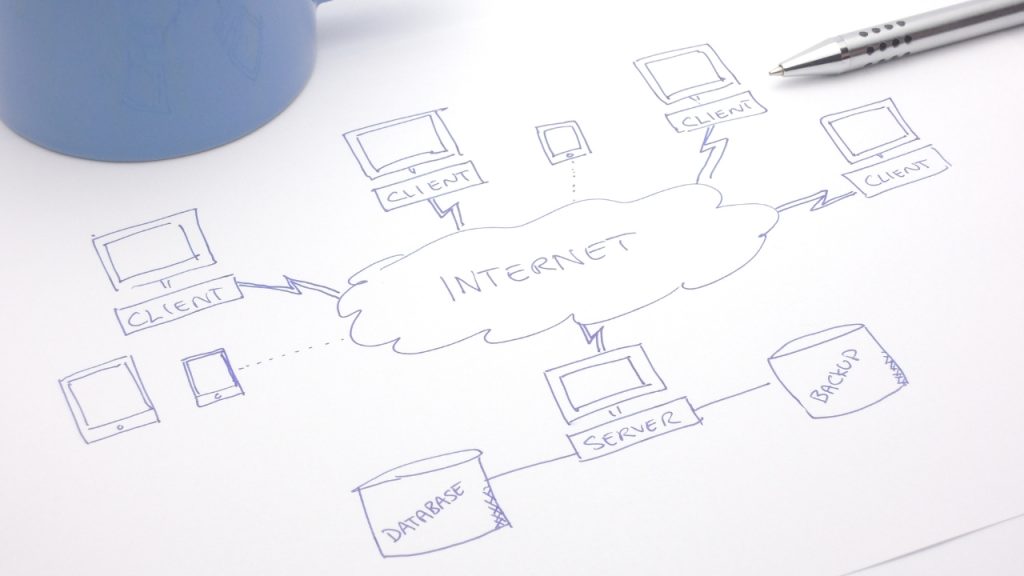

Cabe señalar también que Internet se basa en una arquitectura descentralizada y utiliza el protocolo de comunicación TCP/IP (Transmission Control Protocol/Internet Protocol). Este protocolo permite la transmisión de datos a través de la red, dividiéndolos en paquetes que se envían desde un origen y reensamblan en su destino. La diversidad de dispositivos, desde ordenadores hasta dispositivos inteligentes, y dispositivos IoT (Internet de las cosas), contribuye a la complejidad y amplitud de la red. Generalmente funcionando como pares cliente-servidor.

Sea como sea, el impacto de este invento ha marcado un antes y un después en la historia de la humanidad, y ha cambiado la forma en la que se hacen muchas cosas. A pesar de que está tan presente en nuestro día a día, aún hay muchos que desconocen qué es, y creen que no existe físicamente, pero se puede tocar, se puede sentir, se puede oler, se puede escuchar…

Alta disponibilidad

Como comprenderás, Internet, la nube, está siempre ahí. A veces algunos servidores se caen, y esto sucede por varias cuestiones. Puede ser una parada planificada para mantenimiento, ampliaciones, etc., o puede ser una parada inesperada, debida a algún fallo no previsto. Sin embargo, los servidores que sostienen esta red, necesitan ser muy fiables, por eso usan diversos sistemas de redundancia, seguridad, y emergencia. Aún así, no siempre son fiables al 100% como habrás podido comprobar…

La alta disponibilidad en servidores y centros de datos es un principio crítico que busca asegurar que los servicios y aplicaciones estén continuamente disponibles, minimizando o eliminando interrupciones no planificadas. La clave para lograr alta disponibilidad radica en la implementación de prácticas y tecnologías que reduzcan al mínimo el tiempo de inactividad y permitan una recuperación rápida en caso de fallos. Por ejemplo, las unidades de almacenamiento están en configuraciones RAID, para que si una falla o deja de funcionar, se pueda sustituir por otra unidad nueva sin necesidad de detener el sistema y sin perder datos, ya que están replicados en otras unidades redundantes. También hay sistemas SAI o sistemas de alimentación ininterrumpida para poder seguir en marcha en caso de corte de suministro eléctrico, e incluso se tienen otros sistemas auxiliares que veremos más adelante. Pero no solo se usa redundancia, también hay que destacar otras técnicas para esta alta disponibilidad:

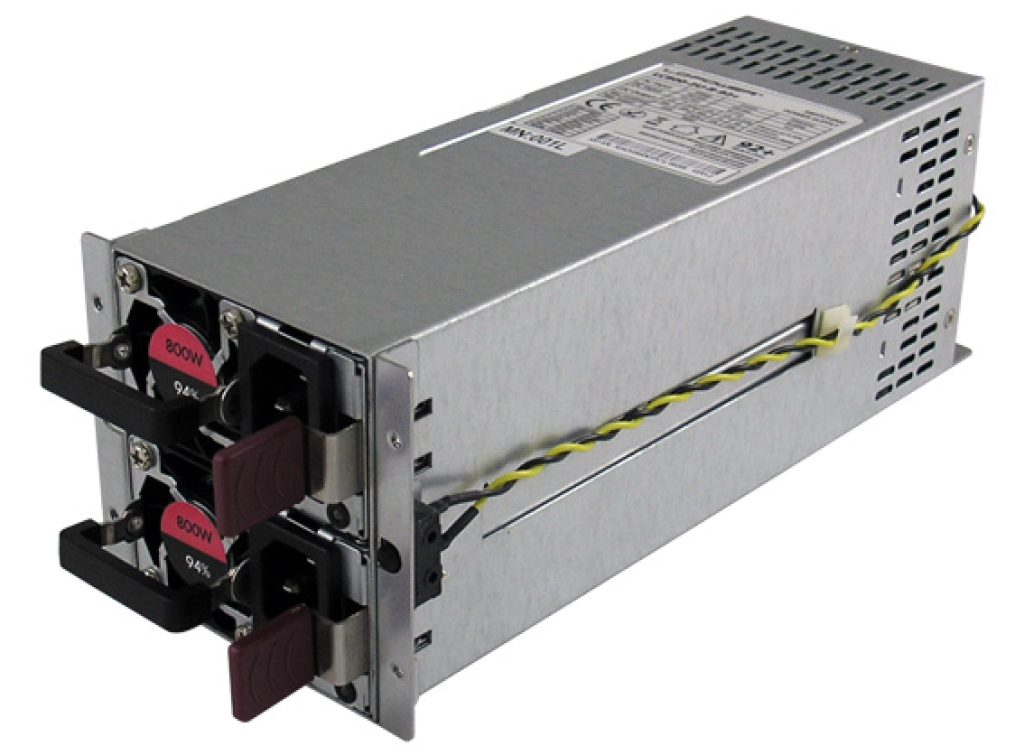

- Redundancia: el uso de componentes y sistemas redundantes no solo consiste en distintas unidades de almacenamiento, también va más allá, con fuentes de alimentación duplicadas, y otros muchos elementos que no son únicos, para que si uno falla, siempre el sistema se mantenga en funcionamiento, y sea tolerante a fallos.

- Balanceo de carga: distribuye la carga de trabajo entre varios servidores para evitar la sobrecarga de un solo sistema y mejorar la eficiencia y la disponibilidad.

- Respaldos y recuperación: se implementan políticas de respaldo regulares y soluciones de recuperación para minimizar la pérdida de datos en caso de un fallo. Además, hay minuciosos planes de emergencia para actuar en caso de que ocurra algún problema, como incendios, inundaciones, etc. Por supuesto, no son infalibles al 100%, de hecho, todos conocemos el caso del centro de datos de OVH que se quemó en un grave incendio y todos los clientes perdieron sus datos almacenados allí…

- Monitoreo continuo: utiliza herramientas de monitoreo por software, además de hardware y sensores, para gestión e identificar problemas antes de que afecten la disponibilidad y para permitir respuestas rápidas a eventos no planificados. Además, la recopilación de este tipo de datos, también puede ayudar a los planes de mantenimiento preventivo o predictivo que se llevan a cabo en estos equipos, ya que un mantenimiento correctivo no es adecuado cuando hablamos de alta disponibilidad.

Algunos términos interesantes que tienen que ver con esta alta disponibilidad son:

- MTTR (Mean Time To Repair): representa el tiempo promedio necesario para reparar un sistema después de una falla. Cuanto menor sea el MTTR, más rápida será la recuperación y menor será el impacto en la disponibilidad.

- MTBF (Mean Time Between Failures): es el tiempo promedio que transcurre entre dos fallas consecutivas en un sistema. Cuanto mayor sea el MTBF, mayor será la confiabilidad del sistema.

- MTTF (Mean Time To Failure): es el tiempo promedio hasta que ocurre una falla en un componente o sistema. Es un término a menudo utilizado en sistemas que no son reparables y se centra en el tiempo hasta la primera falla.

Pero, por qué tomarse tantas molestias. Pues bien, a parte de para tener a los clientes satisfechos, debes saber que las empresas dependen de esta disponibilidad, y que una caída puede suponer pérdidas millonarias, ya que mientras el servidor está caído, el servicio no se está prestando. Por ejemplo, si es una web de ventas como Amazon, durante el tiempo que esté caído el servicio nadie podrá comprar. En caso de ser un servidor VPS o de hosting, si tiene una buena reputación por su bajo historial de caídas siempre será preferido por los clientes para alojar sus webs, mientras que si tiene mala fama y se cae mucho, los clientes huirán de él…

La alta disponibilidad es esencial porque, en la era digital actual, los servicios y aplicaciones deben estar disponibles las 24 horas del día, los 7 días de la semana, y 365 días al año. Muchos de estos servicios no son banales, sino que pueden ser críticos, como los sistemas de sanidad, seguridad nacional, militares, suministro energético o de agua, etc.

¿Qué es un servidor?

Si te preguntas qué es Internet, y dónde está toda esa nube, la respuesta es sencilla. Está en ordenadores especiales conectados a esta red. Estos ordenadores se denominan servidores, y se encuentran en lo que se conoce como un centro de datos o una granja de servidores.

Un servidor, como he comentado, es básicamente un ordenador normal y corriente. De hecho, puedes configurar tu propio PC para que sea un servidor. Sin embargo, dadas las altas capacidades de los servicios de la nube, los servidores son diferentes a un PC de casa en muchos sentidos, y se agrupan en grandes cantidades en esas grandes salas llamadas granjas de servidores o centros de datos. Pero básicamente tienen lo mismo que tu PC, es decir, un equipo con un sistema operativo (en su inmensa mayoría son Linux como RHEL, SLES, Ubuntu Server, etc., aunque también existen servidores Windows Server, FreeBSD, etc.), una unidad de procesamiento o CPU, un sistema de memoria, un sistema de E/S, etc. Los componentes son prácticamente los mismos, aunque en algunos casos sean versiones especiales para HPC o servidores como luego comentaré.

Ten en cuenta que las capacidades de estos ordenadores o servidores debe ser mucho mayor que un PC convencional, ya que tienen que atender a millones de clientes de todo el mundo. Por ejemplo, imagina los servidores del buscador Google. A estos centros de datos se conectan millones de clientes de todo el mundo para buscar información, y necesitan ser potentes y rápidos.

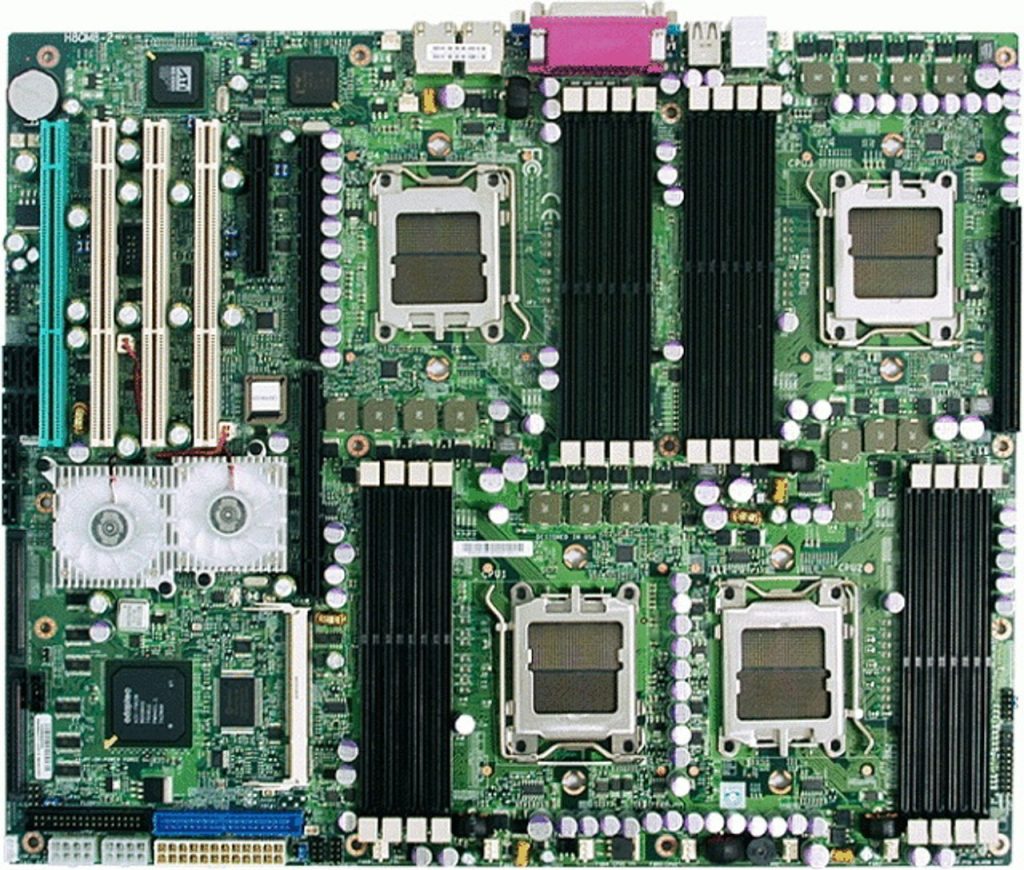

Para que te hagas una idea, algunos servidores pueden tener incluso Terabytes de memoria RAM, cientos o miles de procesadores que suelen ser Intel Xeon, AMD EPYC, IBM POWER, e incluso algunos ARM. Esto se hace mediante cientos o miles de placas base MP, es decir, que pueden tener dos o más sockets para montar dos o más CPUs en la misma placa, a diferencia de las placas base para ordenadores personales, que solo tienen un socket para un único procesador. Por otro lado, la capacidad de almacenamiento en discos duros HDD o SSD supera con creces a la que manejamos cualquiera de nosotros, pudiendo llegar a muchos Petabytes.

Por este motivo, estas granjas de servidores o centros de datos son enormes salas con grandes máquinas. Y no todos son iguales, ya que pueden prestar muchos servicios diferentes. Por ejemplo:

- Almacenamiento: si nos referimos a un centro de datos de hosting, son aquellos donde se alojan las páginas webs para que las podamos usar. Es decir, estas webs no solo son un conjunto de recursos como texto y contenido multimedia, sino que necesitan estar guardadas en algún sitio. En este caso en las unidades de almacenamiento de estos servidores. Estos servidores de almacenamiento pueden usar protocolos como HTTP para webs, FTP para subir y bajar datos, o ser lo que actualmente conocemos como servicios de almacenamiento en la nube, que básicamente es como los servidores FTP, solo que suelen disponer de alguna interfaz web o app para facilitar la subida y bajada de datos. Otra forma de servidor de datos puede ser un servidor de corroe electrónico, que aunque use otros protocolos, como POP3, IMAP, etc., básicamente son servidores de almacenamiento donde se almacenan los correos electrónicos y archivos adjuntos de todos los usuarios registrados. Los servicios de contenido de streaming, como Amazon Play Music o Video, Netflix, Spotify, HBO MAX, Disney Plus, etc., también pueden verse como un tipo de servidor de almacenamiento donde tienen todas las series, películas y documentales alojadas en la nube para que sean accesibles por sus clientes desde las apps cliente.

- Procesamiento: los servidores también pueden dedicarse a ejecutar aplicaciones web en ellos, o usarse también para transacciones bancarias, para servicios de cómputo en la nube, simulación científica, etc. A diferencia de los anteriores, donde se necesitaban servidores con una alta capacidad de almacenamiento, en este caso se necesitan altas capacidades de cómputo, es decir, lo que se conoce como HPC.

- Seguridad y autenticación: existen también servidores dedicados únicamente a verificar la identidad de usuarios y dispositivos que intentan acceder a recursos protegidos por contraseñas u otros métodos de autenticación. Por ejemplo, un caso son los servidores LDAP.

- Juegos en línea: aunque en este caso también puedan ser una mezcla de servidores de almacenamiento, también necesitan ser potentes en cuanto a procesamiento, tanto de CPU como de GPU, ya que el servicio en la nube por streaming en este caso necesita ejecutar los videojuegos en estos servidores para muchos usuarios simultáneamente. Ejemplos son los servidores de NVIDIA GeForce NOW.

- DNS: estos otros servidores son muy importantes en la red, ya que son necesarios para que todos los usuarios del mundo no tengamos que recordar IPs. Como sabes, las IPs son direcciones que identifican un servidor en la red. Sin embargo, en vez de recordar estos nombres tan engorrosos, como puede ser 165.116.11.13, podemos simplemente usar nombres más intuitivos en nuestro navegador web como www.ejemplo.com y los servidores DNS de nuestro proveedor de servicios de Internet, convertirá este nombre de dominio en una IP para que la red haga su magia y te conecte con el servicio que buscas.

- Otros: existen otros muchos tipos de servidores, como pueden ser los servidores de los proveedores de Internet o ISP, empleados para que los clientes que controlan el servicio de conexión a Internet se puedan conectar a la red a través de ellos. Es por este motivo por el cual si no usas una VPN, los datos e historial de navegación queda almacenado en estos servidores de Telefónica/Movistar, Vodafone, Jazztel, Orange, O2, etc. Relacionado con este tipo de servidores también se pueden destacar los DHCP, es decir, servidores que se encargan de repartir o asignar una IP dinámica a los routers de los clientes. Lo que hacen es tener un repertorio de IPs y las van asignando de forma aleatoria cada vez que se solicita, cuando no se usa una IP fija. Tampoco me gustaría olvidar los servidores NTP, que son los que mantienen toda la red en hora, y que están basados en relojes atómicos de alta precisión…

Existen más, pero por ahora es suficiente con esto, simplemente quiero que veas lo que es un servidor y para qué se usan…

Partes de un servidor

Un servidor típicamente consta de varias partes que trabajan juntas para proporcionar servicios de computación. Aquí hay una descripción general de algunas de las partes comunes de un servidor. Estos elementos suelen estar multiplicados frente a lo que vemos en una configuración convencional de un PC, como he comentado anteriormente. Y los recursos de estas grandes máquinas se pueden explotar como si este enorme ordenador fuese uno solo, sumando todas las capacidades de los diferentes nodos o servidores, o también pueden fragmentarse, como es el caso de los VPS o servidores privados virtuales, empleando máquinas virtuales para que actúe como muchos ordenadores diferentes.

Sea como sea como se use, las partes destacadas que deberías conocer son:

Armario o cabinet

En algunos países se conoce como gabinete, aunque aquí se le denomina armario. Este elemento no es más que un gran armario vertical para encerrar todo el resto de componentes electrónicos necesarios para el servidor, cumpliendo las funciones de protección contra el polvo, contra golpes, y también para reconducir el aire caliente hacia su zona trasera por donde es expulsado. Algunos armarios incluso tienen puertas con sistemas de refrigeración activos.

Además, hay que saber que en un centro de datos o granja de servidores hay muchos de estos armarios, y pueden ocupar grandes superficies. Los armarios pueden ser similares o diferentes. Por ejemplo, algunos centros de datos tienen armario dedicados solo a cómputo, otros armarios a almacenamiento, o pueden estar mezclados en un mismo armario. También los hay de red, de alimentación para el suministro eléctrico, con sistemas UPS o SAI, etc.

Rack

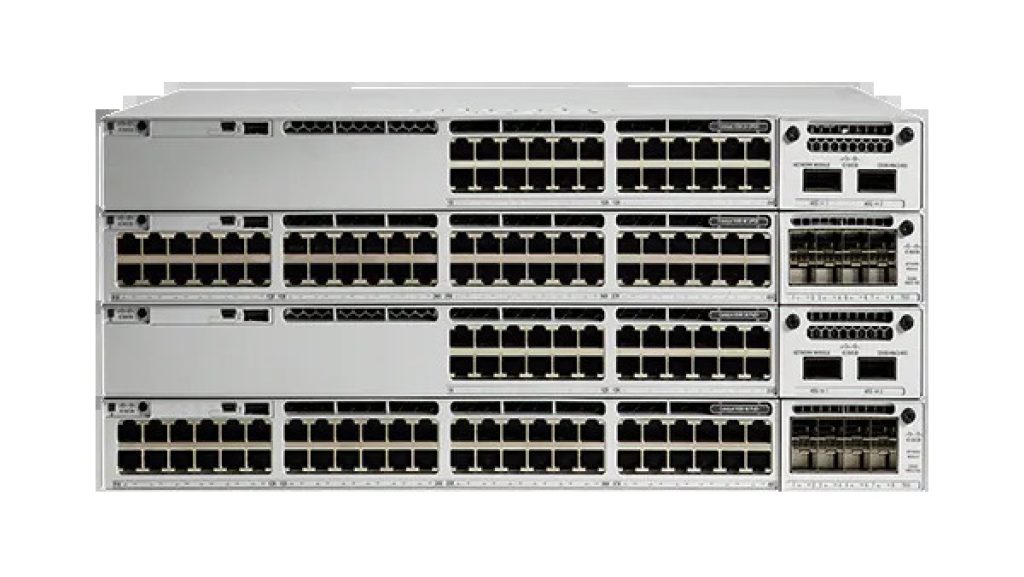

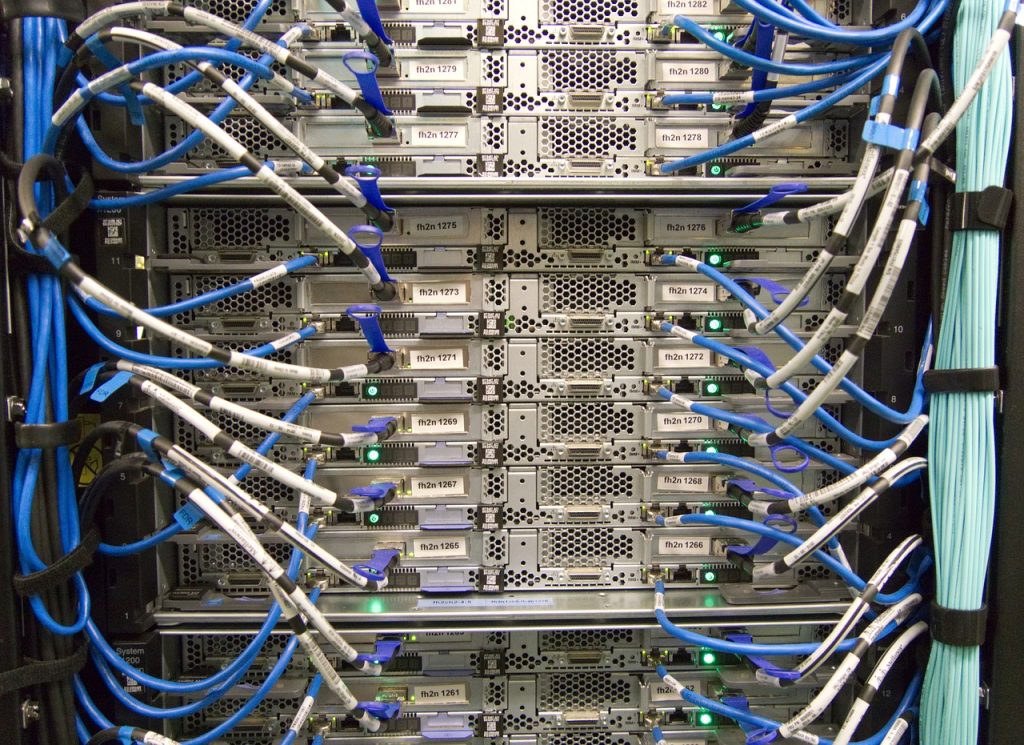

Es una estructura metálica que sirve como marco para montar varios componentes electrónicos, como has podido ver en la imagen anterior, y que se aloja dentro del armario. No obstante, no siempre existen armarios, hay algunos servidores que están expuestos, sin el armario, aunque estos suelen ser los de centros de datos particulares o de empresas más pequeñas.

El rack está diseñado para ser montado en un armario o sala de servidores. Los racks permiten una disposición ordenada y eficiente de los equipos. Estos racks pueden ser de muchos tipos. Por ejemplo, podemos tener los de computo, donde se encuentra la placa base con los procesadores y la memoria, también existen racks que son de alimentación para todo el armario, de red para conectar todos los servidores de un armario los unos con los otros o con otros armarios, pueden ser también nodos o racks de almacenamiento, compuestos por varias unidades con configuraciones RAID, etc. También existen algunos racks denominados terminales tontas o KVM, que consiste en un monitor, un teclado y un ratón/touchpad para que los administradores de estos servidores puedan instalar el sistema operativo, realizar las configuraciones, el mantenimiento, etc. No obstante, también es posible hacerlo de forma remota, sin estar presente en el centro de datos, para eso se usan protocolos de conexión como SSH.

El rack también puede tener algunos accesorios extra para facilitar la gestión del cableado, etc.

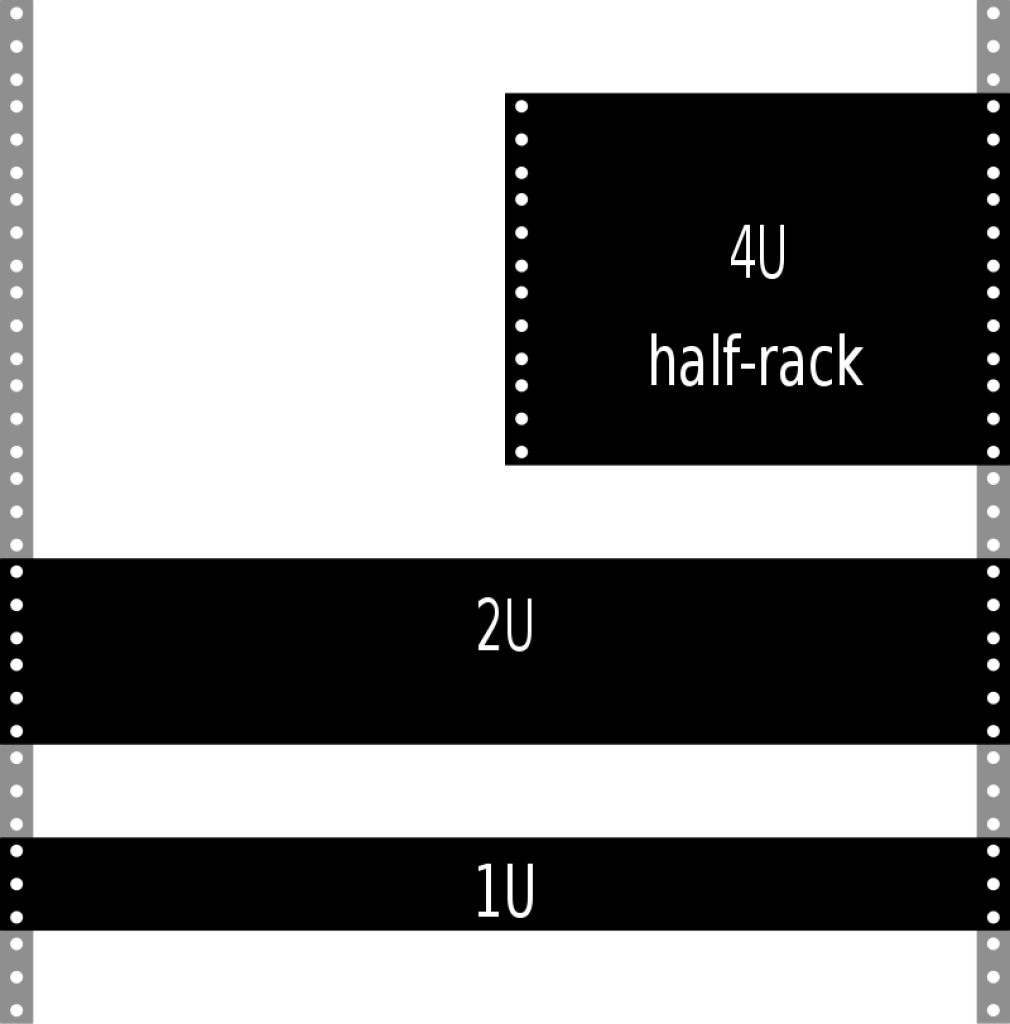

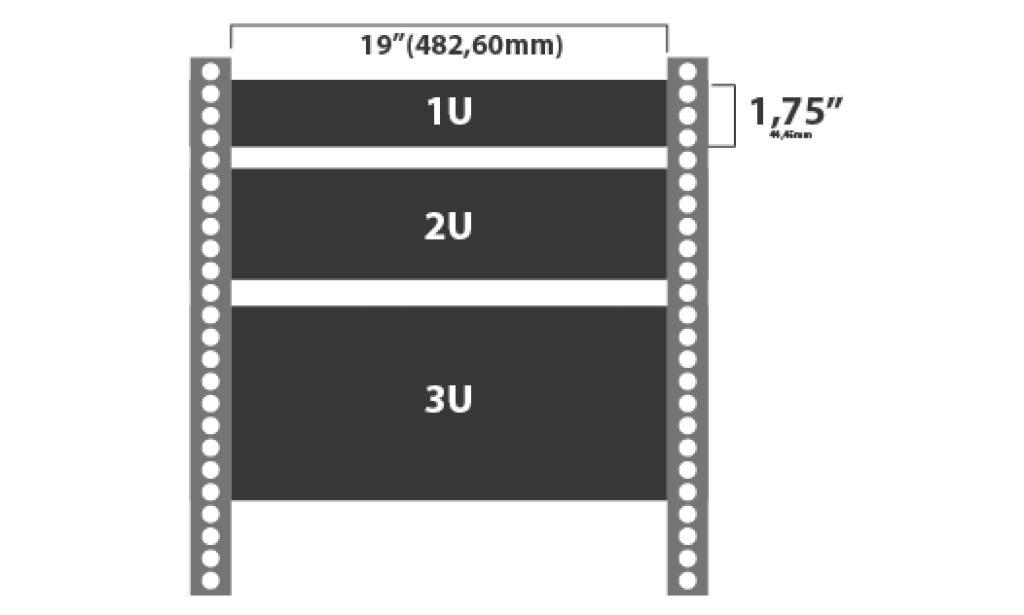

Sea del tipo que sea, el rack se ajusta a unas unidades de medida denominadas U (Rack Unit), y pueden tener más o menos Us de tamaño. Todas estas unidades están estandarizadas. Cada U corresponde a una altura de 1.75 pulgadas (aproximadamente 4.45 centímetros).

La notación comúnmente utilizada para describir la altura de un rack, seguida de un número que indica cuántas unidades de rack ocupa. Por ejemplo, un servidor que ocupa 2U tiene una altura de aproximadamente 3.5 pulgadas (2U x 1.75 pulgadas/U). Si un rack tiene una altura de 42U, significa que puede albergar 42 unidades de rack en total.

La estandarización en unidades de rack facilita la compatibilidad y la organización en entornos de centros de datos. Al tener una medida uniforme, los administradores de centros de datos pueden planificar y organizar de manera eficiente el espacio, asegurándose de que los equipos se ajusten correctamente en los racks.

Es común encontrar racks de 42U o 48U en centros de datos, aunque las alturas pueden variar. Además, algunos dispositivos más pequeños, como conmutadores de red, pueden ocupar solo 1U o 2U, mientras que servidores más grandes pueden requerir 4U o más. La elección del tamaño del rack y la disposición del equipo en el centro de datos son decisiones importantes para optimizar el espacio y la eficiencia del sistema.

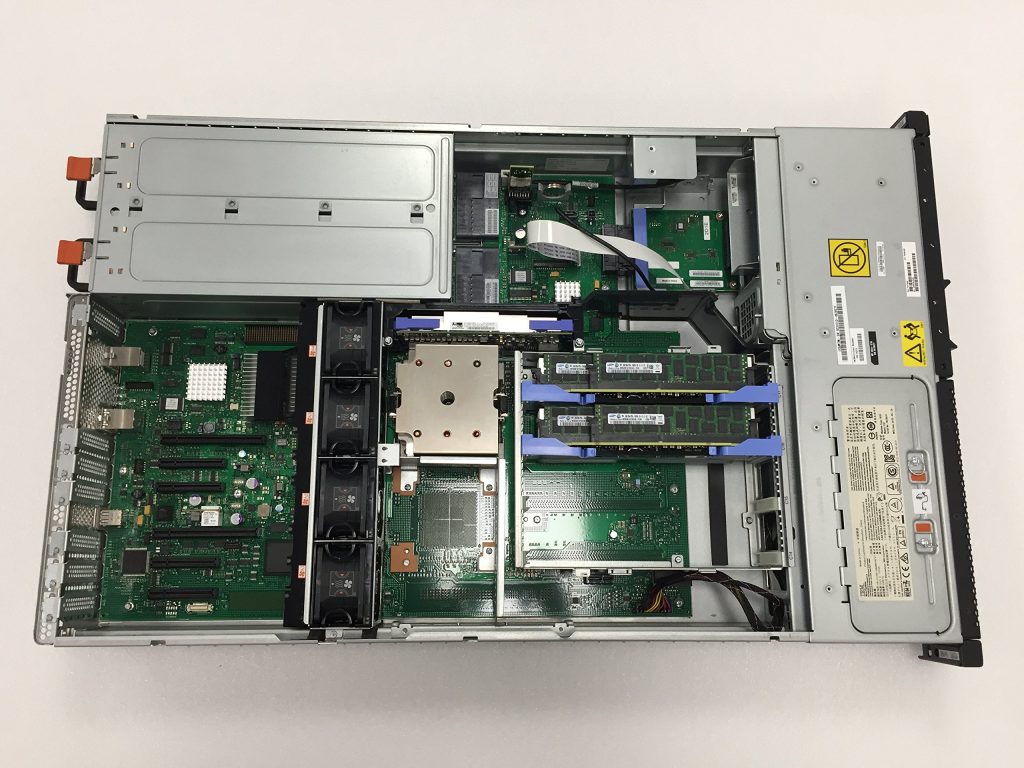

Nodos

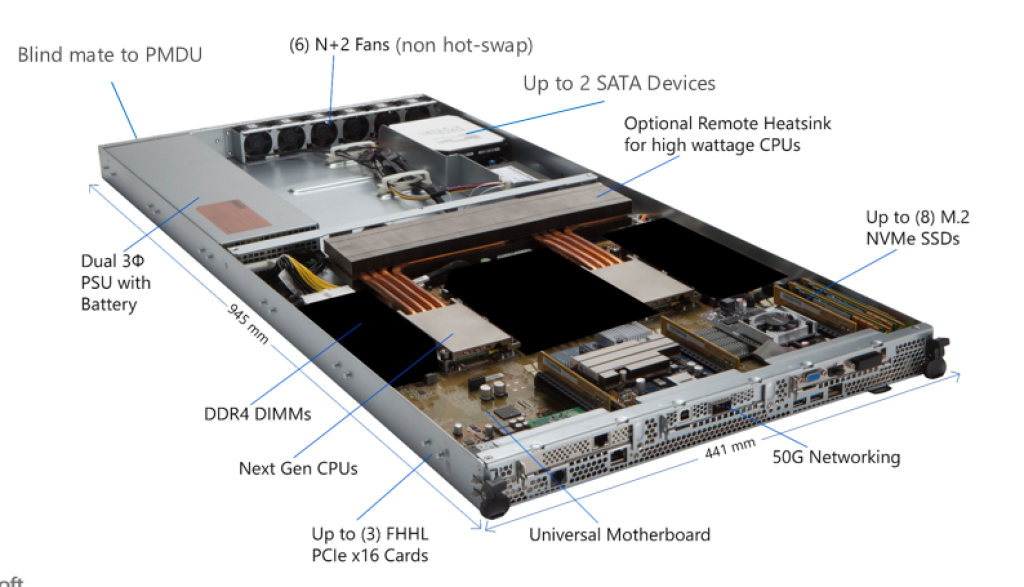

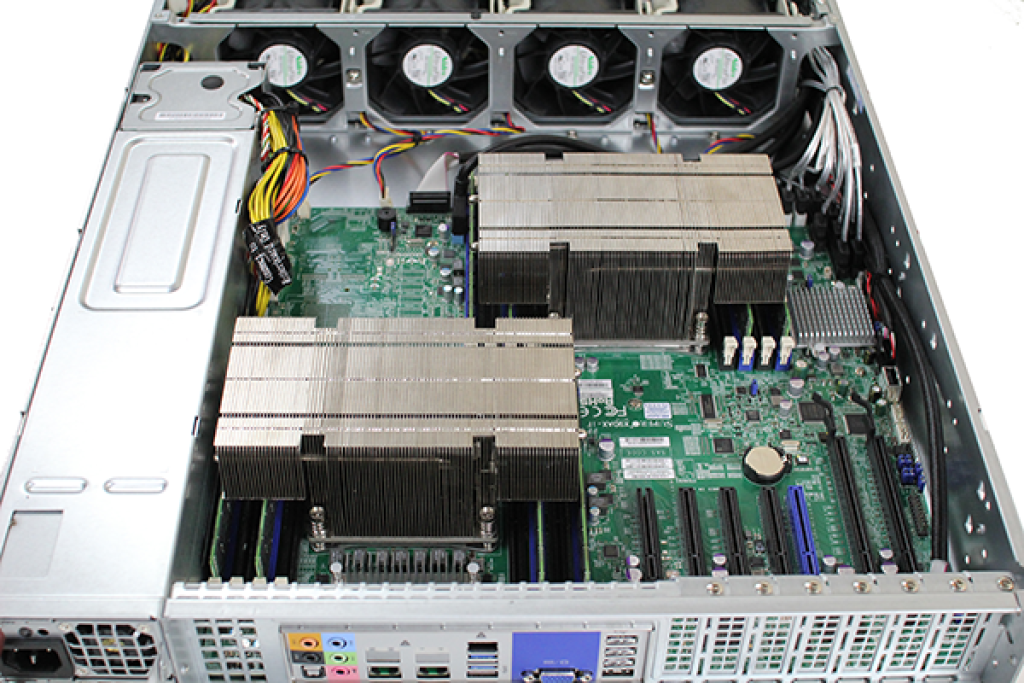

Nos referimos a los nodos para denominar a las bandejas que pueden ser de una o varias unidades U y donde se alojan los componentes básicos, como son la placa base, fuente de alimentación del nodo (luego habrá otras para todo el rack o armario), procesador, memoria RAM, etc. Además, los propios elementos suelen incluir ventiladores y disipadores de calor para mantener una temperatura operativa adecuada y prevenir el sobrecalentamiento. Son bastante similares a los que encontramos en muchos PCs convencionales.

Como he comentado antes, las placas base, procesadores, memorias RAM, y discos duros suelen ser algo especiales. Por ejemplo, para las CPUs tenemos los AMD EPYC o los Intel Xeon como los procesadores más habituales. Y éstos pueden estar en placas base que tienen un solo socket, dos sockets, o más, es decir, lo que se conoce como placas base MP especiales para servidores, y que no solo tienen más sockets, también disponen de más bancadas de slots para los módulos RAM para cada CPU. Por otro lado, dado que son sistemas de alta disponibilidad, las memorias RAM no son identicas a las de un PC convencional, ya que son memorias ECC, es decir, tienen corrección de errores para este tipo de tareas más críticas. En cuanto a los discos duros SSD o HDD, son bastante similares, solo que suelen ser modelos más fiables especialmente pensados para la alta disponibilidad, como pueden ser los Seagate Exos Enterprise, o los Western Digital UltraStart o los Gold, etc.

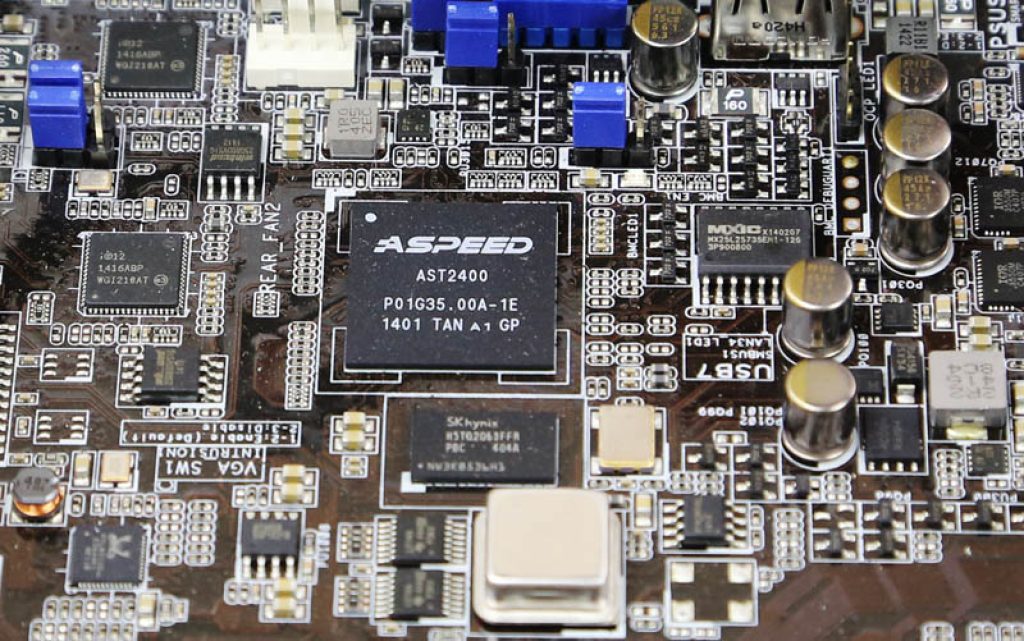

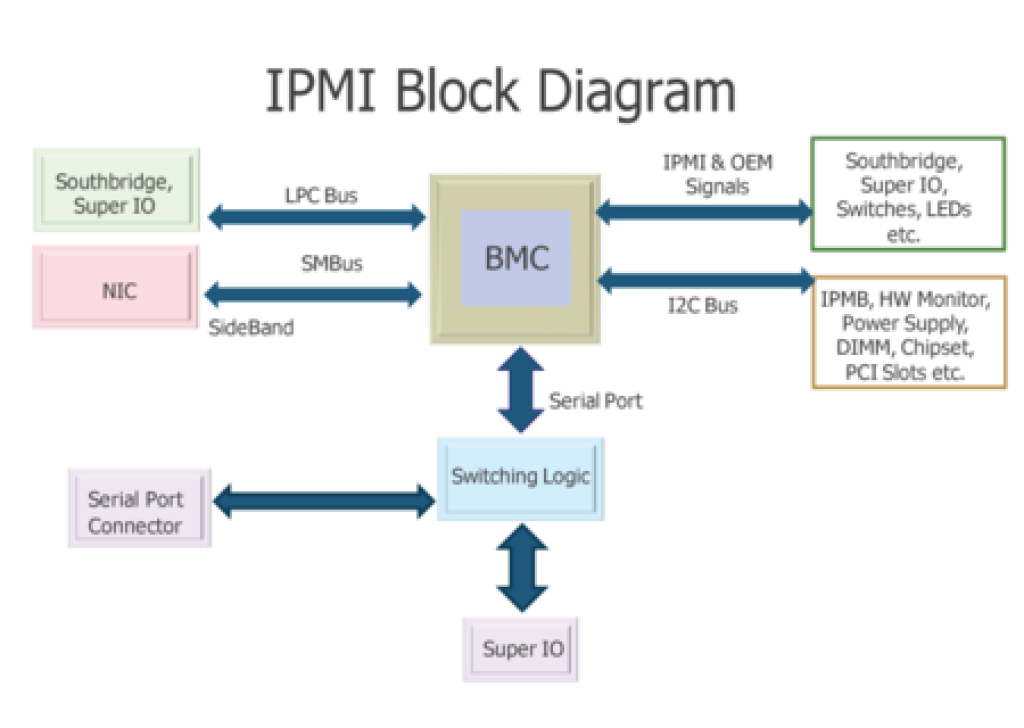

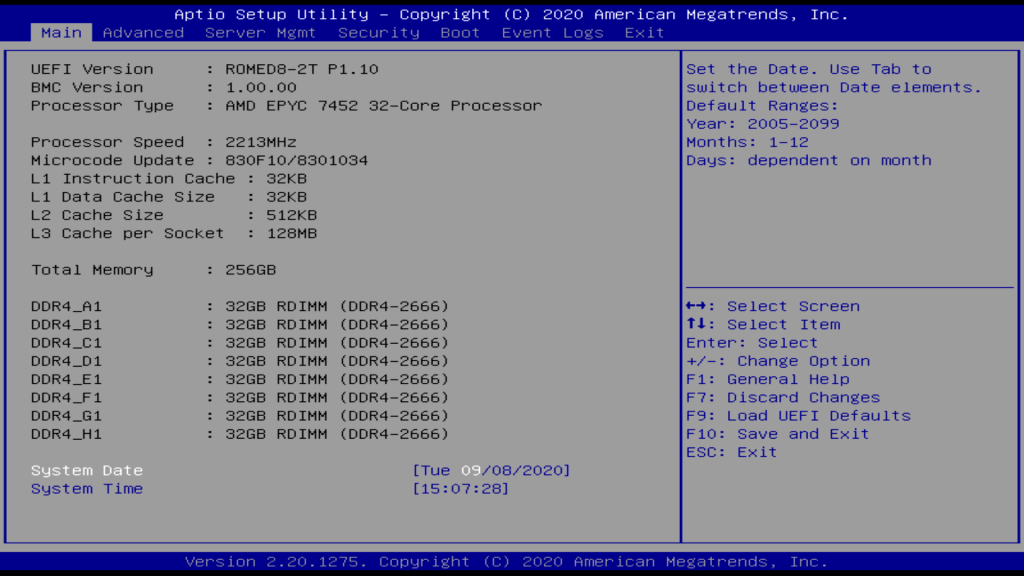

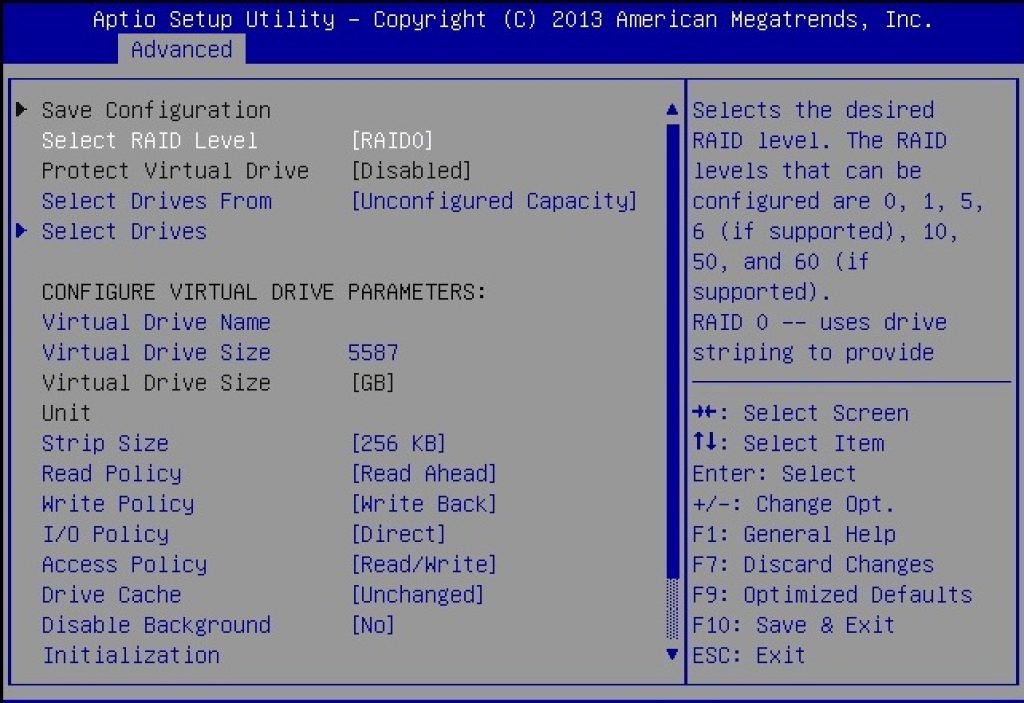

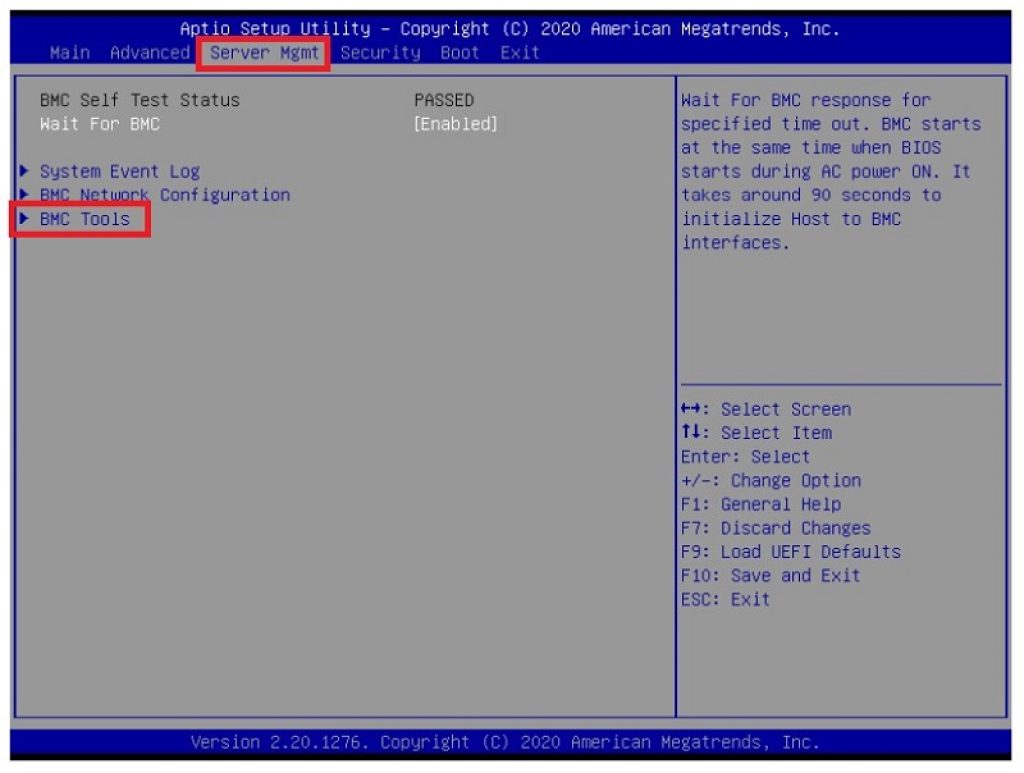

Tampoco he comentado que las placas base suelen tener algunas diferencias en cuanto a las convencionales, por ejemplo, integran el sistema de gestión remota o BMC – Baseboard Management Controller proporciona funciones de gestión y monitoreo remoto del servidor, como el acceso fuera de banda y la supervisión de la salud del sistema. Y un firmware especial, ya sea UEFI o de otro tipo, con opciones adicionales para su gestión, o para configurar el sistema RAID para arrancar desde él en vez de desde una sola unidad de disco duro independiente para realizar la instalación del sistema operativo, etc., como puedes ver en las siguientes imágenes:

Estos nodos son los de cómputo, los que tienen las unidades de procesamiento, pero también puede haber algunas de estas bandejas que estén dedicadas solo a almacenamiento, o solo a redes, como los switches, fuente de alimentación, la terminal tonta de la que comenté al principio, etc. Por cierto, hay que diferenciar entre las tecnologías de red interna, que son las que enlazan los distintos nodos para que todo funcione como un ordenador único, de las redes externas, que son las que enlazan el centro de datos con Internet. En el caso de las externas, son redes de fibra similares a las que tenemos en casa, pero con unos anchos de banda y velocidades muy elevados para satisfacer todas las demandas del servicio cuando se conectan los clientes desde todo el mundo. Mientras que las internas se basan normalmente en tecnologías patentadas como Infiniband, RoCE, o también en Ethernet LAN para crear una red de nodos con los correspondientes switches de red, etc.

Estos componentes trabajan en conjunto para proporcionar servicios de computación confiables y eficientes en entornos empresariales y de centros de datos. La elección de la configuración específica dependerá de las necesidades y los requisitos particulares de la carga de trabajo del servidor.

¿Cómo son las instalaciones e infraestructura?

Un centro de datos es una instalación física que alberga equipos de computación, redes y otros componentes relacionados para el procesamiento, almacenamiento, gestión y distribución de datos. Los diferentes centros de datos o granjas de servidores repartidas por todo el mundo es lo que componen lo que conocemos como nube o Internet, por tanto, si visitas uno de estos centros, podrás sentir un pedacito de la nube, comprobando, como comenté al principio, que no es algo etéreo, sino que es físico.

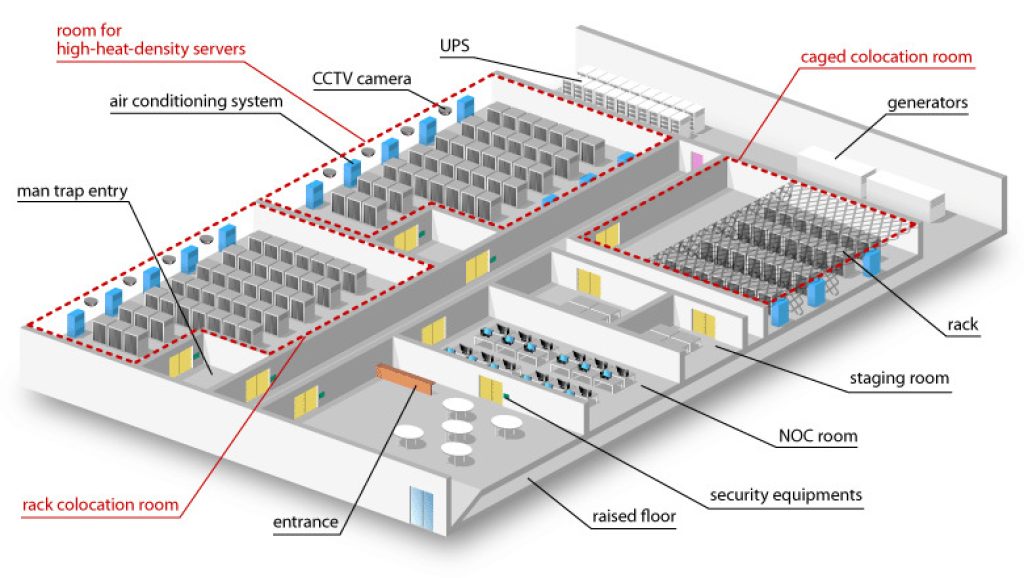

Estas instalaciones son fundamentales para el funcionamiento de servicios en línea, y se componen de distintas partes destacadas que debes conocer:

Perímetro exterior

Los centros de datos son edificios de empresas privadas que tienen un recinto vallado y con medidas de seguridad bastante fuertes, como una caseta para un guardia que controle que solo entre el personal autorizado y nadie más, vigilantes diurnos y nocturnos, etc.

Además, en todo el perímetro puede haber diferentes sistemas de seguridad, como pueden ser cámaras de videovigilancia, sistemas de alarma, etc. De esta forma controlan a todos los que entran dentro del recinto, aunque este no es el único nivel de seguridad.

Área de recepción

Algunos centros de datos tienen un área de recepción donde se lleva a cabo el control de acceso y la seguridad, es decir, otro nuevo control, pero esta vez, en vez de controlar los vehículos que entran o salen, controlar al personal que accede y a qué salas puede hacerlo, cuándo ficha con sus tarjetas de acceso, etc. Además, el acceso a cada sala también suele estar controlado mediante tarjetas de acceso o seguridad biométrica para solo dejar acceder al personal autorizado.

Ten en cuenta que en un centro de datos pueden trabajar decenas o cientos de personas, pero cada una con un rol concreto, por lo que no todos tienen acceso a todas las salas. Por ejemplo, la sala de cómputo donde se encuentran los servidores solo debe ser accedida por personal de mantenimiento técnico o administradores, o tal vez alguna visita eventual de alguna autoridad o grupo de personas previamente autorizado.

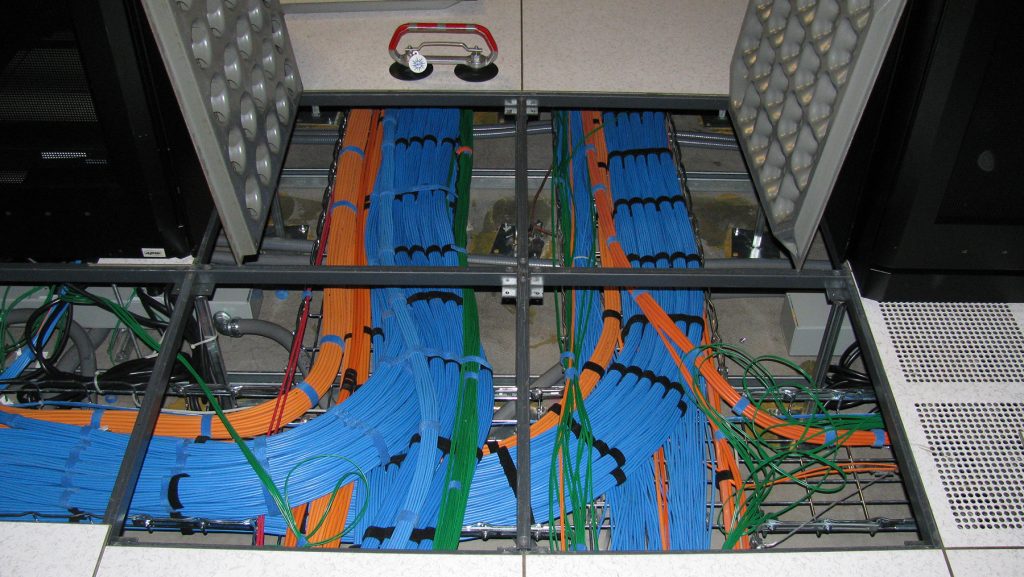

Sala de servidores

La sala de servidores es el corazón del centro de datos y alberga los servidores y otros equipos críticos necesarios, como pueden ser armarios con las instalaciones eléctricas, suelos flotantes bajo los que pasan tuberías para la refrigeración, tubos de aire, e incluso el cableado de red. No obstante, el cableado de red también puede ir a través de unos rieles por el techo del centro de datos. Ten en cuenta que esta sala está diseñada para garantizar condiciones ambientales (temperatura y humedad relativa) controladas, además de disponer de sistemas de alarma, extinción de incendios, sensores para el monitoreo, cámaras de seguridad para ver qué ocurre dentro, etc. Es decir, todo lo necesario para que funcione correctamente.

Otro detalle importante es que el acceso a esta sala desde el exterior debe ser fácil, con rampas, y con puertas amplias, ya que cuando se instalan los armarios con los servidores se suelen llevar en montacargas para emplazarlos e instalarlos en su interior. Lo mismo sucede cuando realizan una ampliación. Por tanto, tiene que estar adaptado para ser modular, escalable y facilitar la instalación de nuevos equipos.

Otro detalle importante dentro de la sala de servidores es que en algunos casos te vas a encontrar, además de sensores para medir temperatura, cámaras, sistemas de extinción de incendios, sensores de humedad, etc., también vallas con cerraduras o candados para evitar el acceso a ciertos armarios. Esto no es así en todos los centros de datos, pero sí en aquellos servicios en los que no se vende al cliente un VPS, o un espacio, etc., sino que tienen un servidor dedicado, por tanto, tendrán una serie de armarios del total de la sala de servidores que son suyos, y solo pueden acceder a ellos el propietario. Luego habrá otras parcelas de otros propietarios, y así se evita algún tipo de sabotaje, etc.

Infraestructura de energía

Algunos elementos del sistema de suministro de energía pueden estar separados en otras salas dedicadas. Por ejemplo, los enormes sistemas SAI o UPS para mantener estos centros de datos funcionando en caso de corte de suministro eléctrico durante 15 o 20 minutos, los cuadros eléctricos que no solo controlan la electricidad que va a las diferentes fuentes de alimentación presentes, sino también para otros sistemas de la sala como puede ser la iluminación, etc.

Los sistemas UPS o SAI son similares a los que puedes tener en casa, con una batería y un sistema que se activa automáticamente para suministrar energía a toda la sala cuando hay un corte eléctrico. Sin embargo, dadas las demandas energéticas de estos centros de datos, son mucho más grandes, con baterías inmensas. Ten en cuenta que no estamos hablando de vatios (W), sino que estos monstruos pueden consumir varias unidades e incluso llegar a varias decenas de MW dependiendo de su tamaño y eficiencia.

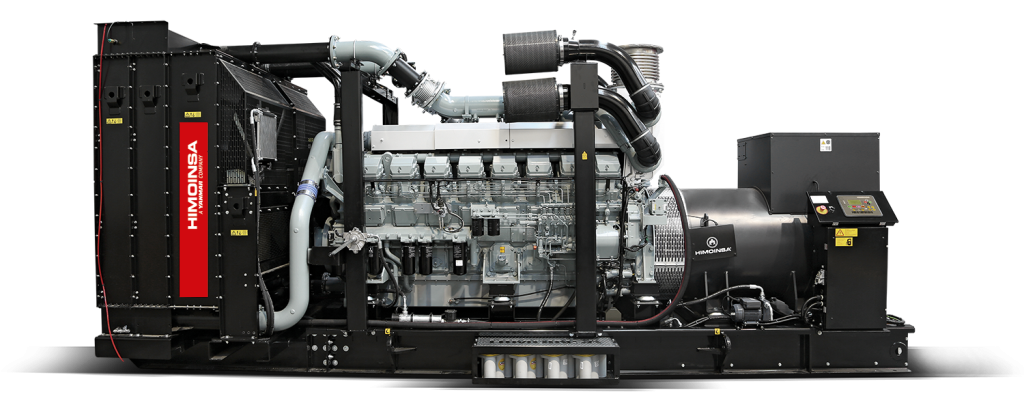

Aunque los centros de datos se suelen instalar cerca de las subestaciones eléctricas para una mayor fiabilidad, no siempre se mantiene el suministro. Debido a tormentas eléctricas o cualquier otra avería en la red eléctrica se puede cortar el suministro de energía en el centro de datos. Pero como hemos comentado en el apartado de alta disponibilidad, estos servidores no se pueden permitir el lujo de parar. Por eso, no solo cuentan con baterías en los SAI o UPS, sino que también disponen de salas en el exterior del edificio principal donde se encuentran grandes generadores diésel y enormes depósitos con muchos litros de combustible para generar la energía necesaria para suministrar al centro mientras se soluciona el corte eléctrico. Además, los sistemas SAI funcionan durante unos minutos mientras el generador se arranca y comienza a funcionar de forma estable. Una vez llegados a ese punto, el generador es el que se encargará del abastecimiento de energía.

Estos edificios para los generadores diesel, que no son más que monstruosos motores diésel dedicados a generar electricidad haciendo girar un generador eléctrico, tienen tubos de escape que emiten grandes cantidades de gases, por lo que son reconducidos hacia un sistema de chimeneas externos para evitar gases tóxicos en el interior de la sala en la que trabajan los operarios.

Para que te hagas una idea, suele haber varios de estos motores monstruosos en un centro de datos, según el tamaño de éste habrá más o menos. Pero uno de ellos puede ser un motor V16, es decir, con 16 cilindros en V, 8 en cada bancada, y tener cilindradas de unos 50 litros, es decir, un 50.000 centímetros cúbicos. Este tipo de motores están entre los más grandes, junto con algunos de maquinaria pesada o de barcos.

Sala del sistema de refrigeración

Los centros de datos no solo cuentan con los sistemas de refrigeración integrados en los racks como he comentado anteriormente, también tienen mega sistemas de refrigeración similares a un monstruoso sistema de aire acondicionado para mantener una temperatura estable ante tanto calor generado y también unas condiciones de humedad relativa adecuadas, ya que si baja o sube puede causar estragos. De hecho, algunas caídas de servidores se han debido a un mal control de la humedad, generando gotas por condensación y generar cortocircuitos en la electrónica. Los sistemas de aire acondicionado tienen enormes ventiladores y sistemas como los denominados chillers, que se pueden ver como sistemas de intercambio de calor mediante un fluido.

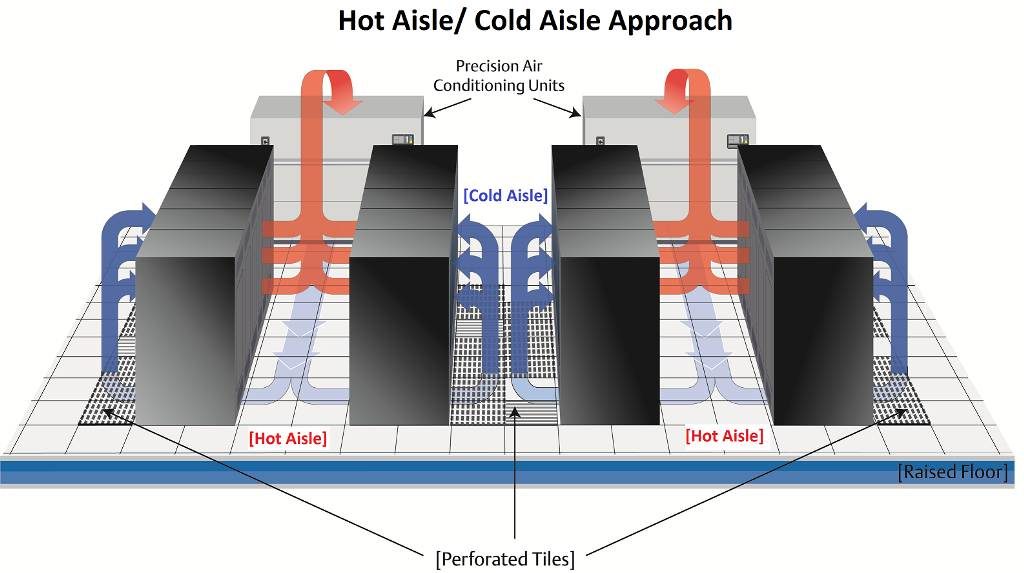

Mientras estos enormes aires acondicionados tratan el aire para expulsar el calor e introducir aire frío al interior y mantener temperaturas que rondan entre los 17 y 23ºC y humedades relativas que están entre el 45% y el 50% HR, el aire introducido puede distribuirse de varias formas. Una de ellas puede ser a través de conductos instalados en la zona alta, y otros a través de baldosas con rejillas en el propio suelo flotante, haciendo subir el aire fresco hacia los pasillos de estos servidores.

Esto genera lo que se denomina pasillo frío/pasillo caliente, donde tenemos un pasillo a temperatura más baja por donde emana el aire fresco que llega desde las unidades de aire acondicionado, y otro pasillo caliente por la zona trasera de los armarios por donde expulsan el aire caliente generado por la electrónica.

También habrá unas unidades cercanas al pasillo caliente que irán absorbiendo el aire caliente generado para sacar este aire fuera de la sala. Un aire que puede ser aprovechado, ya que al estar caliente, se podría aprovechar dicha temperatura para diferentes cosas, aunque esto es otro tema…

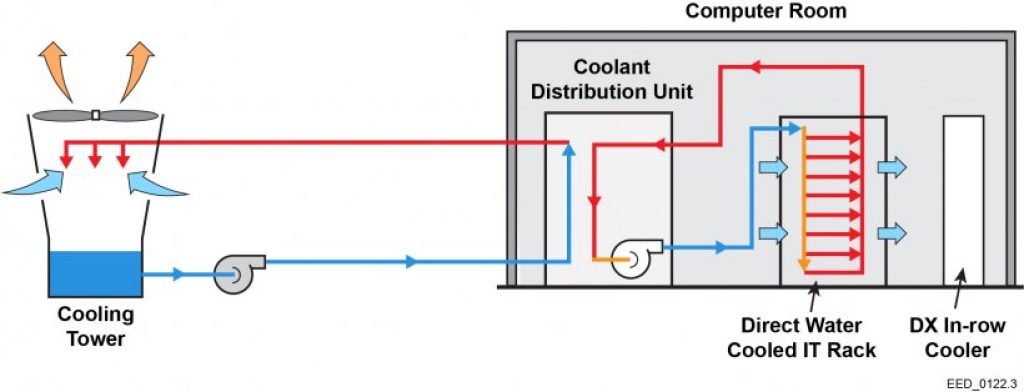

Otra opción es que los sistemas se refrigeren mediante refrigeración líquida. En tal caso, todos los nodos tendrán sus tuberías de cobre para hacer pasar el flujo del agua o el líquido refrigerante usado, y todos ellos irán conectados a otra red de tubos para llevar el líquido desde o hacia los intercambiadores de calor. Estos intercambiadores de calor son similares a los que podemos ver en muchas centrales térmicas, incluidas las nucleares, donde se realiza el intercambio para volver a enfriar el fluido.

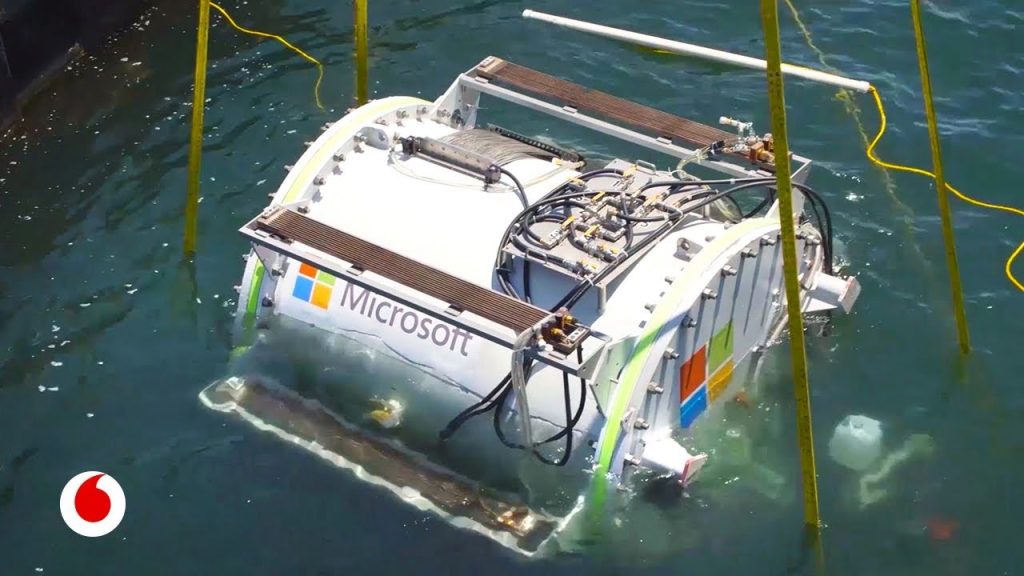

Algunos están proponiendo sumergir los centros de datos bajo el mar en cápsulas, como Microsoft, otros usar viejas plataformas petrolíferas en alta mar y aprovecharlas para instalar allí los centros de datos, usando el agua del mar para refrigerar el centro de datos y así ahorrar energía eléctrica, ya que cogerían agua del mar fría, la harían pasar por el circuito, y la volverían a verter al mar.

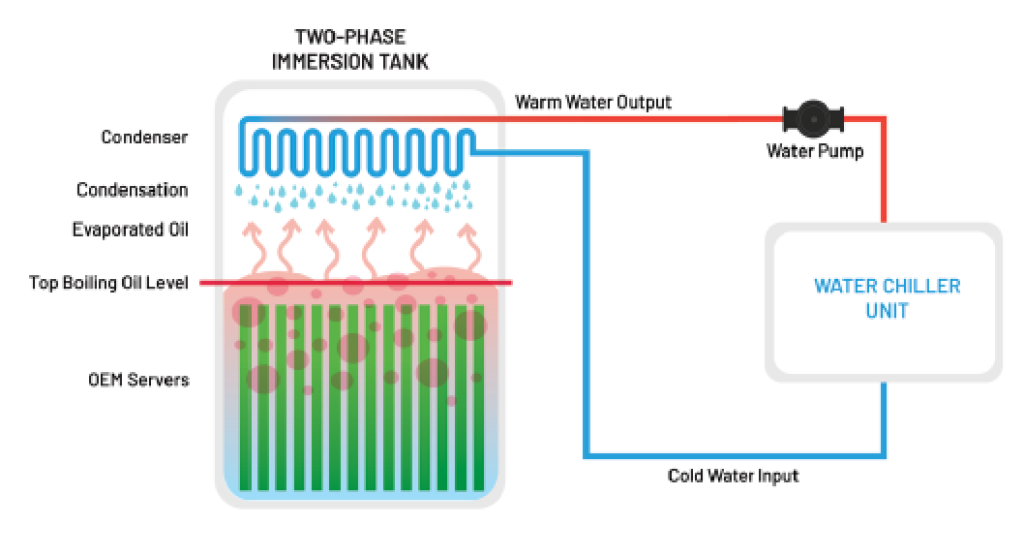

Incluso también se están poniendo en marcha algunas soluciones de la llamada refrigeración por inmersión, que consiste directamente en sumergir la electrónica en un fluido refrigerante, que suele ser un aceite mineral inerte o líquidos artificiales patentados. Estos líquidos no son conductores, por lo que no afectan a la electrónica cuando está en funcionamiento, es decir, no crearían cortocircuitos.

Estas estas formas exóticos buscan reducir el consumo de los enormes sistemas de refrigeración convencionales, que también pueden estar consumiendo del orden de varios MWh.

Centro de Operaciones de Red

El centro de operaciones de red, o también denominado NOC (Network Operations Center) es una sala donde se monitorea y gestiona la red del centro de datos. Aquí, el personal puede supervisar el rendimiento de la red, solucionar problemas y responder a eventos en tiempo real. Es decir, es donde estarán algunos técnicos y administradores con PCs o portátiles que están conectados al servidor para la gestión. No obstante, como he comentado anteriormente, también se puede realizar de forma remota conectándose por SSH, por ejemplo…

Sala de almacenamiento

Algunos centros de datos pueden tener una sala de almacenamiento para guardar repuestos, equipos adicionales y suministros necesarios para el mantenimiento. Aquí se tendrá un retén, un inventario de unidades listas para sustituir a las que se hayan estropeado, como procesadores, discos duros nuevos, etc. Gracias al sistema de monitorización, se detecta el armario y rack que da problemas y el técnico se podrá desplazar con las piezas de repuesto necesarios para su reemplazo y que todo siga igual. Por supuesto, habrá que administrar estos componentes, para que siempre haya piezas preparadas para poder sustituir y satisfacer la demanda que tiene cada centro de datos. No obstante, tampoco se puede pecar de comprar muchas unidades y que sobren y a la hora de actualizar el centro de datos a una versión más moderna ya no sirvan…

Hay que decir que estas tareas son constantes, a diario, ya que al haber tantos componentes funcionando, siempre suele fallar algo, y los técnicos no paran de empujar sus carritos, con las piezas y herramientas que fuesen necesarias, por los distintos pasillos buscando el componente a sustituir. Y, hay que recordar, que estas piezas están pensadas para su sustitución en caliente, sin necesidad de tener que parar todo el centro de datos para un reinicio…

Por otro lado, también puede haber un área de trabajo en estas salas, donde los técnicos pueden tratar de recuperar, limpiar o mantener los dispositivos que componen el servidor.

Tampoco me quiero olvidar de comentar algo, y es que los servidores tienen que estar conectados mediante una red muy poderosa, con un ancho de banda brutal, ya que tienen que soportar la inmensa cantidad de datos entrantes y salientes de todas las peticiones de los clientes del servicio. Todo esto supone una inmensa infraestructura de red que puede estar cableada por rieles aéreos colgados del techo del centro de datos o también se pueden pasar bajo el suelo flotante. Y cada nodo o rack, estará enlazado con el resto mediante cableado de red Ethernet o fibra óptica, por lo que la cantidad de cables que hay que gestionar y ordenar es inmensa, y hay que etiquetarlos para que los técnicos puedan saber cuál desconectar o dónde conectarlo, ya que si no sería un completo caos…

Área de descanso

Los centros de datos pueden tener áreas designadas para que el personal descanse, tome sus comidas, de ocio, etc. Esta parte es muy importante para mantener satisfechos a los trabajadores y mejorar su productividad. Y cada vez más empresas punteras llenan sus centros de este tipo de salas con más y más diversión para que los empleados se sientan a gusto.

La infraestructura y el diseño exactos de un centro de datos pueden variar según el tamaño, la función y los requisitos específicos, pero estos son los componentes fundamentales.

Una visita al centros de datos

En este vídeo puedes hacer un tour por uno de los numerosos centros de datos que Google tiene repartidos por todo el mundo. Aunque puedes usar gafas para mayor inmersión, puedes verlo de forma normal y usar el ratón para mover el punto de vista y poder ver qué hay a tu alrededor en cada escena, como si hicieses una visita virtual…

Para finalizar, me gustaría destacar algunas cosas que más le llama la atención a las personas visitan un centro de datos por primera vez, a menudo se sorprenden por varios aspectos que pueden considerar curiosidades o detalles interesantes. Algunas cosas que suelen llamar la atención de los visitantes son:

- Tamaño y orden: la magnitud física de los centros de datos, con sus numerosos racks y equipos, y salas inmensas que parecen no tener fin, a menudo sorprende a los visitantes. La organización y el orden meticuloso para gestionar cables y equipos también pueden resultar impresionantes.

- Niveles de Seguridad: la cantidad de medidas de seguridad implementadas, como sistemas de control de acceso, vigilancia por cámaras y seguridad física, a menudo sorprende a los visitantes. La necesidad de proteger la integridad de los datos y equipos es evidente en estos entornos.

- Ruido y Enfriamiento: quizás una de las cosas que más sorprende a muchos es el ruido generado por los equipos de refrigeración en un centro de datos. Tanto el calor de los pasillos calientes, como el flujo de aire en los pasillos fríos. No son nada silenciosos estos entornos, y por eso llama bastante la atención.

- Eficiencia Energética: los visitantes a menudo se sorprenden por las iniciativas de eficiencia energética implementadas en los centros de datos modernos. Esto puede incluir tecnologías de enfriamiento avanzadas, sistemas de iluminación eficientes con LED o inteligentes, y el uso de energía renovable.

- Cableado Estructurado: lo numeroso y complejidad del cableado de red y su organización para conectar todos los dispositivos en el centro de datos suelen ser motivo de interés. La gestión de cables es esencial para mantener un entorno ordenado y facilitar el mantenimiento.

- Redundancia y resiliencia: la redundancia en los sistemas, como fuentes de alimentación y conexiones de red, para garantizar la disponibilidad continua de los servicios, a menudo impresiona a los visitantes. La ingeniería para lograr una alta disponibilidad es un aspecto clave en muchos centros de datos.

- Ambiente Controlado: la necesidad de mantener condiciones ambientales controladas, como temperatura y humedad, para garantizar el rendimiento y la vida útil de los equipos, puede sorprender a los visitantes. Los centros de datos a menudo operan en condiciones muy específicas para mantener la estabilidad de los sistemas.

En general, la mayoría de visitantes primerizos se suele sorprender bastante por todo esto, además de por las cifras que se manejan en estas grandes máquinas. Por ejemplo, un centro de datos como el de Facebook puede manejar hasta 4 Petabytes de información al día, lo que te da una idea de las redes tan potentes que debe tener, mientras que la capacidad de almacenamiento puede estar en unos 300 Petabytes o más, consumiendo varios MW en total, con costes millonarios y con salas de 500 metros cuadrados en algunos casos… ¡Todo es Mega!

¡Excelente artículo!

Empecé con un Honeywell Bull 6240 y veo que volvemos

a refrigerar con líquido los servidores de los centros de datos.

Compartimos pasión por estas máquinas 😉