- Microcanales en el silicio dirigen refrigerante justo a los hot spots, con control por IA.

- Hasta 3x más eficiencia térmica y -65% en la temperatura máxima de GPU.

- Más densidad, overclocking controlado y mejor PUE en centros de datos.

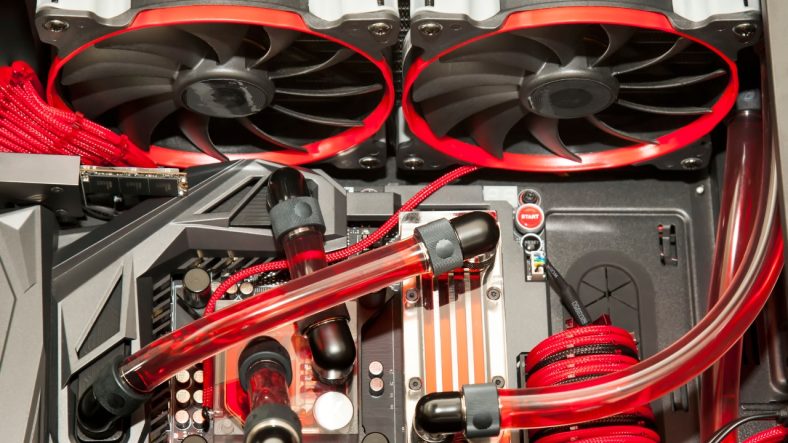

La carrera por acelerar la inteligencia artificial no solo va de transistores y algoritmos: también va de temperatura. Cuando las GPU y los aceleradores trabajan al límite, el calor se convierte en el enemigo número uno del rendimiento y la fiabilidad. En ese contexto, Microsoft ha puesto el foco en una solución que cambia las reglas del juego: introducir el refrigerante dentro del propio silicio mediante microcanales en lugar de enfriar desde fuera.

Este enfoque, conocido como microfluídica o “microfluidics”, se ha mostrado en prototipos en el campus de Redmond y en pruebas de laboratorio sobre servidores y GPU. Según la compañía, es capaz de evacuar calor hasta tres veces mejor que las placas frías tradicionales y de contener el aumento de la temperatura máxima de una GPU hasta en un 65%. No es un simple ajuste incremental: es una arquitectura térmica que apunta a más densidad, más potencia y menos consumo en los centros de datos.

Qué es la refrigeración por microfluidos integrada en el chip

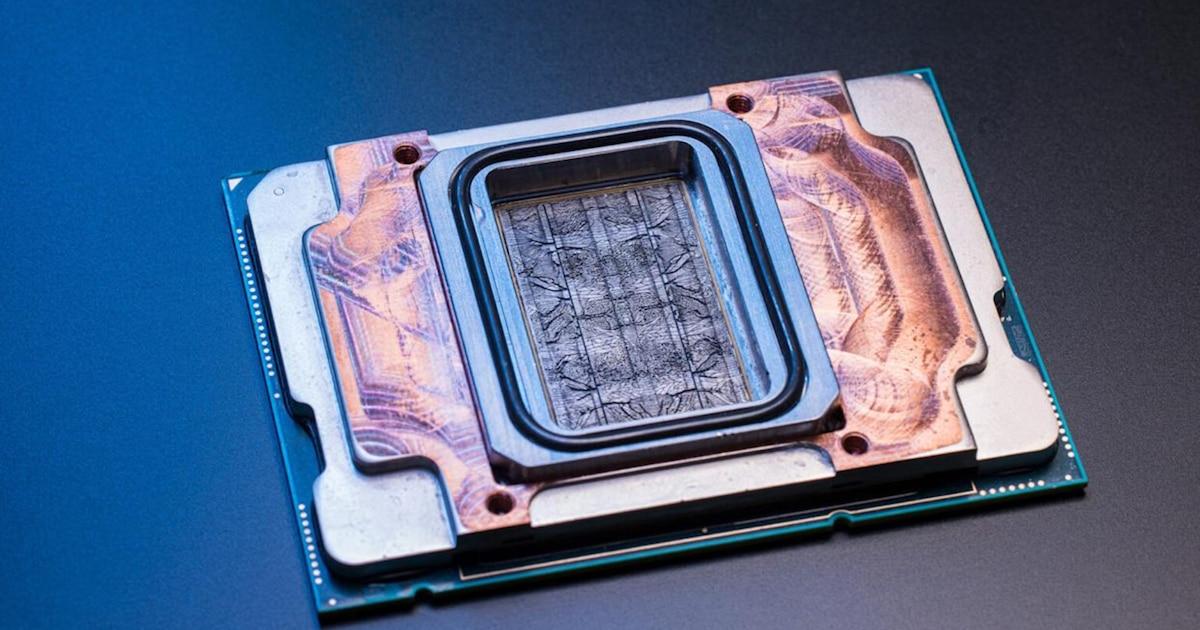

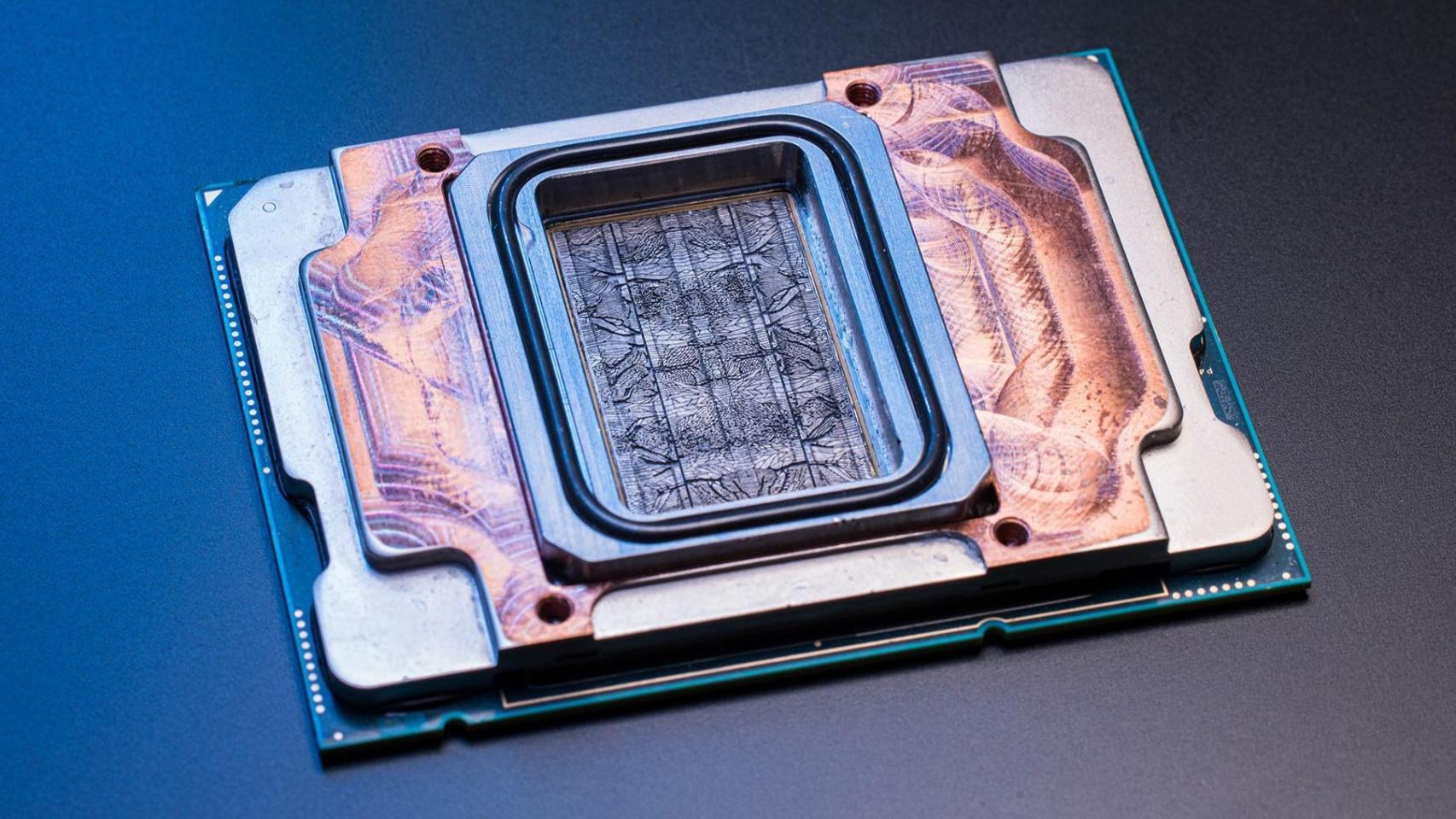

La idea de fondo es sencilla de explicar y muy compleja de ejecutar: grabar microcanales del ancho de un cabello humano en la cara posterior del chip para que circule por ellos un líquido refrigerante. Con estos canales, el fluido llega justo a los puntos donde más se concentra el calor, los llamados “hot spots”, y lo extrae con una eficiencia que no se consigue cuando hay capas intermedias entre el silicio y el sistema de refrigeración.

Microsoft ha demostrado este sistema en condiciones de laboratorio, incluyendo una demo bajo microscopio y pruebas en un servidor que simulaba una reunión de Microsoft Teams. En estas pruebas, la microfluídica funcionó a temperaturas de refrigerante relativamente altas (hasta 70 °C en algunos casos) sin perder eficacia, lo que abre la puerta a diseños más sencillos en la planta de enfriamiento del centro de datos.

Las primeras integraciones se han hecho en chips de servidores utilizados para aplicaciones en la nube de Office y en GPU destinadas a cargas de trabajo de IA. Aunque la tecnología todavía debe validarse en producción, el salto de rendimiento térmico respecto a placas frías convencionales ya se ha cuantificado en el laboratorio.

Un punto clave es el fluido: Microsoft asegura que puede emplearse el mismo refrigerante que en muchas placas frías actuales, es decir, una mezcla de agua y propilenglicol. Esto facilita la compatibilidad con infraestructuras de refrigeración líquida ya existentes y rebaja barreras de adopción.

Cómo funciona: canales microscópicos, IA y diseño bioinspirado

A nivel físico, los microcanales se graban directamente en la parte posterior del chip y el encapsulado se rediseña para crear un circuito cerrado, hermético y seguro al paso de líquido. En lugar de “barrer” calor desde la superficie, el sistema ataca el problema donde nace: dentro de las capas más cercanas al silicio activo.

Para decidir por dónde y cuánto fluido enviar, Microsoft utiliza modelos de IA que detectan en tiempo real los hot spots y ajustan el caudal. Esta capa de “control inteligente” permite que el refrigerante se dirija con precisión quirúrgica a las zonas críticas, maximizando la eficiencia térmica y evitando caídas de rendimiento por throttling.

El patrón de canales no es rectilíneo al uso. En colaboración con la startup suiza Corintis, el equipo ha diseñado una estructura inspirada en la naturaleza, similar a las venas de una hoja o las alas de una mariposa. Este trazado biomimético distribuye el fluido de forma más homogénea y reduce puntos de fallo, al tiempo que ayuda a mantener baja la pérdida de carga dentro del chip.

El resultado no solo es un mejor contacto térmico: con menos capas de aislamiento y el refrigerante tocando directamente el silicio caliente, el líquido no necesita estar tan frío para hacer su trabajo. Esa relajación en los requisitos de temperatura del circuito secundario reduce la energía necesaria para enfriar, lo que impacta de lleno en la factura eléctrica del centro de datos.

Ventajas medibles: 3x de eficiencia, -65% en GPU y margen para picos

Las cifras publicadas por Microsoft en sus pruebas de laboratorio son contundentes: el sistema de microfluidos elimina el calor hasta tres veces mejor que las placas frías y reduce el incremento máximo de temperatura en el silicio de una GPU hasta un 65%. En la práctica, se traduce en más rendimiento sostenido y menos degradación por calor.

Una consecuencia directa es la posibilidad de “sobrecalentar” los chips de forma controlada durante picos breves de demanda, lo que toda la vida hemos llamado overclocking o aumentar la frecuencia de reloj. En vez de sobredimensionar hardware para esos momentos puntuales, el centro de datos puede exprimir temporalmente los chips que ya tiene sin comprometer su fiabilidad, gracias a una evacuación térmica más rápida y precisa.

Además de desbloquear rendimiento, este enfoque mejora la densidad. El contacto directo con el silicio permite crear servidores más compactos y con mayor potencia por unidad de espacio, reduciendo costes de infraestructura. En escenarios con picos de trabajo, Microsoft sostiene que podría no ser necesario añadir más máquinas, porque el mismo rack aguanta más carga con mejor refrigeración.

También hay beneficios operativos: menos necesidad de bajar tanto la temperatura del refrigerante, mejor consistencia del rendimiento entre servidores y margen para reutilizar el calor residual en otros usos. Todo ello contribuye a mejorar el PUE (Power Usage Effectiveness) y a rebajar la huella de carbono de instalaciones que, según la IEA, podrían alcanzar cerca de 1.000 TWh de consumo para 2026 si no se optimizan.

Retos de ingeniería: grabado, encapsulado y fluido adecuados

Hacer pasar líquido por la “espalda” de un chip no es coser y cantar. Los canales han de ser lo bastante profundos para que no se obstruyan, pero no tanto como para debilitar la integridad del silicio. Además, el encapsulado debe ser hermético y fiable a largo plazo, porque una fuga en un servidor es lo último que quieres en un centro de datos.

Por si fuera poco, hay que afinar la fórmula del refrigerante: equilibrar conductividad térmica, viscosidad, compatibilidad de materiales y riesgos de corrosión. Microsoft ha probado distintas mezclas, con el objetivo de mantener compatibilidad con infraestructuras existentes y evitar problemas como depósitos o bloqueos en los microcanales que comprometerían el rendimiento.

En este proceso de iteración, Microsoft y Corintis han realizado múltiples versiones del diseño, realizando cuatro iteraciones en un año para ajustar tanto geometrías como procesos de fabricación. La colaboración ha permitido adoptar patrones bioinspirados que mejoran la distribución del fluido sin penalizar demasiado la caída de presión, algo crítico cuando se habla de miles de chips trabajando a la vez.

Aunque el sistema ya ha sido probado con éxito en laboratorio y en servidores de pruebas, la compañía aún necesita demostrarlo en producción a gran escala. Microsoft no ha marcado una fecha concreta de despliegue; su hoja de ruta pasa por validar en entornos reales y por estandarizar la tecnología con socios para que llegue a la industria de semiconductores más allá de sus propios centros de datos.

Impacto en la arquitectura de chips: HBM, apilado 3D y más densidad

La microfluídica no solo enfría mejor; habilita nuevas arquitecturas. Uno de los grandes cuellos de botella al apilar chips en 3D es el calor. Con canales que atraviesan el paquete para evacuar calor entre capas, Microsoft estudia soluciones como pines cilíndricos para hacer pasar el fluido entre “pisos” de silicio, algo parecido a pilares que conectan niveles en un parking.

Hoy, la memoria de alto ancho de banda (HBM) es crítica en IA. Microsoft reconoce que su chip Maia depende de HBM disponible en el mercado y, como señaló la compañía, “hoy en día la HBM lo es todo”. El siguiente paso es explorar qué viene después y cómo diseñar el sistema de refrigeración pensando también en la memoria, que cada vez concentra más calor en menos espacio.

Este trabajo térmico encaja con una estrategia más amplia de personalización del hardware de centros de datos. Microsoft ha sumado más de 2 gigavatios de capacidad en el último año y, en paralelo a la microfluídica, apuesta por fibra óptica de núcleo hueco para redes internas, que utiliza aire en lugar de vidrio para transportar la luz. En el laboratorio, un trozo de material de pocos centímetros puede estirarse para conectar varios kilómetros, con socios como Corning y Heraeus Covantics impulsando su producción.

En el plano de CPU/GPU, la compañía trabaja en sus familias de chips, como Cobalt y Maia, y estudia cómo llevar la microfluídica a próximas generaciones. La meta no es solo escalar rendimiento, sino hacerlo con servidores más compactos, con mayor densidad energética y mejor consistencia del comportamiento entre nodos.

Operación y sostenibilidad: menos energía, mejor PUE y presión menor en la red

La refrigeración es una parte enorme de la factura eléctrica de un centro de datos. Con microfluidos, el refrigerante puede trabajar a temperaturas más altas y aún así ser eficaz, lo que significa menos energía dedicada al enfriamiento del propio líquido. Esta bajada de consumo ayuda a mejorar el PUE y reduce la presión sobre las redes eléctricas de las comunidades cercanas, como destaca Microsoft.

Además, al mantener temperaturas más controladas en el silicio, se alarga la vida útil de los equipos y se evitan ciclos de mantenimiento asociados al estrés térmico. En ciertos casos, el calor residual puede aprovecharse para calefacción u otros usos, otra vía para mejorar la sostenibilidad global de las instalaciones.

En un panorama donde la inteligencia artificial empuja la demanda energética al alza, los centros de datos necesitan avances que permitan más rendimiento con menos infraestructura adicional. La promesa de la microfluídica es que, con mejor disipación en el chip, no haga falta construir nuevos edificios para atender picos de carga y se pueda exprimir más cada servidor.

Todo esto requiere inversión. Microsoft ha anunciado fuertes desembolsos en infraestructura, con cifras de decenas de miles de millones de dólares, incluyendo planes para destinar en torno a 30.000 millones en un trimestre según comunicados recientes. La apuesta no es solo por más capacidad, sino por soluciones que hagan esa capacidad más eficiente y sostenible.

Voces y validación: del laboratorio al centro de datos

Distintas figuras técnicas de Microsoft han puesto contexto a este avance. Sashi Majety advierte que apoyarse únicamente en tecnología de placas frías llevará a un punto muerto; Husam Alissa subraya que hay que pensar en sistemas, entendiendo la interacción entre silicio, fluido, servidor y centro de datos; y Judy Priest apunta a diseños más densos en potencia, con más funciones y mejor rendimiento en menos espacio.

Por su parte, Rani Borkar recalca la importancia de la eficiencia cuando se opera a escala de hiperescalador; Jim Kleewein destaca que con microfluidos se puede aumentar la velocidad en momentos críticos sin sacrificar fiabilidad; y Ricardo Bianchini recuerda el efecto positivo sobre la red eléctrica al consumir menos energía para enfriar los centros de datos.

También hay un matiz interesante: al tocar directamente el silicio, el sistema permite trabajar con el refrigerante a temperaturas más elevadas sin perder eficacia, un cambio que simplifica el chiller y reduce pérdidas. En la otra punta de la cadena, la fibra de núcleo hueco y otros desarrollos de red demuestran que la estrategia de Microsoft abarca desde el transistor hasta la conectividad.

Finalmente, aunque Microsoft históricamente no fabricaba ni diseñaba procesadores, hoy impulsa diseños propios como Maia y Cobalt y busca que la microfluídica se convierta en un estándar de industria. En paralelo, la empresa ha probado ya la tecnología en servidores para Office y en GPU para IA, un paso necesario antes de llevarla a despliegues masivos.

La microfluídica apunta a convertirse en pieza clave del puzle para seguir escalando IA sin romper el presupuesto energético. Con un sistema que enfría desde dentro, inspirado en la naturaleza y guiado por IA, Microsoft se posiciona para poner más músculo de computación en menos espacio, con menos energía y menos emisiones. Todavía quedan validaciones en producción, pero el camino que marcan los prototipos indica que el techo térmico de los centros de datos está más lejos de lo que parecía.