- La IA local permite procesar textos, imágenes y documentos sensibles sin que tus datos salgan de tu dispositivo, reduciendo exposición y dependencia de la nube.

- Herramientas como LM Studio, Ollama o Comfy facilitan ejecutar modelos abiertos en Windows, macOS y Linux, siempre que elijas bien el modelo y la cuantización según tu hardware.

- La combinación de marcos legales (RGPD, AI Act), buenas prácticas de gobernanza de datos y técnicas de anonimización es clave para un uso responsable de IA.

- Descargar modelos desde repositorios fiables y configurar clientes abiertos en local te da mayor soberanía, control y privacidad frente a los servicios masivos en la nube.

La inteligencia artificial se ha colado en nuestro día a día casi sin darnos cuenta, pero rara vez pensamos en qué pasa con nuestros datos cuando usamos estos sistemas. Cada chat, cada imagen que generas, cada documento que subes a la nube deja un rastro que puede acabar almacenado, analizado y reaprovechado para entrenar modelos sin que tengas un control real.

Por suerte, en paralelo al auge de la IA en la nube han madurado las soluciones de IA local que funcionan directamente en tu ordenador. Esta forma de trabajar cambia por completo las reglas del juego: ganas privacidad, control y soberanía sobre tus datos a cambio de asumir algo más de complejidad técnica y ciertos requisitos de hardware.

Qué significa realmente proteger la privacidad al usar IA local

Cuando hablamos de privacidad en inteligencia artificial no nos referimos solo a cumplir con leyes como el RGPD, sino a algo más amplio: que tú decidas qué datos se recogen, dónde se procesan, quién puede verlos y con qué fines se utilizan. Aquí es donde la IA local marca la diferencia frente a los servicios masivos en la nube.

Los grandes modelos en la nube se alimentan de volúmenes gigantescos de datos: textos, imágenes, historiales de navegación, patrones de comportamiento, ubicaciones, registros de salud o financieros… buena parte de esa información se recoge de forma automatizada, muchas veces mediante rastreos web o a través de condiciones de uso que casi nadie lee con detalle.

Incluso cuando los proveedores prometen no usar tus chats para entrenar modelos, es frecuente que parte de tus interacciones se almacenen para “mejorar el servicio”. Esto crea una zona gris: no está siempre claro qué se guarda, durante cuánto tiempo ni qué técnicos o sistemas tienen acceso a ello.

Además, los modelos avanzados no solo memorizan, también son capaces de inferir información sensible a partir de datos aparentemente inocuos. Combinando estilo de escritura, horarios de conexión, temas recurrentes o detalles de contexto, un sistema puede aproximar tus intereses, tu perfil socioeconómico o incluso tu identidad, aunque no hayas escrito tu nombre de forma explícita.

En cambio, cuando ejecutas la IA en tu propio equipo, el flujo cambia radicalmente: los datos no salen de tu dispositivo, no pasan por servidores de terceros y eres tú quien decide qué se guarda y qué se borra. Esto no elimina todos los riesgos (por ejemplo, malware en tu PC seguiría siendo un problema), pero sí reduce mucho la superficie de exposición frente a grandes empresas, proveedores de nube y atacantes externos.

IA local en la práctica: herramientas y casos de uso

En los últimos años han surgido aplicaciones pensadas para que cualquier persona pueda descargar modelos de IA y ejecutarlos en local sin volverse loca con la línea de comandos. Algunas se centran en lenguaje, otras en imagen o vídeo, y muchas permiten combinarlas en flujos de trabajo complejos.

Uno de los escenarios más claros donde la IA local brilla es el tratamiento de documentos altamente confidenciales. Piensa en historiales clínicos, contratos con cláusulas sensibles, informes internos o documentación legal. Con modelos locales puedes transcribir PDFs escaneados, resumirlos, traducirlos o redactar respuestas basadas en su contenido sin que ese material abandone tu ordenador.

Lo mismo ocurre con la creación de contenido visual: hoy en día es perfectamente posible generar imágenes de calidad, editar fotografías o reinterpretar escenas usando modelos locales de difusión estable y herramientas de flujo nodal, sin tener que subir nada a servicios externos que podrían reutilizar tus creaciones para entrenar sus propios sistemas.

También en programación y automatización la IA local es muy útil: puedes pedir a un modelo que revise código fuente de tu empresa, genere scripts internos o analice logs extremadamente sensibles con la tranquilidad de que esos archivos no se envían a ningún proveedor de terceros.

Para orquestar todo esto existen clientes que actúan como “centro de mando” de tus modelos locales: descargan, gestionan, actualizan y exponen interfaces de chat o APIs compatibles con herramientas externas. Esto permite montar flujos de trabajo completos con alto nivel de privacidad y sin depender de la nube.

LM Studio: una puerta de entrada sencilla a los LLM locales

LM Studio es una de las aplicaciones más interesantes para quien quiere empezar con modelos de lenguaje en local sin pelearse demasiado con la consola. Se trata de un programa de escritorio gratuito disponible para Windows, macOS y Linux diseñado para simplificar la descarga, configuración y uso de LLMs (modelos de lenguaje extensos) en tu propia máquina.

La gran diferencia respecto a los servicios web típicos es que LM Studio funciona incluso sin conexión a Internet una vez que has descargado los modelos. Tus preguntas, documentos y conversaciones no se envían a servidores externos, algo especialmente relevante si trabajas con proyectos confidenciales o si, sencillamente, no quieres que nadie use tus datos para entrenar algoritmos.

La interfaz es bastante amigable. En el lateral encuentras secciones como Chat, Developer, My models y Discover. Desde Chat mantienes conversaciones con el modelo seleccionado, con histórico de mensajes; en Developer los perfiles técnicos pueden ajustar parámetros avanzados o hacer scripts; en My models gestionas lo que tienes descargado; y Discover es un buscador integrado de modelos disponibles.

En el área de ajustes puedes cambiar el idioma, comprobar la configuración de la GPU, ver el uso de RAM y CPU o afinar detalles de rendimiento. Lo habitual es que tras la instalación todo quede listo para funcionar, pero si te gusta trastear tienes campo de sobra.

Para empezar a usar la IA necesitas descargar uno o varios modelos. Desde la sección de búsqueda puedes filtrar por nombre (Llama, Mistral, DeepSeek, etc.), formato (como GGUF) y tamaño. Aquí es clave encontrar el equilibrio entre tamaño de modelo y rendimiento: cuanto más grande, mayor calidad potencial, pero también más consumo de memoria y recursos.

Requisitos de hardware y cuantización de modelos

La buena noticia es que ya no hace falta un superordenador para usar IA local, pero sí es importante ajustar el modelo al hardware real que tienes; para ello consulta nuestra guía para elegir un PC o portátil con potencia real de IA. En macOS, LM Studio saca especial partido de los chips Apple Silicon (M1, M2, M3, M4) con al menos 16 GB de RAM y versiones modernas de macOS. Los Mac con procesador Intel, en este caso concreto, se quedan fuera de juego.

En Windows, la aplicación funciona tanto en arquitecturas x64 como ARM, aunque de nuevo se recomienda contar con 16 GB de RAM como mínimo y, si es posible, una tarjeta gráfica con al menos 6 GB de VRAM para que los modelos medianos se muevan con soltura. En Linux suele distribuirse como AppImage, con soporte para x64 y versiones recientes de Ubuntu o equivalentes.

Más allá del hardware bruto, entra en juego el concepto de cuantización, que verás etiquetado en los modelos como Q2, Q4, Q5, Q8 y similares. Son técnicas de compresión que reducen el tamaño del modelo a costa, en mayor o menor medida, de la precisión.

Un modelo en Q2 es muy ligero y rápido, ideal para máquinas modestas o tareas sencillas, pero sus respuestas suelen ser menos afinadas. La cuantización Q4 suele considerarse el punto de equilibrio entre consumo de memoria, velocidad y calidad, por lo que sirve como “coche de batalla” para la mayoría de usuarios.

Si dispones de un equipo potente, Q5 suele ser el “punto dulce”: cercano en calidad al modelo original, pero aún razonable en recursos. Q8, en cambio, busca la máxima fidelidad, a costa de requerir mucha VRAM y memoria. En términos prácticos, si tu ordenador es básico apunta a Q4; si tienes buen hardware y quieres la mejor calidad posible, experimenta con Q5 o Q8. Si además trabajas con aceleradores M.2, revisa opciones como Axelera Metis M.2 Max.

Gestión de modelos y uso del chat en LM Studio

Una vez descargados, LM Studio te ofrece un auténtico “garaje” de modelos locales desde la sección My models. Ahí puedes ver qué tienes instalado, el tamaño en disco, la versión, el consumo de recursos y el directorio donde se guardan los archivos.

Desde ese mismo panel puedes activar un modelo para usarlo en el chat, eliminarlo si te falta espacio o tocar parámetros de inicialización para ajustar su personalidad o comportamiento. Esto incluye, por ejemplo, el prompt de sistema, el nivel de creatividad o la longitud máxima de las respuestas.

El panel de chat funciona de forma muy parecida a un chatbot en la nube: escribes tu prompt y el modelo responde. La diferencia está en que aquí la conversación se queda en tu disco y tú decides qué hilos guardar, cuáles borrar y cuáles reutilizar. Puedes retomar diálogos anteriores, afinar prompts, o utilizar hilos como plantillas para tareas recurrentes.

Como en cualquier IA, la calidad de lo que obtienes depende mucho de cómo formules tus peticiones. Ser claro, dar contexto, dividir tareas complejas en pasos y probar variaciones de instrucciones marca la diferencia. El famoso “prompt engineering” sigue siendo clave aunque todo corra en local.

Conviene también ir haciendo limpieza de modelos que ya no uses, sobre todo si trabajas con varios tamaños o variantes. Los archivos pueden ocupar muchos gigas, así que gestionar el espacio en disco es parte de la experiencia de IA local, igual que actualizarlos periódicamente para aprovechar mejoras de rendimiento y seguridad; considera además soluciones de memoria flash de alto ancho de banda para almacenar pesos y modelos grandes.

Otras herramientas de IA local: Ollama, Comfy y clientes de chat

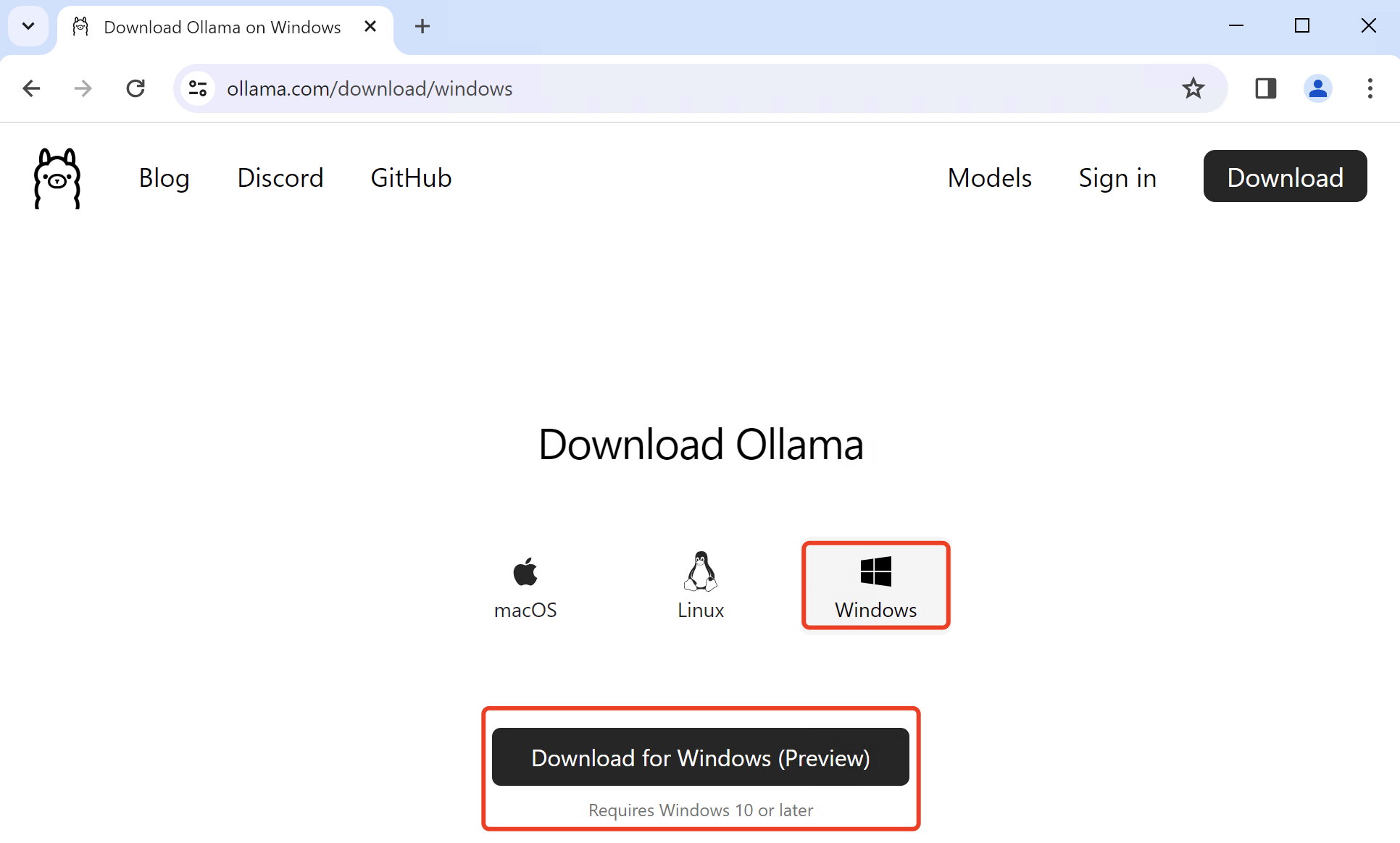

LM Studio no está solo. Existen otras plataformas que facilitan la ejecución de modelos en local, cada una con su enfoque. Ollama, por ejemplo, está muy orientada a la línea de comandos: con un simple “ollama run llama3.2” descarga y arranca el modelo correspondiente, exponiendo una interfaz de chat local o una API compatible con muchas integraciones.

Ollama mantiene su propia biblioteca de modelos, lo que ayuda a garantizar cierto filtrado de calidad y seguridad, evitando que el usuario tenga que comprobar manualmente la procedencia de cada archivo. Además, se lleva bien con scripts y flujos de trabajo automatizados, algo muy apreciado por desarrolladores.

En el terreno visual, una de las referencias es Comfy (ComfyUI), una herramienta open source pensada para generar y editar imágenes con IA mediante flujos de nodos. Permite conectar modelos de difusión, módulos de control, upscalers y demás piezas de la cadena para crear pipelines visuales potentes totalmente en local.

También existen clientes de chat especializados como Kobold.cpp o Llamafile, pensados para exprimir al máximo modelos locales. Kobold.cpp da bastante control sobre parámetros como temperatura, penalización de repetición o prompts de sistema, e incluso permite crear túneles de red para usar tus modelos desde otros dispositivos.

Llamafile apuesta por empaquetar modelos en ejecutables autocontenidos, lo que simplifica la distribución, aunque tiene limitaciones en Windows por el tamaño máximo de los .exe. En muchos casos, la solución práctica es cargar pesos externos en lugar de depender solo de esos ejecutables, especialmente si trabajas con modelos grandes.

Por qué los LLM en la nube plantean problemas de privacidad

La popularización de los chats de IA en la nube viene acompañada de preocupaciones crecientes por la privacidad. Estos sistemas se entrenan y afinan con enormes cantidades de datos, y a menudo es imposible saber con exactitud qué información personal se ha colado en el conjunto de entrenamiento.

En la fase de ingestión de datos, el riesgo se dispara: se mezclan datos públicos raspados de la web con información potencialmente sensible publicada en foros, redes sociales o documentos accesibles pero no pensados para ser reutilizados a gran escala. A veces ni siquiera se ha obtenido un consentimiento claro para ese uso concreto.

Durante el entrenamiento, aunque los datos se hayan recopilado legalmente, el modelo puede acabar utilizando esa información para fines distintos a los originales. Muchas personas aceptarían que una empresa use sus datos para gestionar su cuenta, pero no para entrenar un sistema que luego se vende como producto aparte.

En fase de inferencia, el problema cambia de forma: los modelos son capaces de hacer inferencias muy precisas a partir de entradas aparentemente inocuas, reconstruir información anonimizada o amplificar sesgos presentes en los datos de origen. Incluso podrían llegar a reproducir fragmentos de datos personales que estaban en el dataset de entrenamiento.

Por último, la capa de aplicación (APIs, frontends web, integraciones) es un punto de ataque evidente. Una mala configuración de permisos, respuestas demasiado detalladas, errores de logging o fallos de seguridad en la API pueden exponer datos sensibles de usuarios o de sistemas internos a atacantes o a terceros no autorizados.

Leyes y marcos regulatorios sobre IA y privacidad

La explosión de la IA ha forzado a los gobiernos a actualizar su legislación en materia de protección de datos. Más de un centenar de países cuentan ya con leyes de privacidad a nivel nacional, y aunque muchas no son específicas de IA, cualquier sistema que trate datos personales debe cumplirlas.

En Europa, el Reglamento General de Protección de Datos (RGPD) exige que la recogida y uso de datos personales sea justa, transparente y limitada a una finalidad concreta. Obliga a minimizar la cantidad de datos, reducir la retención al tiempo estrictamente necesario y aplicar medidas de seguridad fuertes. Todo modelo de IA que procese datos personales entra de lleno en este paraguas.

La Ley de IA de la Unión Europea (AI Act) añade una capa específica: clasifica los sistemas de IA según su nivel de riesgo, prohíbe usos considerados inaceptables (como el scoring social masivo) y establece obligaciones mucho más duras para las aplicaciones de alto riesgo, entre ellas las que afectan a empleo, educación, infraestructuras críticas o algunos tipos de vigilancia.

En Estados Unidos, la regulación es más fragmentada, con leyes estatales como la California Consumer Privacy Act (CCPA), la normativa de Texas o la ley de Utah sobre IA generativa, que insisten en derechos como saber qué datos se recopilan, pedir su eliminación o optar por que no se vendan ni se usen para ciertos fines.

Además de las leyes, surgen marcos de buenas prácticas como el AI Risk Management Framework del NIST, que propone un ciclo continuo de gobierno, mapeo, medición y gestión del riesgo. Este enfoque ayuda a las organizaciones a valorar impacto, definir controles, medir su eficacia y actualizar sus políticas a medida que la tecnología evoluciona.

Buenas prácticas para proteger la privacidad con IA

Más allá de las obligaciones legales, cualquier organización que quiera usar IA de forma responsable debe implantar políticas sólidas de gobernanza de datos. Esto pasa por clasificar la información según su sensibilidad, limitar el acceso por roles, definir políticas de cifrado, anonimización y pseudonimización, y establecer auditorías periódicas.

Un principio clave es la minimización de datos: recoger solo lo estrictamente necesario para la función concreta del sistema. Reducir la cantidad de información almacenada y procesada no solo baja el riesgo de filtraciones, también facilita cumplir la normativa y simplifica la arquitectura de seguridad.

Es fundamental obtener consentimiento informado y explícito cuando se tratan datos personales. Esto implica explicar de forma clara qué se va a hacer con esos datos, si se usarán para entrenar modelos, cuánto tiempo se guardarán y cómo se pueden ejercer derechos de acceso, rectificación o borrado.

Otro punto clave es revisar la cadena de suministro de datos y modelos. Si utilizas datasets o modelos de terceros, debes asegurarte de que fueron recopilados y entrenados cumpliendo buenas prácticas de privacidad y que sus licencias encajan con el uso que tú quieres hacer.

Por último, conviene complementar todo esto con medidas clásicas de ciberseguridad (control de identidades, cifrado en tránsito y reposo, segmentación de redes, monitorización de anomalías) y con una evaluación continua del riesgo, ya que la IA evoluciona muy rápido y aparecen nuevos vectores de ataque con frecuencia.

Anonymización y estrategias para no exponer datos sensibles

En muchos proyectos de IA no queda más remedio que trabajar con datos personales o extremadamente sensibles. En estos casos, la anonimización y la pseudonimización se convierten en herramientas imprescindibles para reducir riesgos sin renunciar a la utilidad de la información.

Entre las técnicas más habituales está el enmascaramiento de datos, que sustituye valores reales (por ejemplo, números de documento, cuentas bancarias, direcciones exactas) por valores ficticios pero coherentes. Esto permite hacer pruebas o análisis sin exponer información real.

La pseudonimización reemplaza identificadores directos (como nombres o IDs internos) por códigos, de forma que solo alguien con acceso a la tabla de correspondencia pueda reidentificar a la persona. Es muy útil cuando necesitas mantener cierto seguimiento longitudinal sin conocer la identidad real.

La generación de datos sintéticos es otra vía en auge: se entrenan modelos para crear datasets artificiales con las mismas características estadísticas que los originales, pero sin contener registros reales. Bien aplicada, esta técnica permite entrenar modelos o compartir datos con terceros minimizando la exposición.

La privacidad diferencial añade “ruido” matemático a los datos o a los resultados de consultas, de forma que no sea posible inferir información sobre individuos concretos aunque se analicen muchos outputs. Es especialmente valiosa en contextos donde se publican estadísticas agregadas.

K2View, Privitar, Anonos, IBM InfoSphere Optim o ARX son algunas de las soluciones comerciales y de código abierto que implementan estas técnicas. Ayudan a definir reglas según el tipo de dato y el marco legal aplicable, algo clave cuando trabajas en sectores regulados como sanidad o finanzas.

Cómo reducir la huella que dejas al usar IA en la nube

Si no puedes o no quieres prescindir de la IA en la nube, al menos conviene aplicar una “higiene digital” básica. Lo primero es evitar proporcionar datos de identificación personal (PII) en tus prompts: nombres reales, direcciones, teléfonos, identificadores de clientes o detalles financieros concretos; y, si usas Windows, aprende a eliminar la telemetría en Windows 11 para reducir fugas adicionales.

Cuando necesites tratar información sensible, acostúmbrate a anonimizarla manualmente en tu texto (“Cliente A”, “Empresa X”, montos aproximados…) antes de pegarla en el chat. Es un pequeño esfuerzo que reduce mucho los riesgos si esa información se almacena para entrenar futuros modelos.

Otra estrategia útil es separar tu uso personal y profesional de la IA. Por ejemplo, tener una cuenta vinculada a tu correo corporativo para herramientas empresariales, y otra personal para hobbies o temas privados. Mezclarlo todo crea perfiles muy detallados que unen vida profesional y personal de forma difícil de deshacer.

Muchas plataformas permiten desactivar el historial de chats o el uso de tus datos para entrenamiento. Activar estas opciones suele hacer que la IA sea menos “cómoda” (no recuerda conversaciones anteriores), pero a cambio mejora tu privacidad. Es un equilibrio que conviene valorar según el contexto de cada uso.

Para publicaciones online (blogs, webs, portfolios) también puedes bloquear rastreadores de IA como GPTBot o Google-Extended mediante el archivo robots.txt o filtrando por user-agent e IP. No es infalible, pero dificulta que tus contenidos sean absorbidos para entrenar modelos generativos sin tu permiso.

IA local para máxima soberanía de datos: criterios y descarga segura

Cuando manejas información realmente delicada, la opción más prudente suele ser dar el salto a lo que algunos llaman “IA soberana”: modelos que se ejecutan 100 % en tu propia máquina, sin llamadas externas. Aquí entran en juego los criterios mínimos que debería cumplir cualquier solución que te plantees usar.

Lo ideal es apostar por software de código abierto y multiplataforma, que no envíe datos personales a terceros, no requiera conexión permanente a Internet para funcionar y ofrezca la opción de usar tanto CPU como GPU según el caso. También es un plus que la instalación sea relativamente sencilla y que incluya alguna forma de descarga integrada de modelos; además, hay movimiento en la industria hacia tarjetas NPU dedicadas para PC que podrían cambiar el panorama.

Para conseguir los modelos en sí, una fuente de referencia es Hugging Face, donde se alojan proyectos de empresas como Meta, Mistral, Microsoft o Google, además de multitud de modelos comunitarios y ajustes finos. Aquí tienes formatos como GGUF que están muy optimizados para uso en hardware de consumo.

Eso sí, al descargar modelos desde repositorios abiertos conviene ser cuidadoso. Revisa la ficha del modelo, las estadísticas de descargas, la documentación, los comentarios de la comunidad y, si es posible, el distintivo de organización verificada. Muchos proyectos ofrecen hashes (como SHA256) para que puedas comprobar que el archivo descargado no ha sido manipulado.

En general, combinar clientes como LM Studio, Ollama, Kobold.cpp o Comfy con modelos obtenidos de fuentes fiables y con buenas prácticas de anonimización te permite construir un entorno de IA potente, flexible y con las mínimas renuncias posibles en materia de privacidad.

A medida que la regulación se endurece y los usuarios toman conciencia del valor de sus datos, la balanza se inclina hacia soluciones que respetan mejor la confidencialidad: la IA local encaja muy bien en este nuevo escenario, ofreciendo rapidez y autonomía a cambio de un poco más de responsabilidad técnica por parte del usuario.