Actualizado a: 19 de enero de 2024

Las interfaces de usuario de los ordenadores han ido evolucionando a lo largo de los años, desde las primeras máquinas con luces y elementos mecánicos, pasando por las primeras interfaces de modo texto hasta las actuales. Pues bien, en este artículo te vamos a mostrar cómo son esas interfaces, cómo han ido evolucionando y cuál es el futuro que nos espera.

Quizás también te interese conocer:

¿Qué es una interfaz de usuario?

Una UI (User Interface), o interfaz de usuario, no es más que un elemento que permite la interacción o comunicación entre un humano y un ordenador o máquina. Para que esto sea posible, se pueden usar multitud de elementos, desde pantallas, hasta periféricos de entrada como el teclado o el ratón, pasando por otros muchos.

Además, estas interfaces pueden estar presentes tanto en el sistema operativo, como en las apps, así como en las webs, etc. De hecho, el mundo de la computación en la nube y todos los servicios existentes online, han hecho que estas interfaces de usuario basadas en web sean especialmente críticas en la actualidad.

En definitiva, la interfaz de usuario es el espacio donde se permite las interacciones entre el humano y la máquina, de forma bidireccional en la mayoría de los casos. Así es como se permite el manejo de los actuales sistemas. Por supuesto, tiene que permitir que la interactuación sea lo más fácil, eficiente e intuitiva posible, para maximizar la productividad y la usabilidad.

Para que la interfaz de usuario sea posible, es necesario que haya varias componentes o capas en el sistema, y los más esenciales pasan por la HMI (Human-Machine Interface). Será la parte que conecta el usuario a la máquina con hardware o periféricos de entrada y/o salida, como puede ser teclados, ratones, joysticks, gamepads, monitores, impresoras, altavoces, etc.

Diseño y tipos de interfaces

Para diseñar una de estas interfaces de usuario, se necesitan tener en cuenta una serie de prácticas comunes para garantizar que sea una UI adecuada. Por ejemplo, podemos destacar eso que tan de moda está ahora, como la usabilidad, IU/UX, etc.

Para que la UI sea lo más funcional posible, se siguen las características de la siguiente lista:

- Debe ser clara. No debe haber ambigüedad que pueda llevar al usuario al error. Tiene que tener un aspecto ordenado, lenguaje claro, estructurado, etc.

- Concisa. Aunque deba ser clara, a la vez también debe ser concisa, por lo que tiene que dar la información exacta, ni más ni menos, para no generar confusión y que el usuario pueda identificar cada forma de interactuar de forma rápida.

- Familiaridad. Como habrás visto en algunas interfaces, aunque sea la primera vez que las usas, te resultan fáciles de aprender, ya que te recordarán a otras. Esto también es importante para reducir la curva de aprendizaje cada vez que se cambia de software. En definitiva, su un usuario ya tiene el hábito de usar una UI, no se debería cambiar en exceso en el futuro si se quiere seguir manteniendo al usuario seguro del entorno, sin generar dudas en él.

- Rapidez. Las interfaces de usuario tienen que ser rápidas en su respuesta, evitando que el usuario tenga que esperar demasiado tiempo o lastrando la productividad.

- Coherente. Es importante mantener una jerarquía y coherencia en la interfaz que permita al usuario estar más cómodo, y no situar las opciones en lugares extraños o hacer que se tenga que hacer de forma rara un procedimiento sencillo. Para esto, los menús ayudan mucho, posicionando cada herramienta u opción donde se espera que esté.

- Eficiente. No todas las interfaces de usuario son iguales de eficientes en cuanto al consumo de recursos de hardware, productividad, etc. Por ejemplo, una CLI suele ser mejor en cuanto a consumo de recursos de hardware que una GUI, pero una GUI tal vez permite mayor rapidez para hacer las cosas. Siempre se debe buscar un buen compromiso entre ambos aspectos.

- «Perdón». Sí, una interfaz de usuario también debe tener el don del perdón, es decir, que si el usuario comete un error, dar la posibilidad de solucionarlo en la medida de lo posible. Evidentemente no todo se puede solventar…

- Estética. Por supuesto, si es atractiva a la vista, también es agradable para el usuario.

- Simplicidad visual. Es importante que siga el principio POLA, que haga que se adapte al hecho de que los seres humanos solo pueden prestar atención de forma completa a una sola cosa a la vez.

Existe un modelo de criterios diseñado por Peter Morville de Google, y que se denomina User Experience Honeycomb en el que se dan una serie de puntos clave para crear una buena interfaz de usuario:

- Usable: ¿El diseño es fácil y simple de usar? La aplicación debe verse familiar y debe ser fácil de usar.

- Útil: ¿La aplicación satisface una necesidad? El producto o servicio tiene que ser útil en todo caso.

- Deseable: ¿El diseño de la aplicación es elegante y conciso? La estética del sistema debe ser atractiva y fácil de interpretar.

- Localizable: ¿los usuarios pueden encontrar rápidamente la información que buscan? La información debe ser localizable y fácil de navegar. Un usuario nunca debería tener que buscar.

- Accesible: ¿La aplicación admite texto ampliado sin romper el marco? Una aplicación debe ser accesible para personas con discapacidades. Un punto que muchas veces se olvida, pero que es vital, ya que de lo contrario se está excluyendo a las personas con problemas de visión o de otro tipo que accedan al uso de estas máquinas.

- Creíble: ¿La aplicación muestra datos privados o sensibles? Una aplicación debe ser transparente, segura y diseñarse con la mayor honestidad. Algo que, como sabes, no es así en la actualidad, con la cantidad de datos que se recopilan del usuario…

- Valioso: ¿El usuario final debe pensar que la interfaz es valiosa? Si se cumplen los 6 criterios, el usuario final encontrará valor y confianza en la IU.

Tipos

Es importante destacar también que existen muchas interfaces de usuario (y variantes) que se pueden diseñar atendiendo a esos criterios, y que deberías conocer antes de ver las interfaces que nos esperan en el futuro:

- Interfaz de usuario por lotes: son interfaces algo primitivas, donde el usuario no puede interactuar de forma directa, sino que genera un lote de trabajo que debe procesar la máquina y ésta lo hará.

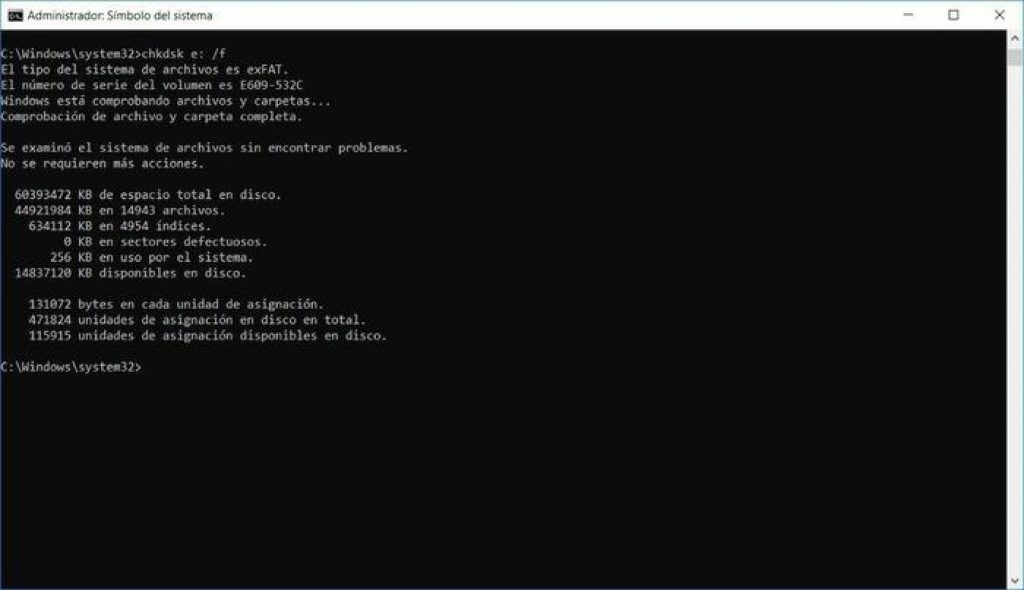

- CLI (Command Line Interface): la interfaz de línea de comandos es bastante usada en la actualidad, aunque fue la única forma de interactuar con los sistemas operativos y software de hace unas décadas, como MS-DOS, Unix, etc. En cambio, en la actualidad sigue estando muy presente especialmente en sistemas operativos tipo Unix, como Linux, aunque también en Windows con su CMD o PowerShell, ya que resultan más prácticas para realizar tareas de administración. En este tipo de interfaces se trabaja con texto, introduciendo comandos y obteniendo resultados en pantalla. Además, también se pueden generar interfaces «gráficas» basadas en texto, como la que se puede ver en Linux con la biblioteca ncurses, el BIOS, etc. No obstante, no se pueden considerar del todo una GUI, puesto que no permiten el uso del ratón, sino que se suele necesitar las flechas del teclado para navegar a través de ellas…

- Interfaz conversacional: actualmente se han puesto muy de moda con los chatbots de texto o voz en los que puedes interactuar con la máquina manteniendo una conversación como si fuese de persona a persona. Ejemplos de este tipo de interfaz lo tenías por ejemplo en Clippy de Microsoft Office, aunque es un caso bastante limitado y primitivo.

- Interfaces gestuales: son interfaces gráficas de usuario que permiten interactuar con ellas mediante gestos de las manos, o de otros dispositivos, como puede ser un lápiz óptico, una cámara que capta señales o seguimiento de movimientos, etc.

- GUI (Graphic User Interface): quizás la más popular y con la que más familiarizados estamos, ya que es un tipo de interfaz gráfica en la que se pueden usar periféricos como el teclado, el ratón, entre otros, y que tanto las interacciones y las salidas se realizan gráficamente.

- Interfaz de hardware: se trata de una interfaz completamente física, con botones, pedales, pulsadores, interruptores, y otros actuadores. Esto no se usa para los ordenadores actuales, pero sí para computadoras embebidas en máquinas industriales, por ejemplo.

- Interfaces de usuario holográficas: permiten obtener la información a partir de hologramas proyectados o recreados de alguna manera, como flotando en el aire mediante óptica, con gafas de realidad aumentada, etc. Muchas de ellas permiten interactuar de forma táctil con ellas.

- IU inteligente: se diseñan para menorar la eficiencia, eficacia y naturalidad con la que un humano puede interactuar con la máquina. Por ejemplo, pueden ser los asistentes virtuales a los que puedes pedirle con comandos de voz (esto se conoce especialmente como VUI o Voyce User Interface) o lenguaje natural gracias a la IA, y que hagan lo que necesitas, etc.

- OOUI (Object Oriented User Interface): una interfaz de usuario orientada a objetos es aquella que se basa en objetos, permitiendo que los usuarios puedan manipular estos objetos simulados o alterar sus propiedades, etc.

- Interfaz de usuario basada en permisos: se podría implementar en cualquiera de las anteriores, y simplemente mostraría u ocultaría funciones en función de los permisos o privilegios que tenga cada usuario. De este modo, se impide que personas no autorizadas puedan acceder a estas funciones o sabotear el sistema.

- TUI (Tactil User Interface): son interfaces de usuario táctiles, es decir, que usan una pantalla táctil para la interacción humano-máquina. No hay que confundirlas con el término TUI que también se puede refeerir a Text User Interface… En estas interfaces, la GUI que aparece en pantalla está mapeada por zonas, y según donde detecte el panel táctil que tocas o haces presión, ejecutará una función u otra…

- WUI (Web UI): es un tipo de interfaz basada en web, como la que puedes ver en muchos servicios en la nube, o como la pantalla de configuración del router, etc.

- Otras: también las hay tangibles, centrada en tareas, reflexivas, con retroalimentación háptica (vibraciones, Force Feedback,…), basadas en formularios, en menús, etc.

Un poco de historia

Las interfaces de usuario han pasado por varias etapas de evolución desde los inicios de la computación hasta nuestros días. Aquí te muestro algo de historia al respecto, para que compares con las que se avecinan en el futuro.

1945-1968: Batch User Interface

Entre 1945 y 1968, las interfaces de usuario por lotes eran las más populares, ya que las máquinas de esta era no permitían otra forma de interactuar con ellas. Básicamente se usaban tarjetas perforadas con las operaciones a realizar y se obtenían los resultados, en algunos casos también en tarjetas perforadas o mediante una consola limitada en pantalla o mediante luces o indicadores. También se usaron con cintas de papel como sustituto de las tarjetas perforadas.

Además, hay que señalar que estas máquinas trabajaban en tiempo real. Para que el operario de la máquina no tuviese que estar presente en todo momento, se podían usar barajas de cargas o cintas de papel perforado (cola de tareas) con todas las tareas y el operario podía desatender la máquina por un tiempo hasta que terminase los lotes de tareas (a veces, dada la potencia de estas máquinas, podía tardar horas e incluso días).

Más tarde también llegarían las cintas magnéticas, que permitían incluir estas tareas y que fueron un gran paso adelante con respecto a los métodos anteriores.

Una característica importante en este tipo de interfaces es que carecían de sistema operativo, era el software «bare-metal» el que se ejecutaba sobre la máquina, aunque con el paso de los años se comenzó a usar un precursor del sistema operativo denominado programa de monitoreo, y que siempre residía en el ordenador. Este software se encargaba de proveer información al usuario, comprobar errores, etc., unas tareas muy simples.

1969-presente: CLI

La siguiente interfaz popular fue la CLI o interfaz de línea de comandos que, pese a su antigüedad, aún no ha sido del todo sustituida, como he comentado anteriormente. En este tipo de interfaces implementadas a partir de 1969, con los primeros sistemas operativos, se permitía ejecutar tareas mediante la introducción de comandos de texto con un teclado, y se recibía la información a través de una salida estándar, que generalmente era la pantalla.

Gracias a esta nueva CLI, la solicitud y respuesta fue mucho más rápida, con menor latencia que los sistemas por lotes que necesitaban horas o días, pasando a segundos o minutos. De esta forma, el software comenzó a ser mucho más interactivo, permitiendo la interacción del usuario en todo momento. Sin embargo, suponían una carga mnemotécnica para recordar los comandos, algo que a veces resulta complicado para muchos usuarios.

Algunos de los primeros sistemas con CLI no eran tal cual los conocemos ahora, ya que usaban ordenadores combinados con teleimpresoras. Estas teleimpresoras se habían inventado inicialmente para recibir información automática en los telégrafos, pero que también resultaron útiles para estas otras aplicaciones.

Más tarde, llegarían los VDT o terminales de visualización de vídeo. Esto sería a mediados de la década de los 70. Es decir, monitores en los que se podía recibir la información de la salida, mejorando aún más la productividad de estas máquinas. Además, también permitían visualización bidireccional, puesto que también se podía ver lo que se introducía mediante comandos. Esta fue la época dorada de los sistemas como DOS, Unix, etc., y de programas basados en CLI como vi, Edit, etc.

El presente de las interfaces (GUI y TUI)

En el año 1968 empezaron a llegar las primeras piezas para hacer posibles las interfaces de usuario basadas en gráficos, es decir, las GUI. Con la mejora del procesamiento de gráficos y con la invención del ratón, los primeros sistemas operativos como macOS y Windows, comenzaron a aportar otra posibilidad a los usuarios que no se sentían cómodos con la CLI. De hecho, las primeras versiones de Windows no eran más que un MS-DOS con una GUI, hasta la llegada de Windows NT, que cambió de kernel.

Pero veamos toda la historia paso a paso:

- En 1968 llegaría un gran paso adelante para conseguir la GUI, como era ratón de Douglas Engelbart.

- En 1970, en el centro de investigación de Xerox Palo Alto, desarrollaron el paradigma conocido como WIMP, compuesto de ventanas, iconos, menús y puntero. Así se le daba aplicación al ratón. El invento de Xerox no resultó un éxito comercial debido a que la interfaz gráfica era ineficiente frente a la CLI y a la falta de software con GUI.

- Steve Jobs, en 1979, con ayuda de otros ingenieros de Apple, visitarían las instalaciones Xerox PARC. De allí sacarían inspiración para crear una GUI para su Macintosh y Lisa.

- Xerox Star, en 1981, crea el enfoque WYSIWYG, y volvió a resultar otro gran fracaso comercial en aquel momento, quizás se adelantaron demasiado a su tiempo. Además, no era demasiado veloz, podía tardar incluso minutos en guardar un archivo y necesitaba horas para recuperarse de un bloqueo.

- Un año más tarde, Rob Pike, y otros compañeros de Bell Labs, diseñarían Blit, que se lanzaría más tarde por parte de AT&T y Teletype como DMD 5620.

- En 1984 Apple con su Macintosh popularizaría la GUI, mostrando un anuncio comercial en la Super Bowl. Esto impulsó a que el MIT desarrollara X-Window System para sistemas Unix y similares, pudiendo disfrutar también de una GUI.

- En 1985, Microsoft introduce Windows 1.0, que tenía una interfaz GUI sobre MS-DOS, aunque no podía usar ventanas superpuestas, solo en mosaico.

- Con las llegadas de futuras versiones de Apple y Microsoft, se irían mejorando las funciones de la GUI, además de la manejabilidad del ratón, se posibilitó redimensionar ventanas, trabajar con ventanas superpuestas, etc. Pero no sería hasta 1987 cuando el Macintosh II introduciría la primera GUI a todo color.

Y de aquí hasta nuestros días, evolucionando los entornos de escritorio para mejorar la usabilidad, las funciones posibles, el rendimiento, los aspectos visuales, etc.

Por otro lado, como evolución de la GUI, también llegaron las primeras pantallas táctiles, y las interfaces de usuario táctiles con ellas. Esto comenzó usándose principalmente en algunos PDAs de la época, pasando luego a los dispositivos móviles, y gracias a su comodidad también ha dado el salto a otros muchos dispositivos de domótica, portátiles convertibles o 2 en 1, GPS, paneles de los vehículos, puntos de venta, etc.

Estas interfaces táctiles no son más que una GUI que se mapea y se crea un código adicional para que, según donde se pulse o el movimiento que se haga sobre la pantalla, se genere una función correspondiente a la que se muestra en esa zona con la que se ha interactuado de la GUI…

El futuro de las interfaces (tasto, gusto y olfato)

Para finalizar este artículo en el que hemos dado un profundo repaso a las interfaces de usuario y a su historia, decir que las interfaces no han terminado de evolucionar aquí. Nos esperan cosas muy interesantes para el futuro…

¿Qué más nos espera para las futuras interfaces de usuario? Pues bien, aquí te mostramos algunos de los desarrollos que están en marcha o bajo investigación y que podrían cambiar por completo la forma de interactuar con las máquinas u ordenadores:

Interfaz de usuario olfativa

Las primeras interfaces permitieron poder usar el sentido de la vista para poder ver información, y también llegaría a ellas el sentido del oído, cuando se comenzaron a introducir los sistemas sonoros para notificaciones, permitir disfrutar de un contenido multimedia más rico, etc.

Sin embargo, existen algunos investigadores investigando sobre cómo se podría agregar una experiencia aún más envolvente y real, agregando también tecnologías por las que se permitiría poder oler lo que estás viendo y escuchando.

Es el caso del proyecto AromaShooter, un dispositivo que se encarga de aportar hasta 6 esencias que se cargan en cartuchos y que se puede conectar mediante USB a tu PC. Sin embargo, esto aún necesita mucho desarrollo por delante para poder generar olores complejos e ir más allá de esas 6 esencias. Pero, ¿te imaginas que en unos años pudieras oler los videojuegos o películas que ves?

Interfaz de usuario gustativa

Por supuesto, ahora puede parecer una locura agregar el sentido del gusto a las interfaces. Sin embargo, también existen proyectos en los que se pretende traer este otro sentido a la UI del futuro. Un pequeño avance que ya ha sido implementado es Taste+, una interfaz donde el usuario puede también captar sabores de comida.

¿Cómo? ¿Con cartuchos de sabores como en el caso anterior? Pues no, en este caso es mediante otros métodos. Se trata de un dispositivo que se ajusta a la lengua y genera unas pequeñas descargas eléctricas controladas, y cambios de temperatura, que pueden generar en el usuario la sensación de diferentes sabores y sensaciones de frío o calor según el alimento. ¿No te gustaría ver tus programas de cocina favoritos y poder «probar» la comida in-situ? En el futuro será posible.

Interfaz de usuario de equilibrio

También se podrían generar o, mejor dicho, inducir sensaciones de equilibrio diferentes, para un entorno de realidad virtual más inmersivo.

Por ejemplo, teniendo la sensación de velocidad, o de que realmente te estás cayendo, etc. Esto es algo que ya se consigue en parte con algunos simuladores, pero existen proyectos que tratan de mejorar y enriquecer mucho más lo ya existente.

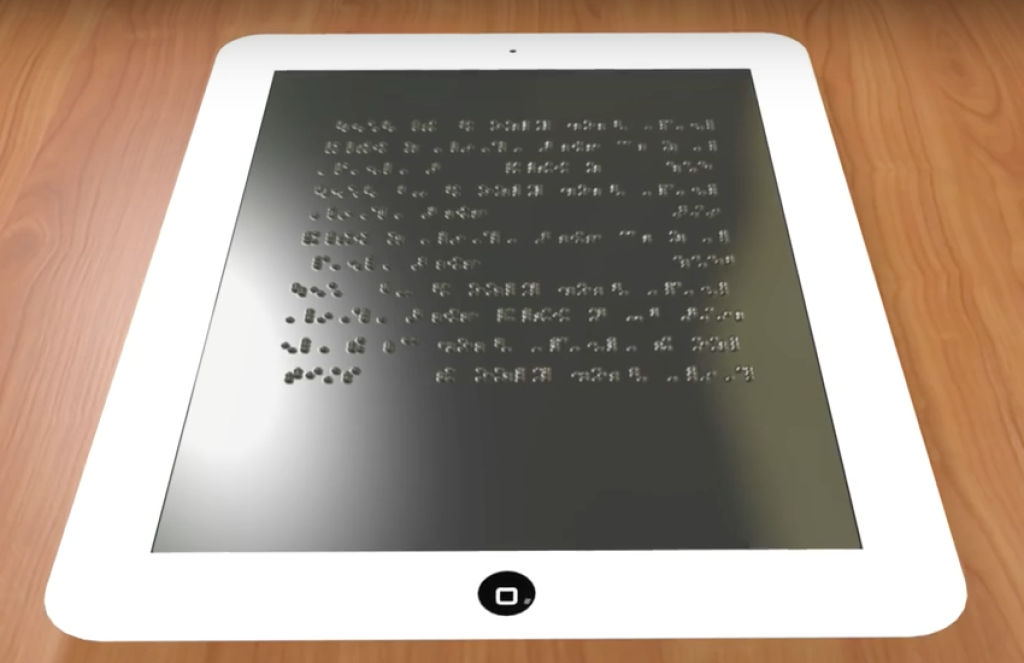

Interfaz de usuario con retroalimentación táctil

No es una UI táctil convencional, como la que podemos tener en nuestro dispositivo móvil, sino que se trata de una interfaz que también generaría una sensación táctil. Es decir, como la tecnología Force Feedback que tienen algunos volantes o mándos hápticos, pero pudiendo generar muchas más sensaciones al tacto, como suavidad, rugosidad, sensaciones térmicas, etc. Ya existe algo parecido con las pantallas Braille para ciegos, que modifican su superficie para generar textos y composiciones para que un ciego pueda recibir información.

Proyectables/hologramas

Seguramente que ya has visto este tipo de proyectos en algunos vídeos o redes sociales, donde aparecen hologramas o proyecciones que se transforman en una interfaz de usuario. Por ejemplo, como wearables como las pulseras que proyectan la interfaz del sistema en la muñeca y puedes pulsar sobre tu propia piel para poner en marcha las distintas funciones.

De esta manera, se podría convertir casi cualquier superficie en una interfaz de usuario…

Interfaz cerebro-máquina

Y, por último, quizás una de las más prometedoras y polémicas, la BCI (Brain-Computer Interface). Estas interfaces cerebro-computadora tienen muchas aplicaciones en el futuro. Por eso muchas empresas ya están experimentando con ellas, como el famoso Neuralink que tanto proclama Elon Musk, y que ya ha estado haciendo experimentos con animales para probarlo.

Este tipo de dispositivo implantado en el cerebro tiene la ventaja de no necesitar ningún sentido para manejarlo, sino simplemente pensar en algo para que se haga. Trabaja mediante unos sensores que pueden captar campos eléctricos o impulsos del cerebro y enviar estas señales al ordenador para que sean interpretadas. Es decir, se basa en tecnología electrofisiológica nerviosa o en el registro de ondas cerebrales.

Por ejemplo, ahora puedes usar Alexa para que te encienda o apague una luz, o para que te busque una serie o película favorita, o te diga el tiempo. Pero imagina que todo esto lo puedes hacer solo con pensarlo.

Historia

Estas interfaces BCI nacieron a raíz de descubrimientos muy antiguos, cuando se comenzó a entender la naturaleza eléctrica del cerebro. Por ejemplo, cuando el científico Richard Caton usó un galvanómetro para observar los pulsos eléctricos en la superficie de un cerebro vivo de animales en 1875.

Hans Berger trabajaría con Caton para registrar esta actividad eléctrica cerebral, creando así la electroencefalografía en 1924. Mediante este análisis EEG, Berger pudo clasificar las diferentes ondas cerebrales, como las Alfa que fluctúan a frecuencias entre 8-12 Hz.

Pero no sería hasta los años 70 cuando se comienza a investigar en los primeros dispositivos BCI en la Universidad de California (UCLA). El proyecto fue subvencionado por el DARPA (Defense Advanced Research Projects Agency), y la idea era usar esta tecnología para usos médicos, con implantes de prótesis neuronales para poder recuperar la audición, la vista, la movilidad, etc.

Los primeros dispositivos funcionales no llegarían hasta 1990, y a partir de ahí se han hecho grandes avances, y también se ha pensado que podrían ser productivos para la industria gaming, para uso como interfaz de usuario para la informática, e incluso ir más allá y poder tener humanos conectados a Internet, pudiendo descargar datos en nuestro cerebro, aunque para ésto último aún queda mucho, y es hoy por hoy ciencia ficción…

A parte de la complejidad y el precio de estas investigaciones y dispositivos, también hay otros obstáculos que pulir. Se han conseguido usar implantes neuronales en personas con problemas, como para manejar una mano robótica que sustituye a la amputada, para manejar ordenadores, etc. Pero el BCI aún es muy verde…

Implementación

Por otro lado, para poder usar la BCI, se pueden dar diferentes tipos de implementación:

- Implantes invasivos: necesitan cirugía para implantar el dispositivo en la corteza cerebral, lo que incluye riesgo importante. De este modo, un chip puede captar la actividad eléctrica de las neuronas de forma individual para enviarla y traducirla en acciones en un ordenador externo. El futuro sería embeber directamente el ordenador e integrarlo dentro.

- Dispositivos no invasivos: no implican tanto riesgo como los anteriores, ya que son simples sensores que se colocan en forma de casco o de electrodos sobre la cabeza para captar estas ondas o señales eléctricas. Se basan en los mismos principios del electroencefalograma, y pueden tanto captar información de neuronas individuales o de grupos localizados.

Sea cual sea le tipo de BCI, hay que implementar un sistema completo para que sea posible. Y este consta de:

- Dispositivo que capta las señales cerebrales con una serie de sensores.

- La información recibida por los sensores se enviará a un amplificador para que amplifique las débiles señales captadas.

- Lo siguiente es que estas señales amplificadas pasen por un conversor A/D.

- Una vez en formato digital, se podrán almacenar en una memoria o enviar una señal al exterior.

- Esta señal será procesada y enviada al ordenador para que pueda convertirse en comandos para interactuar con él o con otros dispositivos como pueden ser prótesis, sillas de ruedas, exoesqueletos, etc.

Aplicaciones

Y, como he mencionado anteriormente, se puede aplicar tanto el ámbito médico, para crear neuroprótesis o capacidades ampliadas, hasta para corregir otros problemas como la epilepsia, trastornos de atención, hiperactividad, permitir la comunicación en personas con parálisis cerebral, personas con esclerosis, íctus, etc.

Además, recientemente los BCI también se han propuesto para el ámbito del ocio y del gaming. Por ejemplo, para mover un avatar digital en un entorno virtual mediante las señales cerebrales, simplemente pensando qué quieres que haga, algo que puede usarse en escenarios como el Metaverso, Second Life, etc.

Incluso se podría usar también como un UI para manejar el ordenador con solo pensarlo, o interactuar con él teniendo en cuenta el estado emocional del usuario, reconociendo estados de tensión, excitación, aburrimiento, frustración, etc. Por ejemplo, ya existe un proyecto para esto denominado Emotiv EPOC. Por ejemplo, imagina que se cambia la iluminación RGB o el fondo de pantalla según tus emociones en cada momento, o que te sugiere contenido en función de cómo estés, te da recomendaciones, etc.

Conclusión

Ahora ya sabes qué puedes esperar… ¿Te imaginas poder jugar a un videojuego en el que pudieras oler el entorno que te rodea, o pedalear el sabor de la comida que ves en un vídeo… Las aplicaciones podrían ser infinitas, mejorando también la accesibilidad para personas con problemas de cualquier tipo (visión, movilidad,…).