La ciberseguridad no deja de enfrentarse a nuevos desafíos, y uno de los más recientes amenaza directamente a las GPU utilizadas en inteligencia artificial: GPUHammer. Esta vulnerabilidad de bajo nivel permite ejecutar ataques de corrupción de memoria en unidades de procesamiento gráfico, un territorio hasta ahora poco explorado por los investigadores de seguridad.

Con GPUHammer se ha demostrado por primera vez que es posible aplicar la técnica RowHammer en memorias GDDR6, afectando incluso modelos de IA sin acceso directo ni privilegios especiales. El impacto potencial abarca desde el sabotaje de modelos en la nube hasta el robo de claves en algoritmos postcuánticos. Vamos a desgranar todo lo que se sabe hasta la fecha.

¿Qué es GPUHammer y por qué se considera tan peligroso?

GPUHammer es una nueva amenaza que adapta la técnica RowHammer al contexto de las GPUs, especialmente aquellas con memoria GDDR6 como la NVIDIA A6000. Tradicionalmente, RowHammer se había limitado a explotaciones sobre memorias DDR de CPUs, donde al activar reiteradamente una fila de memoria se inducen cambios eléctricos que afectan a filas colindantes, provocando inversiones de bits.

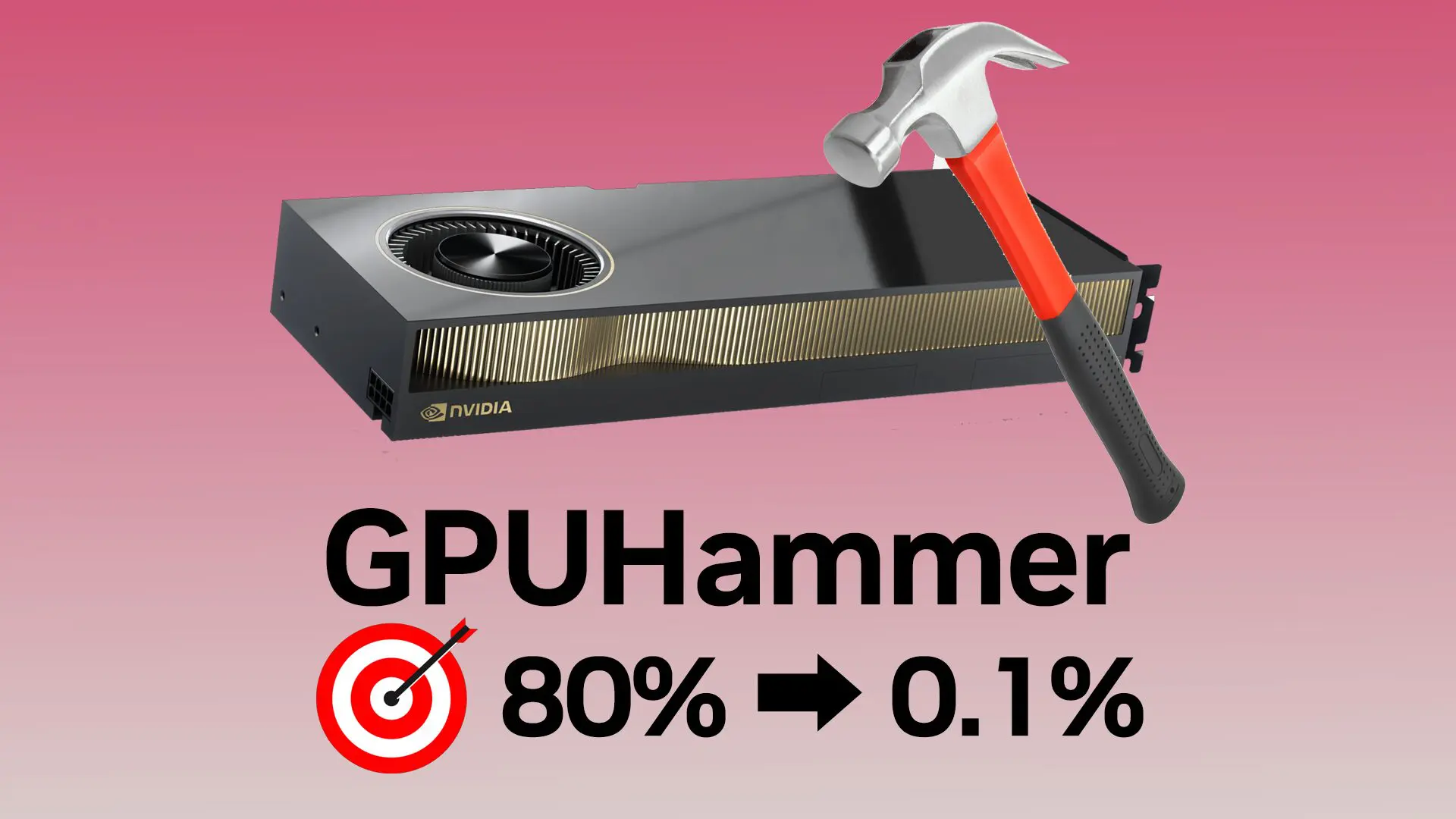

El gran hallazgo es que este mismo efecto puede replicarse en entornos gráficos, lo que abre un grave vector de ataque en infraestructuras de inteligencia artificial que dependen de estas tarjetas. En pruebas realizadas por la Universidad de Toronto, se demostró que un solo cambio de bit era suficiente para corromper un modelo entrenado sobre ImageNet y reducir su precisión del 80 % al 0,1 %.

Esta modificación silente de la memoria tiene consecuencias devastadoras en tareas críticas como el diagnóstico médico por IA, detección de fraudes financieros o conducción autónoma.

¿Cómo se ejecuta un ataque GPUHammer?

Uno de los principales retos del experimento fue desarrollar técnicas específicas para identificar qué direcciones de memoria compartían banco dentro de la GDDR6. Debido a que las GPUs no exponen directamente direcciones físicas a nivel de usuario, los investigadores invirtieron el proceso observando latencias de acceso a pares de direcciones para deducir si pertenecían a filas adyacentes.

Además, se superó el problema de la menor tasa de activación posible en GDDR6 frente a DDR4 mediante un enfoque multihilo/multiwarp, aprovechando la arquitectura paralela de las GPUs. Cada hilo ejecutaba accesos diseñados para maximizar el martilleo (hammering) sobre la misma fila, consiguiendo hasta 500.000 activaciones por ventana de refresco.

Por último, se implementó una sincronización con las órdenes de refresco TRR mediante retardo por warp, derrotando una de las principales defensas actuales en memorias modernas.

Impacto real sobre modelos de IA y redes neuronales

Una de las demostraciones más inquietantes es la capacidad de GPUHammer para sabotear directamente modelos de redes neuronales profundas (DNN). Al invertir bits críticos en pesos almacenados en formato FP16 (particularmente el bit más significativo del exponente), se logra una degradación brutal del rendimiento.

Esto fue comprobado en modelos como ResNet50, VGG16 o DenseNet161, reduciendo su precisión por debajo del 1 % con un solo bit alterado. Estos ataques son especialmente peligrosos en entornos de procesamiento compartido como servicios de IA en la nube o infraestructuras multitenant, donde múltiples usuarios comparten la misma GPU sin saberlo.

Ni siquiera es necesario acceso al software del modelo víctima: basta con manipular ubicaciones de memoria adyacentes dentro de la misma tarjeta gráfica.

¿Qué GPUs están afectadas actualmente?

Hasta la fecha, el ataque solo ha demostrado ser viable sobre GPUs NVIDIA RTX A6000 con memoria GDDR6. Otras tarjetas como la RTX 3080 no presentaron inversiones de bits, posiblemente por diferencias entre fabricantes de DRAM, materiales de encapsulado o condiciones térmicas.

Los modelos NVIDIA A100 (HBM) y las nuevas H100 o RTX 5090 (con GDDR7 y ECC en chip) tampoco resultaron vulnerables. En estos casos, las correcciones de error integradas son suficientes para contrarrestar los flips individuales producidos por GPUHammer.

Medidas de mitigación recomendadas

La defensa principal recomendada por NVIDIA y la comunidad investigadora es la activación del sistema de corrección de errores (ECC), mediante el comando nvidia-smi -e 1. Eso permite detectar y corregir de forma proactiva cualquier inversión de bit única.

Sin embargo, esta solución no es gratuita: activar ECC puede reducir el rendimiento hasta un 10 % en tareas de inferencia y restar un 6,25 % de memoria disponible. Se sugiere su uso selectivo en cargas de entrenamiento o en entornos críticos como centros de datos y nubes públicas.

Otras recomendaciones incluyen monitorizar logs del sistema en busca de errores corregidos, aislar memoria entre usuarios y verificar la integridad de los modelos mediante hashes o checksums en pipelines sensibles.

Casos avanzados: CrowHammer y ataques criptográficos

Casi al mismo tiempo que el descubrimiento de GPUHammer, se hizo pública una variante llamada CrowHammer, con implicaciones devastadoras para la criptografía postcuántica. En un trabajo conjunto entre NTT Social Informatics Laboratories y CentraleSupélec, se demostró la posibilidad de recuperar la clave privada del algoritmo FALCON (candidato a estándar por el NIST) tras varios cientos de millones de firmas y una sola inversión de bit en ubicaciones específicas.

Esto demuestra que los ataques de RowHammer no solo comprometen modelos de IA, sino también la seguridad de algoritmos diseñados para resistir incluso amenazas de computación cuántica.

Riesgos regulatorios y cumplimiento normativo

Los efectos de GPUHammer van más allá de lo puramente técnico, ya que pueden poner en jaque el cumplimiento normativo en sectores regulados. Un modelo que toma decisiones críticas con precisión distorsionada por un bit flip puede violar estándares como la ISO/IEC 27001, la Ley de IA de la Unión Europea o normativas específicas del ámbito sanitario y financiero.

En este sentido, la memoria de GPU debe considerarse parte integral de las auditorías de ciberseguridad de cualquier organización que trabaje con inteligencia artificial.

GPUHammer ha encendido todas las alarmas en el ámbito de la seguridad hardware. Lo que comenzó como una técnica académica aplicada a la DRAM de CPUs ahora se presenta como una seria amenaza para la cadena de fiabilidad de la inteligencia artificial moderna. La posibilidad de manipular modelos sin acceso directo, corromper cargas de trabajo de terceros en entornos compartidos y debilitar algoritmos criptográficos de última generación plantea un escenario donde proteger las memorias de GPU ya no es opcional, sino parte esencial de cualquier estrategia de defensa, rendimiento mediante. La activación de ECC, la segmentación de memoria entre usuarios y la vigilancia activa de registros del sistema se perfilan como armas clave frente a esta nueva generación de ataques silenciosos.