- El hardware y el software evolucionaron de la mano hasta que la arquitectura de von Neumann y los lenguajes de alto nivel permitieron su separación funcional.

- El software pasó de ser una simple extensión del hardware a convertirse en un producto independiente, sujeto a licencias, patentes y modelos de negocio propios.

- El nacimiento del software comercial y la profesionalización de su desarrollo transformaron la industria tecnológica, generando un mercado global y diferenciando roles profesionales.

La historia de la informática es mucho más que una sucesión de inventos y avances técnicos; es la evolución de conceptos, ideas y, sobre todo, de la manera en que interactuamos con la tecnología. Cuando hablamos de la diferenciación entre hardware y software y de cómo el software pasó a convertirse en un producto comercial, nos adentramos en un proceso fascinante que va desde los primeros instrumentos de cálculo hasta las plataformas digitales de hoy.

En este artículo vamos a desentrañar cómo surgió esa separación clave entre hardware y software, qué hitos marcaron el cambio y cuándo comenzamos a ver el software como un producto aparte, comercial y fundamental para la industria tecnológica. Prepárate para un viaje desde el ábaco hasta los microprocesadores, pasando por guerras empresariales, innovaciones disruptivas y genialidades de grandes figuras de la informática.

De los inicios de la computación a la distinción entre hardware y software

Durante miles de años, la humanidad ha intentado automatizar cálculos mediante instrumentos físicos, desde las primeras balanzas hasta el ábaco babilónico y egipcio. Estos dispositivos, junto con máquinas como el mecanismo de Anticitera o los ecuatorios árabes, sentaron las bases mecánicas de la computación, sin una distinción clara aún entre lo físico (hardware) y las instrucciones (lo que en un futuro sería el software).

En la Edad Media y la Antigüedad, el hardware se identificaba con el propio dispositivo: mecánico, analógico, gigante y tangible. Todo el “programa” residía en cómo estaba construido el aparato o en la manipulación física de piezas: ejemplo de ello son las tarjetas perforadas usadas en telares como el de Jacquard en 1801. Era un mundo sin software tal y como lo entendemos ahora, donde la lógica del funcionamiento dependía directamente de la configuración física de la máquina. Conoce la historia de la evolución del hardware.

El nacimiento de la noción de programa y las primeras diferencias

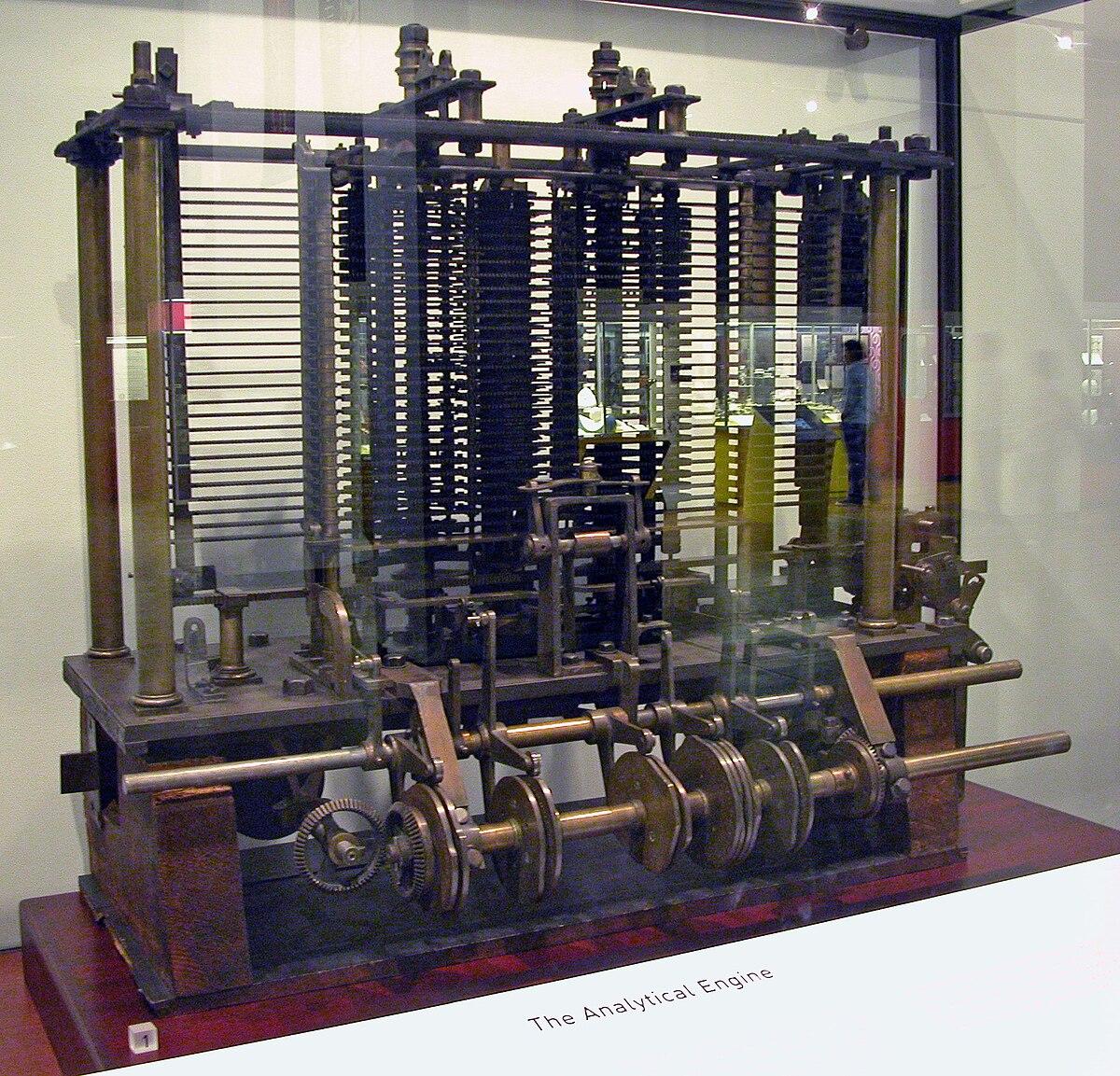

La idea de separar instrucciones de la máquina arranca tímidamente con genios como Charles Babbage y Ada Lovelace. Babbage diseñó, aunque nunca terminó físicamente, la máquina analítica (1833-1835), que por primera vez conceptualizaba un dispositivo capaz de ser programado por tarjetas perforadas, exactamente igual a un telar Jacquard. Ada Lovelace describió cómo esas tarjetas podían contener distintos «programas», plantando la semilla de la diferenciación futura entre hardware e instrucciones.

Sin embargo, aún el hardware estaba íntimamente ligado al proceso lógico: el dispositivo era tanto la máquina como el «código» que se ejecutaba.

Revolución electrónica y formalización de los conceptos

El salto cualitativo llega en la primera mitad del siglo XX. Las máquinas electromecánicas como la Mark I, el ABC o el ENIAC permitieron por fin que las instrucciones no dependieran únicamente de la configuración física. Aquí entra Alan Turing, cuya Máquina Universal (1936) define, de forma teórica, una máquina que puede ejecutar cualquier conjunto de instrucciones (algoritmos) almacenado de algún modo externo a la propia máquina.

La verdadera revolución llegó con la arquitectura de von Neumann: programas y datos se almacenan en la misma memoria, y la máquina puede cambiar el código a ejecutar sin alterar su estructura física. Eso es lo que diferencia definitivamente hardware y software:

– Hardware: la parte física, el mecanismo, la electrónica.

– Software: los algoritmos, instrucciones y datos cargados en la memoria para ser ejecutados por la máquina física. .

Ya en los años 40 y 50, con la llegada de los lenguajes ensamblador y, poco después, los de alto nivel como FORTRAN o COBOL, se hace obvia la diferencia: cualquier persona con conocimientos podía escribir un programa (software) que luego funcionara sobre distintos modelos de hardware compatible.

El nacimiento del software como producto independiente

Durante los años 50 y principios de los 60, los fabricantes de ordenadores (por ejemplo, IBM) vendían la máquina junto a los programas necesarios, como un «todo en uno». No existía una industria del software como tal: el software era un adorno del hardware o, en el mejor de los casos, un complemento necesario para que el aparato funcionase.

La situación cambia radicalmente con la llegada de los mainframes IBM System/360 y la aparición de una comunidad creciente de programadores. Es entonces cuando resulta evidente que el software puede, y debe, evolucionar independientemente del hardware.

Uno de los primeros grandes movimientos fue el nacimiento de empresas dedicadas exclusivamente al desarrollo de software, como Informatics General Corporation, y la creación de organizaciones SHARE para compartir programas entre diferentes sistemas. Además, IBM y otros fabricantes empiezan a cobrar por separado el software y el hardware, impulsando la profesionalización del sector y el surgimiento del software como un producto con entidad propia.

Origen y consolidación del término «software»

El propio término “software” aparece en los años 50, popularizado por John Tukey y otros matemáticos e ingenieros, y pronto se convierte en el concepto opuesto a “hardware”. El software pasa a englobar todo aquello que es intangible: desde sistemas operativos hasta aplicaciones, utilidades, compiladores y demás programas necesarios para usar un ordenador moderno. Conoce el avance en chips y hardware.

En paralelo, la noción de “ingeniería del software” nace gracias a figuras como Margaret Hamilton, que trabajaban en sistemas críticos de la NASA durante los años 60, buscando distinguir la disciplina del desarrollo de programas de la propia construcción física de los ordenadores. El sector reconoció la necesidad de metodologías, estándares y buenas prácticas aplicadas al software, marcando así el inicio de una nueva rama profesional.

De herramienta a producto: el software entra en el mercado

Durante los 70 y 80, el software terminó de independizarse y se consolida como un producto listo para ser adquirido, instalado y utilizado en diferentes máquinas. La llegada de sistemas operativos como UNIX (cuya filosofía ya preveía la portabilidad del software entre máquinas diferentes) y el ascenso de los microordenadores aceleran esta tendencia.

En 1980, IBM lanzó el primer PC, cuya arquitectura abierta permitió que terceras empresas desarrollaran software comercialmente, portando aplicaciones, sistemas operativos y utilidades. Microsoft, por ejemplo, floreció como una compañía que sólo vendía software (MS-DOS, luego Windows), no hardware. Así, el software se transformó en un bien comercializable, sujeto a licencias, patentes, derechos de autor y modelos de negocio.

Además, se produjo una diferenciación radical entre:

- Sistemas operativos (el software que permite utilizar el hardware y ejecutar aplicaciones)

- Programas y aplicaciones (software de propósito general o específico, desde procesadores de texto hasta videojuegos)

- Firmware (programas «intermedios» grabados en chips para controlar el hardware)

La guerra de los sistemas y el auge del software personalizado

Durante los 80 y 90, el sector vivió auténticas guerras de estándares, principalmente alrededor de los sistemas UNIX y sus variantes, el nacimiento y auge de Windows, y la competencia incipiente por el dominio de los sistemas operativos en servidores, ordenadores personales y, más adelante, dispositivos móviles.

Se originó así la cultura de las licencias propietarias frente al software libre, impulsada por personajes como Richard Stallman y el proyecto GNU, o el fenómeno Linux iniciado por Linus Torvalds en 1991. Por primera vez, los usuarios podían elegir no solo el hardware sino también el sistema operativo, y personalizar completamente la experiencia con programas desarrollados por terceras partes.

El software pasó a tener ciclos de vida propios, modelos de actualización, soporte técnico independiente y un valor económico muchas veces superior al de la máquina física donde se ejecutaba.

La profesionalización y madurez de la ingeniería del software

La diferenciación entre hardware y software ya era total en los años 90 y 2000: la industria del software se profesionalizó a todos los niveles. Aparecieron estándares, metodologías de desarrollo como cascada, espiral o ágil, y surgió el concepto de gestión del ciclo de vida del software, desde la concepción y análisis hasta el despliegue, mantenimiento y final de vida.

Durante esta época, empresas de software puro comenzaron a tener más valor en bolsa que los propios fabricantes de hardware. La modularidad de los programas, la aparición de APIs y frameworks, y el auge de los sistemas distribuidos y en red (como Internet) terminaron por consolidar el software como el epicentro de la revolución digital.

Hardware y software en la actualidad: sinergia y nuevas fronteras

Hoy, cualquier dispositivo electrónico depende de una colaboración íntima entre hardware y software. Sin embargo, los procesos de fabricación, venta y desarrollo de ambos son radicalmente distintos. El software ya no solo se vende, sino que se ofrece como servicio (SaaS), se distribuye libremente o se monetiza mediante publicidad, suscripción o micropagos.

Además, la expansión de tecnologías como el big data, la inteligencia artificial o la computación cuántica vuelve a poner sobre la mesa nuevos retos: cómo gestionar y desarrollar software capaz de adaptarse a entornos cambiantes, o cómo proteger los derechos de propiedad intelectual en un mercado cada vez más global y competitivo.

En la actualidad, la distinción entre hardware y software sigue siendo fundamental para entender la innovación y las oportunidades de negocio. Desde las primeras máquinas de cálculo hasta los servicios en la nube, la carrera de la tecnología continúa siendo la historia de cómo las ideas se materializan en código y luego en aplicaciones que revolucionan el día a día.