- La DPU descarga red, seguridad y almacenamiento, liberando CPU/GPU y reduciendo latencia en HPC y cloud.

- BlueField-3 integra Arm, aceleradores y NIC 400G, operando como nodo independiente con DOCA.

- Frente a ConnectX-7, la DPU aporta programabilidad, aislamiento y offloads avanzados; la NIC prima la conectividad.

- Casos reales (Nitro, IPU, CIPU) demuestran mejoras en rendimiento, eficiencia y seguridad multiinquilino.

En los centros de datos modernos, donde cada ciclo de CPU cuenta y la energía se mide al detalle, las DPU han pasado de ser una curiosidad a un componente estratégico. Su misión es descargar y acelerar funciones de red, seguridad y almacenamiento, liberando a la CPU para lo que realmente importa: la computación de propósito general y las aplicaciones críticas.

Este cambio se nota especialmente en HCI y HPC, donde suben la densidad de cómputo y las exigencias de latencia, y cada vatio cuesta. La DPU actúa como coprocesador de la infraestructura, resolviendo cuellos de botella que aparecen cuando la CPU tiene que ocuparse de tareas de control, virtualización o E/S intensiva, algo que se agrava al escalar usuarios, cargas y ancho de banda.

Qué es una DPU y por qué importa en HPC

Una unidad de procesamiento de datos es un procesador programable, habitualmente un SoC, que combina tres pilares: CPU multinúcleo (a menudo Arm), interfaz de red de alto rendimiento y motores de aceleración de hardware para funciones de red, seguridad, almacenamiento y analítica. No sustituye a la CPU ni a la GPU; las complementa descargando trabajo de infraestructura y moviendo datos a máxima velocidad y con mínima latencia.

En HPC, cloud y centros de datos empresariales, esta separación de responsabilidades es clave. La DPU asume planos de datos y control de la infraestructura (virtualización, SDN, cifrado, compresión, NVMe-oF, observabilidad, etc.), mientras la CPU se centra en la lógica de las aplicaciones y la GPU en la computación paralela. El resultado es menos contención, menos interrupciones y mejor rendimiento por núcleo.

Métricas y presión sobre la CPU en HCI/HPC

El éxito en entornos HPC se ha medido tradicionalmente por indicadores prácticos que hoy migran al data center tradicional. Recuento de núcleos disponibles por rack o por nodo, FLOPS, consumo energético (kW medio y pico) y huella física son métricas que ya no se quedan en el supercomputador: ahora condicionan el diseño del CPD empresarial.

Cuando la CPU gestiona red, seguridad y almacenamiento además de las cargas de negocio, el panorama se complica. Más densidad y más usuarios aumentan las tareas no específicas de la aplicación (conmutación, cifrado, verificación, compresión, gestión de colas), restando ciclos a lo verdaderamente crítico. Aquí la DPU alivia el cuello de botella y permite elegir: o mayor rendimiento por núcleo, o particionar y servir a más usuarios con la misma infraestructura.

Componentes y capacidades clave de una DPU

En su interior, una DPU moderna integra piezas muy concretas para mover y procesar datos sin fricción. CPU Arm multinúcleo, memoria integrada, NIC de alto ancho de banda y aceleradores dedicados para offloads como cifrado/descifrado, compresión, checksum, procesamiento de paquetes, virtualización de almacenamiento, introspección de flujos y más.

Su red de alta velocidad no es una mera tubería; es capaz de inspeccionar, transformar y enrutar a línea de cable. Con capacidades de SmartNIC, la DPU puede descargar TCP/IP, RDMA (RoCE), virtualización de red y filtros avanzados, evitando que estos caminos pasen por la CPU del host. Esto reduce latencias y hace predecible el rendimiento bajo picos.

En seguridad, el enfoque basado en hardware marca la diferencia. Aislamiento por hardware, cifrado en línea, TLS/IPsec, firewall distribuido, IDS/IPS y modelos zero trust pueden residir en la DPU, minimizando la superficie de ataque del host y protegiendo entornos multiinquilino, algo que HPC y cloud nativos demandan por necesidad.

En almacenamiento de alto ancho de banda, la DPU empuja la frontera de la eficiencia. Con NVMe over Fabrics, descompresión y offloads de checksum, el plano de datos deja de interrumpir a la CPU. Tecnologías como BlueField SNAP para emulación NVMe y VIRTIO-FS para descargas de sistemas de archivos llevan el procesamiento al sitio correcto: a la DPU, no al host.

DPU, SmartNIC y NIC: diferencias y evolución

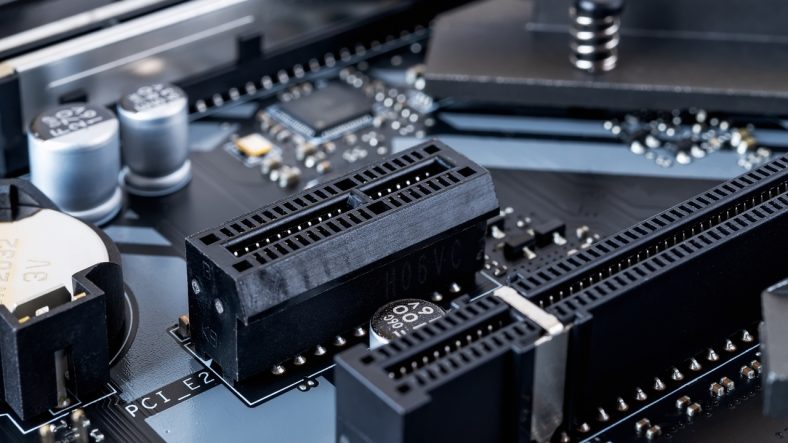

Para poner orden, conviene distinguir etapas. Las NIC tradicionales mueven paquetes con funciones básicas (MAC, CRC, offloads como TSO/LSO, VLAN, SR-IOV) y se apoyan casi por completo en la CPU del host, que puede usar DPDK o pasar VFs a máquinas virtuales.

Las SmartNIC de primera hornada dieron el siguiente salto: descargaron fastpaths de OVS/vRouter, RDMA (RoCE v1/v2), NVMe-oF y seguridad IPsec/TLS, pero seguían sin CPU de propósito general sólida, delegando el plano de control en el host.

La DPU basada en FPGA añadió programabilidad de datos y control con una CPU general a bordo. Su combinación FPGA+CPU ofreció agilidad para iterar y personalizar, pero el salto a 100G colocó límites de área y consumo que complicaron escalar.

Finalmente, la DPU SoC de un solo chip es la forma madura: aceleradores dedicados + CPU de propósito general en un ASIC eficiente. Equilibra rendimiento con consumo, habilita gestión y orquestación unificadas y soporta escenarios de nube a escala sin las penalizaciones de área/energía de FPGA.

CPU, GPU y DPU: qué hace cada una

La CPU sigue siendo el cerebro de propósito general: pocos núcleos muy capaces, baja latencia y excelente rendimiento en serie. Es la que ejecuta sistemas y aplicaciones, orquesta hilos y gestiona memoria y E/S.

La GPU nació para gráficos, pero su arquitectura manycore la hizo perfecta para cómputo masivo en paralelo, IA y analítica de alto volumen. Miles de hilos concurrentes y throughput asombroso, aunque no diseñada para control fino del sistema.

La DPU es el tercer pilar. Multinúcleo, aceleradores y NIC de línea para que los datos vayan al lugar y formato correctos, a la máxima velocidad. Descarga redes, seguridad y almacenamiento, y hace que CPU y GPU no se queden esperando datos.

BlueField y DOCA: aceleración integral de red, seguridad y almacenamiento

NVIDIA ha consolidado el término DPU con BlueField. Desde BlueField-2, y muy especialmente BlueField-3, la propuesta es clara: hacer programable la infraestructura con DOCA, un SDK que expone aceleradores para redes, almacenamiento y seguridad, y que además se integra con CUDA y el catálogo NGC para flujos de desarrollo coherentes.

BlueField y DOCA materializan descargas concretas: checksum, descompresión, emulación NVMe con BlueField SNAP, VIRTIO-FS, SDN acelerada para tráfico este-oeste y norte-sur, NVMe-oF, RoCE, corrección de errores y compresión en vuelo. Eso acelera el plano de datos y acorta caminos críticos.

Incluso el control del servidor cambia de manos cuando conviene. La DPU puede tomar el mando del host para tareas de gestión como reinicios remotos, arranque seguro o cumplimiento de políticas, reduciendo intervención manual y endureciendo la postura de seguridad.

BlueField-3 vs ConnectX-7 y SuperNIC: ámbitos y casos de uso

En servidores H100 SXM no es raro ver dos BFD-3 junto a varias CX-7 400G, y surgen preguntas. BlueField-3 es una DPU completa que opera como nodo independiente en la ruta PCIe, mientras que ConnectX-7 es una NIC de altísimo rendimiento y baja latencia enfocada a conectividad y offloads clásicos.

BlueField-3 integra 16 núcleos Arm A78, conectividad Ethernet 400 Gb/s o NDR InfiniBand y aceleradores de hardware para SDN, NVMe-oF, seguridad y gestión. Funciona con su propio sistema operativo, aísla cargas y descarga virtualización y control. Puede incluso acelerar colectivas MPI en HPC/IA, con mejoras reportadas del entorno del 20% en supercomputación a gran escala (DGX SuperPOD).

ConnectX-7, en formatos OSFP y QSFP112, aporta puertos de 400 Gb/s (o 2 x 200 Gb/s) con RDMA de bajísima latencia y throughput sostenido. Es ideal cuando el objetivo es una conectividad sencilla y fulminante, sin la complejidad de un plano de cómputo programable en la tarjeta.

¿Y las SuperNIC? Enfocadas a IA a hiperescala, optimizan transferencia GPU a GPU a 400 Gb/s sobre RoCE con menor tamaño y consumo. Comparten base tecnológica con BlueField-3, pero su prioridad es la interconexión de aceleradores a mínima latencia, no la descarga general de la infraestructura del host.

Arquitectura de BlueField-3: nodo propio, BMC y switch PCIe

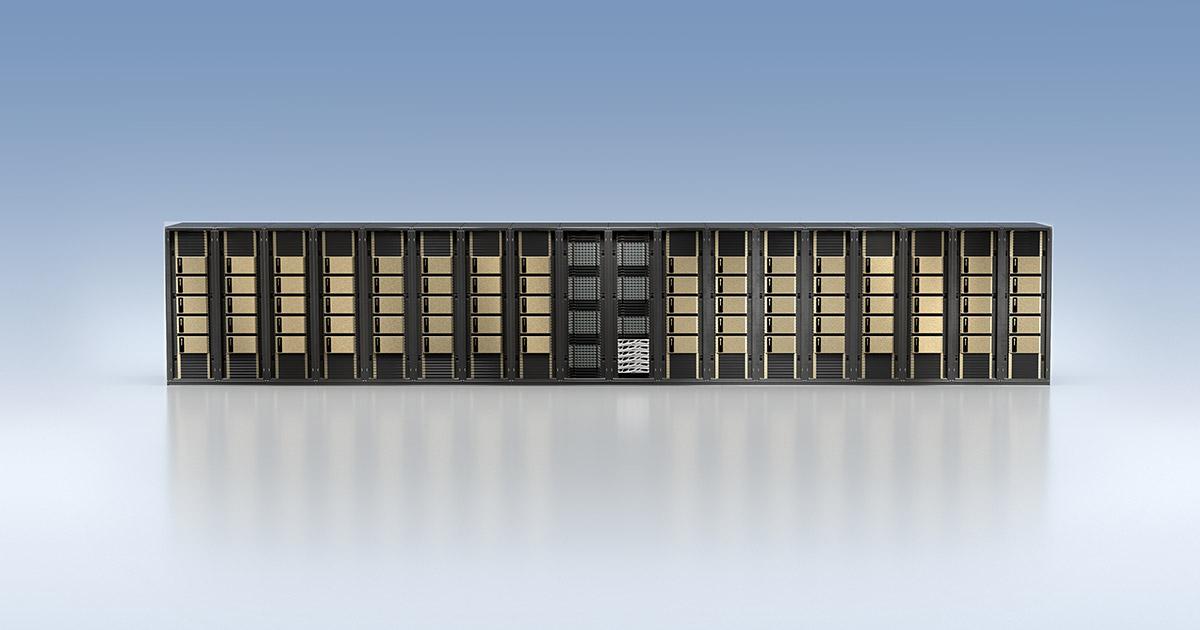

BlueField-3 no es solo una NIC vitaminada; es un nodo con Arm+SO, aceleradores, switch PCIe integrado y BMC. El BMC aporta gestión independiente del host, útil en nubes a gran escala para inventario, telemetría y operaciones seguras fuera de banda, incluso cuando el servidor principal no responde.

Esa capacidad permite, por ejemplo, gestionar gabinetes de expansión SSD NVMe a través del switch PCIe de la DPU, o aplicar microsegmentación y políticas zero trust sin tocar la CPU del host. La independencia operativa es un valor diferencial frente a NICs tradicionales.

Seguridad, aislamiento y zero trust de alto rendimiento

La seguridad es una de las razones de ser de la DPU. Al ejecutar cortafuegos distribuidos, TLS/IPsec, IDS/IPS y políticas cero trust en la propia tarjeta, se reduce drásticamente la presión sobre el host y se consigue inspección a escala sin perjudicar las aplicaciones.

Para Kubernetes y plataformas nativas de la nube, la sinergia con soluciones como BIG-IP Next de F5 sobre BlueField-3 habilita protección de API, mitigación DDoS y segmentación en el propio plano de datos. En HPC multiinquilino, la combinación con switching NVIDIA Quantum InfiniBand facilita aislamiento entre nodos con rendimiento casi sin sobrecarga de SO.

Rendimiento, eficiencia y observabilidad

La descarga integral produce efectos medibles: reducción del uso de CPU del host (p. ej., con OVS y NVMe-oF), menor latencia y mayor ancho de banda efectivo. En almacenamiento distribuido, mover la lógica a la DPU puede duplicar IOPS frente a soluciones 100% software, al eliminar contenciones y copias.

La observabilidad también mejora al tener telemetría de flujos y paquetes a nivel de la DPU, topologías y analítica en línea. Planificar capacidad, detectar anomalías y cumplir normativas resulta más sencillo sin desplegar dispositivos externos adicionales.

Costes, energía y escalabilidad operativa

Más allá del rendimiento, hay impacto en la cuenta de resultados. La DPU reduce la necesidad de más CPU para infraestructura y baja el consumo energético total, favoreciendo centros de datos sostenibles. Algunas estimaciones sitúan ahorros energéticos relevantes al consolidar servidores y reducir refrigeración gracias a la descarga.

Al separar infraestructura de aplicaciones, escalar es menos traumático. Asignar recursos, aislar inquilinos y adaptar el sistema a cargas fluctuantes se simplifica, porque la DPU aporta granularidad y control fino en el borde del servidor.

Casos reales y ecosistema: AWS Nitro, Intel IPU, Alibaba CIPU y Volcano Engine

Los grandes actores ya han demostrado el modelo. AWS Nitro reorganiza la pila cloud al trasladar red, almacenamiento, seguridad y monitorización a hardware y software dedicados, dejando la CPU para las instancias de cliente casi sin sobrecarga. Nitro combina tarjetas específicas, un chip de seguridad y un hipervisor ultraligero.

Intel denomina IPU a su propuesta, con versiones FPGA y ASIC (Oak Springs Canyon, Mount Evans). Conexiones Ethernet rápidas, aceleradores y núcleos programables permiten descargar infraestructura y actuar como punto de control seguro del host. Mount Evans integra 16 núcleos Arm Neoverse N1 y un pipeline ASIC de paquetes muy eficiente.

Alibaba Cloud, con CIPU basada en Shenlong, ha ido endureciendo reenvío de red y almacenamiento en hardware, hasta alcanzar descarga total con soporte RDMA y aislamiento físico cuando es necesario. Volcano Engine también equipa DPU propias en sus instancias EBM/ECS de última generación para elevar E/S de red y almacenamiento.

Almacenamiento computacional y arquitectura abierta de nueva generación

El almacenamiento deja de ser un simple backend. La arquitectura abierta de nueva generación acelera, aísla y protege el subsistema de storage con co-diseño hardware/software, haciendo que la DPU sea eficiente y transparente para el usuario final.

Servicios en la DPU como checksum offload, descompresión, SNAP para emulación NVMe y VIRTIO-FS reducen las copias y los pasos por la CPU, suavizan colas y mejoran el rendimiento sostenido. Esto es crítico cuando el almacenamiento crece de forma exponencial, como ocurre en HPC y lagos de datos.

BlueField-2, BlueField-2X y la expansión del ecosistema

BlueField-2 abrió camino y BlueField-2X incorporó una GPU Ampere, alineando la hoja de ruta con la aceleración de IA y aprendizaje automático en el propio plano de datos. La compra de Mellanox potenció la posición de NVIDIA en redes de alto rendimiento, seguridad y almacenamiento, integrando DOCA con CUDA y NGC en un ecosistema común.

Este encaje ha sido clave para la evolución de los data centers desde la virtualización (años 2000) a la nube y, ahora, a la computación definida por software y acelerada por hardware. La DPU no compite con x86; distribuye el trabajo donde mejor se ejecuta.

Gestión del servidor desde la DPU: control y automatización

Más allá del dataplane, hay un plano de gestión cada vez más automatizado. Con el BMC integrado y su propio SO, la DPU puede orquestar operaciones del host como reinicios seguros, enforcement de políticas, inventario y updates coordinados, todo sin saturar la CPU principal.

Ese enfoque reduce intervención manual y errores, y facilita despliegues masivos. En nubes privadas y entornos perimetrales, disponer de un punto de control independiente acelera el MTTR y mejora la postura de ciberseguridad.