- JUPITER supera la exaescala con 24.000 GH200 y red InfiniBand Quantum‑2, liderando la eficiencia con el módulo JEDI.

- Arquitectura modular: Booster para IA y cómputo paralelo, Cluster con SiPearl Rhea1 para cargas generales de alta memoria.

- Aplicaciones clave: clima (ECMWF y Destination Earth), IA europea (TrustLLM), neurociencia, cuántica y física de partículas.

- Eficiencia y sostenibilidad: refrigeración líquida BullSequana XH3000, energía renovable y reutilización del calor residual.

Europa ha puesto en marcha una máquina de cálculo que, sin exagerar, cambia el tablero tecnológico del continente: JUPITER. Este superordenador exaescala, operado en el Forschungszentrum Jülich (Alemania), supera el umbral del exaflop y sitúa a la Unión Europea en la liga máxima junto a Estados Unidos y China. En pocas palabras, es la herramienta que necesitaban la ciencia europea, la industria y la inteligencia artificial para dar un salto cualitativo. Su potencia, eficiencia y arquitectura modular lo convierten en un proyecto estratégico de primer orden.

Más allá del número bruto de operaciones por segundo, JUPITER nace con una misión clara: acelerar descubrimientos, cimentar la soberanía tecnológica y servir como plataforma para modelos de IA de nueva generación y simulaciones científicas de altísima resolución. Con un coste de proyecto de 500 millones de euros y un consorcio franco-alemán a los mandos (Eviden y ParTec), el sistema está llamado a marcar época.

Qué es JUPITER y por qué la exaescala importa

JUPITER es el primer superordenador europeo que cruza la barrera de la exaescala: hablamos de 1 x 10^18 operaciones de punto flotante por segundo. Dicho de otra forma, un quintillón de operaciones por segundo en un único sistema. Esta cifra, que cuesta imaginar, abre la puerta a entrenar grandes modelos de IA generativa, ejecutar simulaciones climáticas globales a resolución sin precedentes o levantar gemelos digitales de órganos humanos con fines médicos.

La iniciativa EuroHPC ha encuadrado JUPITER dentro de un ecosistema que ya incluye máquinas como MareNostrum (España), LEONARDO (Italia), LUMI (Finlandia), Discoverer (Bulgaria), MeluXina (Luxemburgo), Vega (Eslovenia), Karolina (Chequia) y Deucalion (Portugal). Juntos, estos recursos consolidan a Europa como potencia de supercomputación a escala mundial.

Durante su inauguración oficial en Jülich, con presencia de autoridades y líderes del sector, se subrayó el carácter pionero del proyecto y su impacto directo en IA, simulaciones científicas y competitividad industrial. La UE recalca además el compromiso con energía 100% renovable para su operación y una arquitectura con liderazgo en eficiencia (Green500).

Quién lo construye y cómo se ha financiado

El suministro e integración de JUPITER corre a cargo de un consorcio formado por Eviden (Grupo Atos) y ParTec, en el marco de EuroHPC JU. La operación y el día a día técnico se llevan desde el Centro de Supercomputación de Jülich, un polo europeo de investigación con largo historial en HPC. La inversión total del proyecto asciende a 500 millones de euros, con apoyo del Gobierno alemán y de la Unión Europea.

Los responsables del consorcio y de los principales socios tecnológicos han remarcado el objetivo de fortalecer la autonomía tecnológica del continente. Desde Eviden se destaca el papel de la familia BullSequana XH3000 en refrigeración líquida y escalabilidad, mientras que ParTec pone el foco en su arquitectura modular dinámica (dMSA). NVIDIA aporta su pila de computación acelerada y SiPearl su procesador Rhea1 para el módulo de cómputo general.

Las declaraciones institucionales convergen en una idea: construir una máquina «hecha en Europa», con piezas clave del ecosistema europeo y alianzas estratégicas, capaz de impulsar ciencia y economía por igual. La ambición no se limita a rendir al máximo; pretende también reducir huella de carbono y cimentar soberanía industrial.

Arquitectura modular: Booster y Cluster

JUPITER se estructura en dos grandes particiones: un Booster Module acelerado por GPU y un Cluster Module de propósito general con procesadores de alta memoria. Esta división permite adaptar la carga de trabajo a la mejor unidad de cómputo posible. El Booster se encargará de IA y cálculos masivamente paralelos, mientras que el Cluster ofrecerá versatilidad y ancho de memoria para aplicaciones generales.

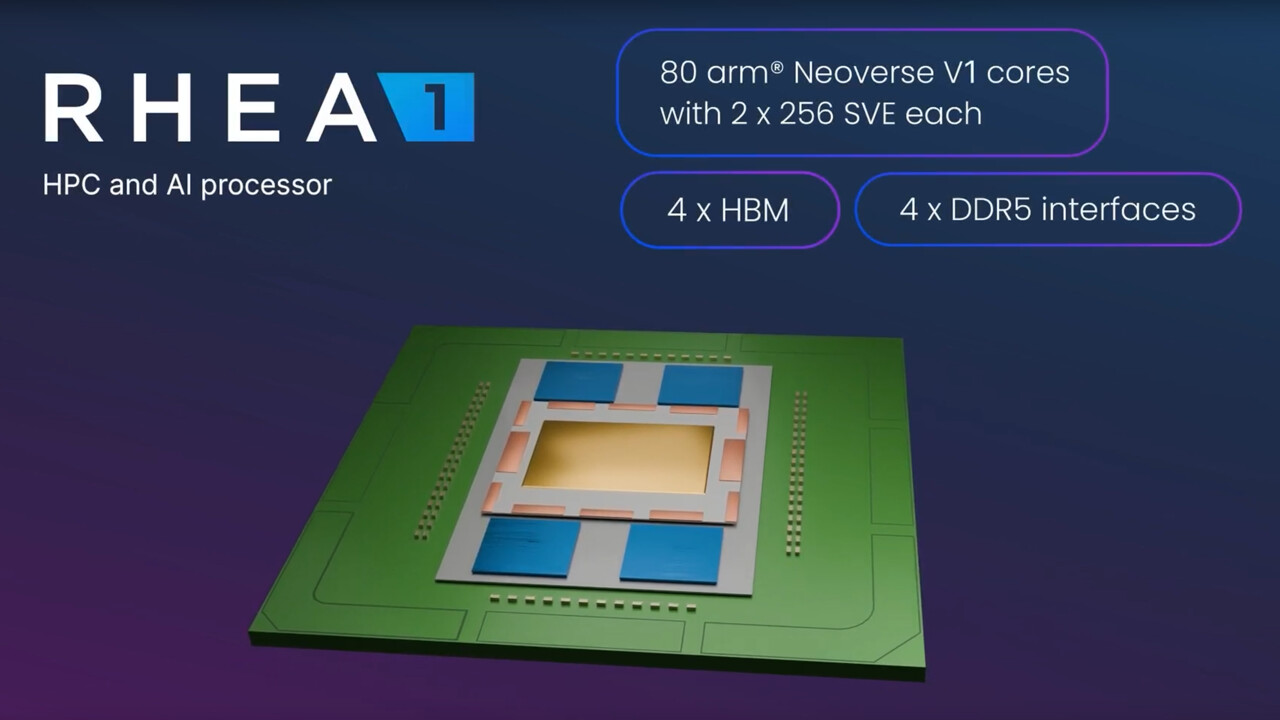

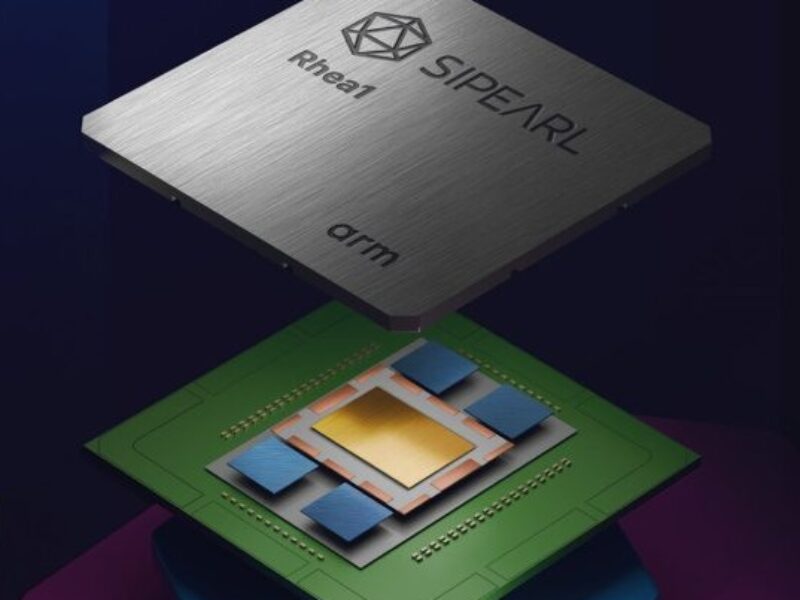

El Booster utilizará la última tecnología de centro de datos de NVIDIA y se basa en superchips GH200 Grace Hopper, que combinan CPU y GPU en un mismo módulo para maximizar el rendimiento y reducir cuellos de botella. El Cluster, por su parte, se apoyará en los procesadores europeos SiPearl Rhea1, diseñados específicamente para HPC.

Esta arquitectura modular dinámica (dMSA), desarrollada con liderazgo de Jülich y ParTec, permite configurar «a la carta» los recursos del sistema para optimizar eficiencia y velocidad según la naturaleza del algoritmo. El resultado es un sistema flexible que no sacrifica potencia en escenarios de IA, simulación numérica o análisis de datos a gran escala.

Hardware clave y red de interconexión

El corazón del Booster lo forman aproximadamente 24.000 superchips NVIDIA GH200 Grace Hopper, interconectados con tecnología InfiniBand NVIDIA Quantum‑2, diseñada para latencia ultrabaja y altísima escalabilidad. Esta combinación CPU+GPU en el mismo superchip reduce tiempos de paso de datos y acelera enormemente cargas de IA y HPC.

En el plano de red, la infraestructura se apoya en Quantum‑2 InfiniBand como columna vertebral, y en algunas comunicaciones se menciona la familia Spectrum X de NVIDIA como parte del ecosistema de interconexión orientado a alto rendimiento y baja latencia. El objetivo es sostener decenas de miles de enlaces de red (en el orden de 51.000) sin estrangular el rendimiento global.

Para el almacenamiento, la capacidad proyectada se acerca al exabyte, algo crítico cuando se entrenan modelos multimodales o se gestionan simulaciones climáticas globales con mallas de altísima resolución. El sistema en su conjunto puede mover más de 2.000 terabytes por segundo, apoyado por más de 260 km de cableado.

La infraestructura física se despliega con una instalación modular que ronda los 50 contenedores especializados, ocupando aproximadamente el espacio de cuatro pistas de tenis. Este enfoque facilita ampliaciones futuras y simplifica el despliegue por etapas a lo largo del segundo semestre de su instalación.

Rendimiento y eficiencia: exaflop sostenido y liderazgo en Green500

En precisión de doble (HPC) y simple precisión, JUPITER se sitúa en la liga exaescala, abriendo la puerta a simulaciones y entrenamientos de modelos que antes eran impracticables. Para cargas de 8 bits típicas en IA, la potencia de cálculo prevista supera con creces los 70 exaflops, con estimaciones que apuntan hasta 90 exaflops en escenarios de IA.

La eficiencia energética es una obsesión del proyecto. El módulo JEDI (JUPITER Exascale Development Instrument), primer bloque de desarrollo instalado, alcanzó el primer puesto de la lista Green500 como sistema más eficiente del mundo. Se midieron 72.000 millones de operaciones de coma flotante por segundo y vatio (72 GFLOPS/W), batiendo al líder anterior.

En las mediciones para Green500, JEDI registró 4,5 petaflops sostenidos con un consumo medio de 66 kW, que pudo optimizarse hasta 52 kW. Lo notable es que JEDI emplea el mismo hardware que el Booster definitivo: GH200 Grace Hopper, BullSequana XH3000 y refrigeración líquida directa de alta eficiencia.

En operación nominal, se estima un consumo medio alrededor de 11 MW y un máximo que puede alcanzar ~17 MW, lo que obliga a una ingeniería térmica impecable y a modelos de operación que prioricen la eficiencia. La instalación usa energía renovable y contempla la reutilización del calor residual para calentar edificios del campus.

Refrigeración líquida y plataforma BullSequana XH3000

JUPITER adopta la arquitectura BullSequana XH3000 de Eviden con refrigeración líquida directa (DLC). El agua caliente extrae el calor de los componentes críticos, reduciendo de forma drástica el gasto energético asociado a la climatización. Este diseño no solo recorta consumo frente a la refrigeración por aire, también permite aprovechar el calor expulsado.

La refrigeración DLC, combinada con la alta densidad de cómputo de los GH200 y la integración CPU+GPU, evita entrenamientos a «cámara lenta» por estrangulamientos térmicos. El equilibrio entre potencia bruta y eficiencia térmica es parte del secreto del liderazgo en la clasificación Green500.

La pila de gestión también es un elemento diferencial: todos los componentes de hardware y software se orquestan mediante la «pila JUPITER», una combinación de ParaStation Modulo (ParTec), SMC xScale (Eviden) y software del Jülich Supercomputing Centre (JSC). Esta capa unificada mejora la administrabilidad, la resiliencia y el rendimiento operativo del sistema.

Software, herramientas y sistemas operativos

Para maximizar el valor científico, JUPITER se apoya en entornos Linux personalizados y en el ecosistema de NVIDIA para IA y HPC. Se hace uso de NVIDIA AI Enterprise, una suite de software optimizada para el desarrollo, despliegue y operación de modelos avanzados. La integración de pila software-hardware es clave para exprimir la computación acelerada sin penalizaciones de compatibilidad.

Esta base de software se combina con librerías, compiladores y herramientas de profiling de última generación, además de frameworks de IA listos para escalar. La meta es que los equipos de investigación dediquen su tiempo a la ciencia, no a pelearse con el entorno de ejecución.

El papel del sistema de desarrollo JEDI

JEDI, el instrumento de desarrollo exascale, actúa como banco de pruebas para la programación eficiente del sistema final. Con un rack BullSequana XH3000 y 24 nodos de cómputo (ampliados posteriormente con otros 24), conectados mediante cuatro conmutadores NVIDIA Quantum‑2, ha servido para afinar códigos y estrategias de optimización. Gracias al programa JUREAP (JUPITER Research and Early Access Program), los equipos tienen acceso temprano a la plataforma.

El hecho de que JEDI comparta hardware con el Booster es determinante: optimizar ahora significa rendimiento inmediato cuando se despliegue el sistema completo. De esta manera, el ‘día 1’ de JUPITER llega con aplicaciones científicas ya preparadas para exprimir la máquina.

Aplicaciones científicas y de IA: casos concretos

Hay un abanico amplio de proyectos seleccionados que ilustran lo que JUPITER puede hacer. En clima, el ECMWF trabaja en simulaciones de resolución kilométrica para fenómenos extremos y el proyecto Destination Earth (gemelo digital del planeta). Estas simulaciones requieren escalabilidad masiva y abren la puerta a pronósticos mucho más finos.

En IA, el consorcio TrustLLM entrenará modelos de lenguaje multilingües europeos para aplicaciones industriales y científicas, con especial atención al rendimiento y a la cobertura lingüística. La meta es impulsar una IA europea competitiva, abierta y enfocada a necesidades reales del tejido productivo.

En neurociencia, herramientas como el simulador Arbor permitirán modelar neuronas a nivel subcelular y explorar patologías como el Alzheimer con precisión inédita. La capacidad de simular redes neuronales biológicas detalladas puede acelerar terapias y diagnósticos.

En computación cuántica, JUPITER se utilizará para validar algoritmos y simuladores, en paralelo con estudios de superordenadores cuánticos como Jiuzhang, con el objetivo de rebasar marcas de simulación clásicas por encima de 50 qubits y avanzar hacia la ventaja cuántica práctica. Este enfoque híbrido (HPC + cuántica) es estratégico para el futuro de la computación.

Otros campos que ya preparan cargas para JUPITER incluyen astrofísica (reionización cósmica con el Instituto Max Planck), física de partículas (cálculos de precisión sobre el muón desde la Universidad de Wuppertal), nuevos materiales y modelos de vídeo avanzados (compresión y difusión desde la Universidad de Múnich), además de modelos multimodales a gran escala (Universidad de Lisboa). La lista crece con rapidez, cubriendo desde ciencia básica hasta ingeniería aplicada.

Comparativa internacional y relevancia estratégica

En 2022, Frontier (EE. UU.) se convirtió en el primer superordenador en superar oficialmente la exaescala en HPL. Más tarde se unieron El Capitan y Aurora, consolidando la posición estadounidense. En China, el panorama es opaco. Con JUPITER, Europa mueve ficha y logra un punto de apoyo propio en la liga exaescala.

Que el sistema ocupe el cuarto puesto del mundo y lidere la eficiencia energética con JEDI no es un titular menor: es una declaración de intenciones sobre cómo quiere competir Europa, maximizando potencia sin disparar el consumo. Además, el suministro de energía verde y la reutilización térmica refuerzan el compromiso con la sostenibilidad.

El mensaje político y económico es claro: menos dependencia de recursos externos, talento y conocimiento desarrollados en casa y una plataforma centralizada para que universidades, centros y empresas europeas trabajen a primer nivel. La soberanía tecnológica deja de ser un eslogan para materializarse en hardware y software de punta.

Especificaciones destacadas y cifras que impresionan

Algunos datos técnicos ayudan a dimensionar el proyecto: cerca de 24.000 superchips GH200 en el Booster, unas 51.000 conexiones en red con InfiniBand Quantum‑2, instalación en ~50 contenedores, almacenamiento cercano a un exabyte y un consumo máximo estimado de 17 MW. En capacidad de datos, el sistema puede mover más de 2.000 TB/s, con más de 260 km de cableado desplegado.

Físicamente, el centro ocupa aproximadamente el equivalente a cuatro pistas de tenis y ha sido pensado para crecer. El diseño modular facilita integrar nuevas generaciones de hardware sin reconstruir desde cero. Esta visión ‘future‑proof’ es clave en un campo donde el hardware caduca rápido.

Acceso para investigadores y calendario operativo

El acceso al sistema se articula mediante convocatorias dos veces al año. Actualmente hay decenas de proyectos en marcha; en distintas comunicaciones se mencionan ya 30 proyectos activos y también se ha hablado de más de un centenar de seleccionados para las primeras oleadas. La vida útil prevista es de al menos seis años, garantizando continuidad a medio plazo.

La instalación definitiva se realiza por etapas a lo largo del segundo semestre antes de su apertura generalizada. En paralelo, el programa de acceso temprano permite ir afinando software, librerías y flujos de trabajo sobre JEDI para que el arranque sea fluido. El objetivo es llegar al servicio de producción con un ecosistema maduro desde el primer día.

Gobernanza, seguridad y sostenibilidad operativa

Con infraestructuras de esta envergadura, la ciberseguridad es prioritaria: se gestiona la protección de datos sensibles, integridad de modelos y resiliencia frente a amenazas. Aunque no se han reportado vulnerabilidades específicas del stack de JUPITER, es esencial vigilar CVEs del ecosistema NVIDIA y del software de base.

La sostenibilidad energética es el otro gran frente. Los centros de datos ya consumen una fracción significativa de la electricidad nacional en países como Alemania (en torno al 4%). Por ello, JUPITER nace con refrigeración líquida, contratos de energía verde y reutilización de calor. Operar a exaescala sin una estrategia de eficiencia y circularidad energética no es viable.

En IA, la calidad y diversidad de datos importan tanto como la potencia de cómputo. A medida que los modelos crecen, Europa pone el acento en la inclusión, la mitigación de sesgos y la auditabilidad. El objetivo es que el músculo de cálculo se traduzca en resultados robustos, explicables y útiles.

Voces del ecosistema: industria y centros de investigación

Desde Eviden, se subraya el orgullo por suministrar el primer exascale europeo sobre BullSequana XH3000, y el compromiso histórico con la soberanía tecnológica del continente. ParTec destaca su dMSA como palanca para eficiencia y velocidad en algoritmos de IA sofisticados. Ambos enfatizan que el contrato valida la competitividad de los proveedores europeos de supercomputación.

NVIDIA remarca su colaboración con EuroHPC, Eviden y la comunidad científica europea para proporcionar a JUPITER la potencia de la computación acelerada en IA y HPC. En palabras de sus responsables, se trata de abrir nuevos caminos en clima, ciencia de materiales, descubrimientos farmacéuticos, ingeniería y tecnologías cuánticas. SiPearl, por su lado, celebra que Rhea1 sea el motor del módulo de cómputo general, reforzando el objetivo de soberanía tecnológica y eficiencia energética.

Dónde encaja JUPITER dentro de EuroHPC

JUPITER no funciona en el vacío: forma parte de la red EuroHPC junto a máquinas punteras distribuidas por el continente. Este entramado permite repartir cargas, compartir experiencia y elevar el listón conjunto de la comunidad científica europea. Para investigadores y empresas, significa acceso estandarizado a recursos de primer nivel sin salir de Europa.

El acrónimo JUPITER responde a «Joint Undertaking Pioneer for Innovative and Transformative Exascale Research», toda una declaración del papel que se le asigna dentro de la empresa común EuroHPC. La ambición es convertirlo en eje transformador de la investigación exascale, no solo en un ‘top’ de rankings.

En definitiva, JUPITER aporta músculo, pero también método: arquitectura modular, eficiencia energética, acceso gobernado y un ecosistema europeo decidido a competir en IA, clima, neurociencia, física de altas energías y más. Con su entrada en producción, Europa se dota por fin de una plataforma para pensar y construir en grande.

JUPITER emerge como un proyecto que combina potencia exaescala, gestión inteligente de la energía, arquitectura flexible y un catálogo real de casos de uso científicos e industriales. La conjunción de hardware GH200, red Quantum‑2, procesadores Rhea1, refrigeración BullSequana XH3000 y la pila de software afinada sitúan a Europa donde quería estar: en la primera línea de la supercomputación.